サム・バンクマン - フリード被告、102ページの書類で詐欺罪の有罪判決を不服とし、司法の偏見と不公正裁判を訴える

破綻した暗号取引所FTXの創設者であるサム・バンクマン・フライドは、まだ自分の話を終えていない。

XingChi

XingChi

2012年12月初旬のある日、アメリカのスキーリゾート、レイクタホのカジノホテルで秘密のオークションが行われていた。

カリフォルニア州とネバダ州の州境に位置するレイクタホは、北米最大の高山湖で、サファイアブルーの湖面と最高級のトレイルがあり、『ゴッドファーザー2』が撮影され、マーク・トウェインが滞在した場所であり、サンフランシスコのベイエリアから200マイル(約8.2km)強の距離にあることから、しばしば「シリコンバレーの裏庭」と呼ばれている。「ザッカーバーグやラリー・エリソンをはじめとする大物たちも、山を囲んで豪邸を建てるためにこの地を訪れている。

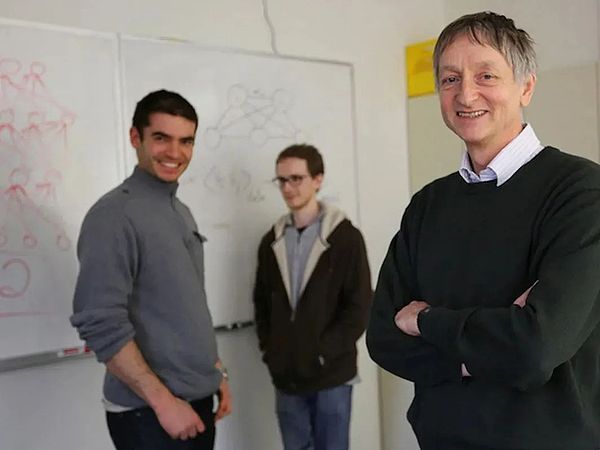

極秘入札の対象となったのは、トロント大学のジェフリー・ヒントン教授と2人の学生によって設立された、従業員わずか3人の設立1ヶ月のDNNresearch社だった。

同社は具体的な製品や資産を持っていませんが、競売相手の身元がその重みを暗示しています - 4人の買い手は、グーグル、マイクロソフト、ディープマインド、バイドゥです。

ハラーズ・ホテル(Harrah's Hotel)、レイクタウン(Lake Museum)の秘密入札を開催。ハラーズ・ホテル、レイクタホ、2012年

青白く痩せ、腰の椎間板に痛みを抱えるヒントン氏は、ホテルの703号室の床に座り、1200万ドルから始まる入札のルールを決めた。最低100万ドルからの入札。

数時間後、入札者は4400万ドルまで価格を吊り上げた。

興味深いことに、4400万ドルの入札の出所のひとつは、半年前にグーグルからもたらされたものだった。

2012年6月、グーグルの研究部門であるグーグル・ブレインは、キャット・ニューロン・プロジェクト(または「グーグル・キャット」)の調査結果を公表した。スタンフォード大学からグーグルに飛び込み、グーグルの伝説的人物であるジェフ・ディーンを招き入れ、グーグル創業者のラリー・ペイジに多額の予算を要求したアンドリュー・ンによって始められた。

グーグル・キャット・プロジェクトはニューラルネットワークを構築し、YouTubeから大量の動画をダウンロードし、タグを付けずに放置し、モデルに猫の特徴を観察させ、学習させた。(GPUは複雑すぎてコストがかかるという理由で社内では却下された)、最終的に74.8%の認識精度を達成した。この数字は業界に衝撃を与えた。

エンダ・ウーは自身のインターネット教育プロジェクトに取り組むため、プロジェクトの終了間際にグーグル・キャット・プロジェクトを退職したが、退職前にヒントンを会社に推薦し、彼の仕事を引き継がせた。その誘いを前に、ヒントンは大学を辞めず、グーグルに「ひと夏だけ」行くつもりだと言った。当時64歳だったヒントンは、グーグルの特別な採用規則により、グーグル史上最高齢のサマーインターンとなった。

ヒントン氏は80年代からAIの最前線に立ち、教授としてディープラーニング(Ernst Wu氏ら)の分野を熟知している。そのため、グーグル・キャット・プロジェクトの技術的な詳細を知ったとき、彼はすぐにその成功の裏に隠された欠陥を見抜いた。"彼らは間違ったニューラルネットワークを実行し、間違ったコンピューティング・パワーを使用した"。

同じタスクでも、ヒントン氏はもっとうまくできると考えた。だから、短い「インターンシップ」の後、彼はすぐに行動に移した。

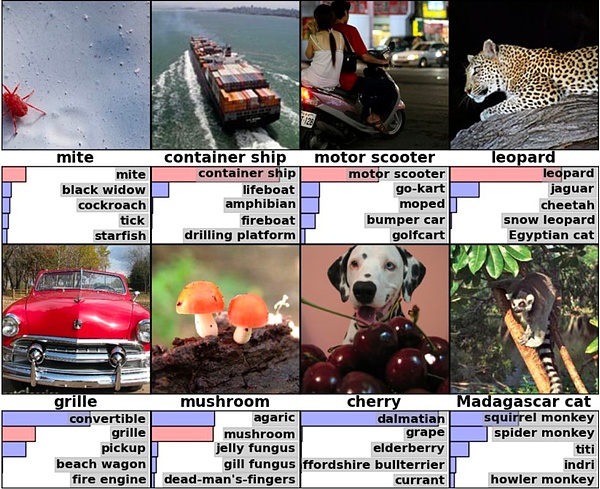

ヒントン氏は、ソ連生まれのユダヤ人で数学の才能があるイリヤ・スーツケバーと、エンジニアリングの実装を専門とするアレックス・クリシェフスキーという2人の学生を引き入れた。この3人は緊密に協力して新しいニューラルネットワークを作り上げ、すぐにImageNet画像認識コンテスト(ILSVRC)に応募し、84%という驚異的な認識精度で優勝した。

2012年10月、ヒントン氏のチームは、フィレンツェで開催されたコンピューター・ビジョン会議で、優勝したアルゴリズム「AlexNet」を発表しました。 16,000個のCPUを使用したGoogle Catに比べ、AlexNetはわずか4個のNVIDIA GPUを使用しただけで、学界と産業界は完全に圧倒され、AlexNetの論文はコンピュータサイエンスの歴史の中で最も影響力のある論文のひとつとなり、今では12万回以上引用され、Google Catはすぐに忘れ去られてしまいました。

DNNresearchの3人組<。/p>

第1回ImageNetコンペティションで優勝したユー・カイは、論文を読んで興奮し、「感電したみたい」だったという。ユー・カイは江西省生まれのディープラーニングの専門家で、NECからバイドゥに飛び込んだばかりだった。彼はすぐにシントンにメールを書き、協力のアイデアを表明した。シントンは快諾し、単純に自分と2人の学生を1つの会社にパッケージ化し、オークションで入札するバイヤーを募った。そして冒頭のシーンがあった。

オークションにハンマーが落ちた後、より大きなレースが繰り広げられた。グーグルが勝利の波に乗り、2014年にディープマインドが「世界の英雄が袋叩きに」、2016年にディープマインドがAlphaGoを立ち上げ、世界に衝撃を与えた。Googleの百度に失われたAI、数千億ドルの投資の10年に賭けることを決定され、ユカイは百度を助けるために、後に呉エンダを招待し、彼は数年後にホライズンを設立するために残しました。

マイクロソフトは、表面的には遅かったが、最終的に最大の賞を獲得した。グーグルは2023年まで在籍し、その間にACMチューリング賞を受賞した。もちろん、グーグルの4400万ドル(ヒントン氏の取り分は40%)に比べれば、チューリング賞の賞金100万ドルは小銭にしか見えない。

6月のGoogle Catから、10月のAlexNet論文、12月のレイクタホ入札まで、ディープラーニングのブーム、GPUとNvidiaの台頭、アルジャーノンの台頭など、AIの波の待ち伏せがほぼすべて敷かれた半年間だった。Nvidiaの台頭、AlphaGoの覇権、Transformerの誕生、ChatGPTの出現......シリコン系ブームの壮大なムーブメントの最初の音符が奏でられた。

2012年の6月から12月までの180日間、炭素をベースとする人類の運命は永遠に変わり、それに気づいた人はほとんどいなかった。

そのごく少数の中に、スタンフォード大学教授のフェイフェイ・リーがいた。

フェイフェイ・リーは出産したばかりで、2012年にシントンのImageNetコンペティションへの参加結果が出たときはまだ産休中だったが、シントンのチームのエラー率を見て、歴史が書き換えられようとしていることに気づいた。イメージネット・チャレンジの創設者として、彼女はその日の最終便を買ってフィレンツェに向かい、個人的にヒントン氏のチームに賞を授与した[2]。

北京で生まれ、成都で育ったフェイフェイ・リーは、16歳のときに両親とともにアメリカに移住し、プリンストン大学を卒業する間、コインランドリーで働きました。

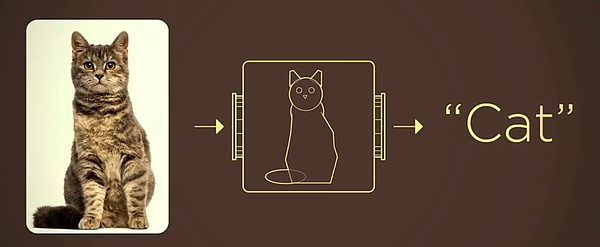

例えば、カメラが猫の写真を撮るとき、センサーを通して光をピクセルに変換しているだけで、写っているものが猫なのか犬なのかはわからない。カメラを人間の目に例えるなら、コンピュータ・ビジョンが解決する問題は、カメラに人間の脳を搭載することだ。

これを行う伝統的な方法は、現実世界のものを数学的モデルに抽象化することです。例えば、猫の特徴を単純な幾何学的形状に抽象化することで、機械認識の難易度を劇的に下げることができます。

画像引用:Feifei Li氏のTED講演

しかし、このような考え方は非常に限定的である。

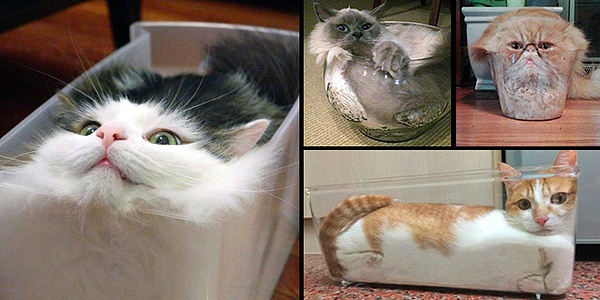

コンピューターに「液体の猫」を認識させようとする探求は、ジェフ・ヒントンやヤン・ルクンといったディープラーニングの先駆者たちによって、1980年代から続けられてきた。しかし、アルゴリズムには常にボトルネックがある。優れたアルゴリズムにはそれを駆動する十分な電力が不足しており、必要な電力が小さいアルゴリズムは認識精度を満たすことが難しく、産業化できないのだ。

「リキッドキャット」の問題を解決できなければ、ディープラーニングのセクシーさは理論レベルにとどまるしかなく、自動運転、医療画像、正確な広告プッシュといった産業化されたシナリオは、宙に浮いた城にすぎない。はコンピュータが物事を認識する方法を決定しますが、アルゴリズムはそれを駆動するのに十分な大きさの計算力を必要とします。同時に、アルゴリズムの強化には大規模で高品質なデータが必要です。

2000年以降、チップの処理能力の急速な進歩に伴い、演算のボトルネックが徐々に解消されていたにもかかわらず、主流の学術界ではディープラーニングへの関心はまだほとんどありませんでした。フェイフェイ・リーは、ボトルネックはアルゴリズム自体の精度ではなく、高品質で大規模なデータセットの不足かもしれないと気づいた。

フェイフェイ・リーは、3歳の子供が世界について学習する方法に着想を得た。例えば猫を例にとると、子供は大人の指導の下、何度も何度も猫と出会い、徐々に猫の意味を把握する。子どもの目をカメラに見立てると、目を丸くする1回がシャッターを押す1回に相当し、3歳児は何億枚もの写真を撮っていることになる。

このアプローチをコンピューターに当てはめると、コンピューターに猫やその他の動物の写真を見せ、それぞれの写真の裏に正解が書かれているとする。コンピュータは絵を見るたびに、裏に書いてある答えをチェックする。そうすれば、十分な回数が与えられれば、コンピューターは子供のように猫の意味を把握できるようになるかもしれない。

解決しなければならない唯一の問題は、答えが書いてあるたくさんの絵をどこで見つけることができるか?

2016年に中国を訪れた李菲菲。2016年に中国を訪れ、Google AI中国センターの設立を発表した

これを機にImageNetが誕生した。当時、最大のデータセットであったPASCALでさえ、4つのカテゴリーで合計1,578枚の画像しかなかった。Feifei Liの目標は、数百のカテゴリー、合計数千万枚の画像を持つデータセットを作ることだった。

アマゾンのクラウドソーシング・プラットフォームを利用し、フェイフェイ・リーのチームは手作業によるアノテーションの膨大な作業量を解決し、2009年に320万枚の画像を含むImageNetデータセットが誕生した。画像データセットがあれば、それを基にアルゴリズムを学習させることができ、コンピューターは認識能力を向上させることができる。しかし、3歳児の何億枚もの写真に比べれば、320万枚はまだ少なすぎる。

データセットを拡大し続けるために、フェイフェイ・リーは、業界でよく行われている画像認識コンテストを開催することにした。参加者が独自のアルゴリズムを持ち寄り、データセットの写真を認識させ、最も高い精度のものが優勝するというものだ。しかし、当時はディープラーニングのルートは主流ではなく、ImageNetはヨーロッパで有名なイベントであるPASCALと「提携」することで、かろうじて参加者数を補うことしかできなかった。

2012年までに、ImageNetの画像数は1,000カテゴリ、合計1,500万枚にまで拡大し、Feifei Liはこのデータ不足を補うのに6年を要した。しかし、ILSVRCの最高の結果も25%のエラー率であり、アルゴリズムや演算能力の面ではまだ十分な説得力を示していなかった。

そこでHinton氏がAlexNetと2枚のGTX580グラフィックカードを持って登場しました。

Hintonチームの優勝アルゴリズムであるAlexNetは、Convolutional Neural Networks (CNN)と呼ばれる方法を使用しています。ニューラルネットワーク(CNN)。「ニューラルネットワーク」は、人工知能の分野では非常に頻度の高い用語で、人間の脳の働き方からその名前と構造を取った機械学習の一分野です。

人間が物体を認識するプロセスは、瞳孔がピクセルを取り込み、大脳皮質がエッジと方向によって最初に処理し、次に脳が一定の抽象化によって決定する。その結果、人間の脳はわずかな特徴に基づいて物体を識別することができる。

たとえば、顔全体を表示しなくても、ほとんどの人は下の画像の人物が誰であるかを認識できる。

ニューラルネットワークは、実際に人間の脳の認識メカニズムをシミュレートしており、理論的には、知的コンピューターは人間の脳が達成できることを達成できる。SVM、決定木、ランダムフォレストなどの手法と比較すると、人間の脳のシミュレーションだけが、「液体猫」や「半分トランプ」のような構造化されていないデータを扱うことができる。

しかし問題は、人間の脳には約1000億のニューロンがあり、ニューロン間には何兆ものノード(=シナプス)があり、信じられないほど複雑なネットワークを形成しているということだ。ちなみに、16,000個のCPUを搭載したグーグル・キャットは、内部に10億個のノードを持ち、当時すでに最も複雑なコンピュータ・システムだった。

このため、「AIの父」と呼ばれるマーヴィン・ミンスキーでさえ、このような路線を良しとせず、2007年に新著『The Emotion Machine』を出版した際も、ミンスキーは次のように述べている。2007年の著書『The Emotion Machine』でも、ミンスキーはニューラルネットワークに悲観的な見方を示していた。人工ニューラルネットワークに対する機械学習コミュニティの主流派の長年の否定的な態度を変えるために、ヒントン氏は単純にディープラーニングと改名した。

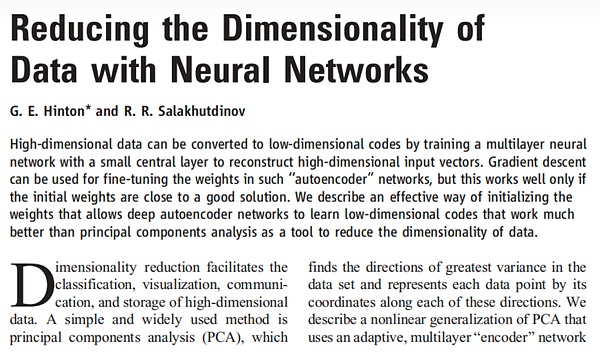

2006年、ヒントン氏はサイエンス誌に、ディープ・ビリーフ・ニューラル・ネットワーク(DBNN)の概念を導入し、多層ディープ・ニューラル・ネットワークの訓練方法を示した論文を発表した。これはディープラーニングにおける大きなブレークスルーと考えられている。しかし、Hintonの方法は多くの計算能力とデータを必要とするため、実際には実現が難しい。

ディープラーニングはアルゴリズムに常にデータを供給する必要があり、イメージネットが登場するまでは、当時のデータセットは小さすぎた。

ImageNetの最初の2つのエディションでは、機械学習への他のルートを使用するチームが見られましたが、かなり平凡な結果でした。AlexNetは、Sinton氏のチームが2012年に使用した畳み込みニューラルネットワークで、ディープラーニングのパイオニアであるYann LeCun氏の1998年のLeNetを改良したものです。

同時に、畳み込みカーネルは入力画像上をスライドするので、検出されるオブジェクトの位置に関係なく同じ特徴が検出され、計算量が大幅に削減される。

AlexNetは、従来のレイヤーごとの教師なしアプローチを放棄し、入力値の教師あり学習を行うことで、古典的な畳み込みニューラルネットワークの構造を構築し、精度を大幅に向上させています。

例えば、下の右下の画像では、アレックスネットは実際には正解(マダガスカルネコ)を認識していませんが、マダガスカルネコのように木に登る小型の哺乳類をリストアップしています。これは、アルゴリズムがオブジェクト自体を認識するだけでなく、他のオブジェクトに基づいて推測していることを意味します[5].

画像引用:AlexNet論文

また、6000万個のパラメータと65万個のニューロンを持つAlexNetは、ImageNetデータセットを完全に訓練するために少なくとも26兆2000億回の浮動小数点演算を必要とするという事実に、業界は胸をなでおろしている。しかし、Hintonチームは、1週間のトレーニングの間、わずか2枚のNVIDIA GTX 580グラフィックカードを使用しただけでした。

チームHintonの勝利後、最も恥をかいたのはどうやらGoogleのようです。align: left;">Googleは内部でもImageNetデータセットをテストしたと言われていますが、認識精度はHintonチームに大きく遅れをとっていました。グーグルには、検索やYouTubeから得られる膨大なデータだけでなく、業界の追随を許さないハードウェアリソースがあり、グーグル・ブレインがリーダーの特別なお気に入りであることを考えると、この結果は明らかに説得力に欠ける。

この大きなコントラストがなければ、ディープラーニングが業界を震撼させ、いつまで経っても受け入れられ、人気を得ることはなかっただろう。業界は、Hintonチームがたった4つのGPUを使用してこのような良い結果を達成し、その後演算能力がボトルネックにならなくなったという事実に胸をなでおろしている。

アルゴリズムは、出力を得るためにニューラルネットワークの各層の関数とパラメーターを重ねるように訓練されており、GPUは偶然にも非常に強力な並列計算能力を持っている。これはEnda Wuによる2009年の論文で実証されましたが、彼とJeff DeanがGoogle Catを運営していたときはまだCPUを使用しており、Jeff Deanは後に200万ドルの設備を発注しましたが、それでもGPUは含まれていませんでした[6]。

Shington氏は、ディープラーニングのためのGPUの価値に早くから気づいていた数少ない人物の1人でしたが、AlexNetがヒットする前は、テック企業は一般的にGPUで何をすればいいのかまったくわかっていませんでした。

2009年、ヒントン氏は音声認識プロジェクトの短期技術顧問としてマイクロソフトに招かれ、プロジェクトリーダーのデン・リー氏に、エヌビディアの最高級GPUとそれに付随するサーバーを購入すべきだと提案した。このアイデアはDeng Liによって支持されましたが、Deng Liの上司であるAlex Aceroは、「GPUはゲームをするためのものであり、AI研究のためのものではない」と、純粋に軽薄なものだと考えていました[6]。

デン・リー

興味深いことに、Alex Aceroは後にAppleに移籍し、Appleの音声認識ソフトウェアであるSiriを担当していました。結局のところ、我々は裕福なカナダの大学であり、資金不足のソフトウェア販売業者ではないのだ。

しかし、2012年のImageNetチャレンジの後、すべてのAI学者とハイテク企業はGPUに対して180度方向転換した。2014年、GoogleのGoogLeNetは、参加チームすべてのGPUが使用された年である、NVIDIA GPU以外を使用することなく、93%の認識精度でタイトルを獲得した。この年は、参加チームすべてのGPUが使用されました。

この挑戦が「ビッグバンの瞬間」と見なされている理由は、アルゴリズム、演算、データというディープラーニングのトリオの欠点がすべて補われ、産業化は時間の問題だからだ。産業化は時間の問題だ。

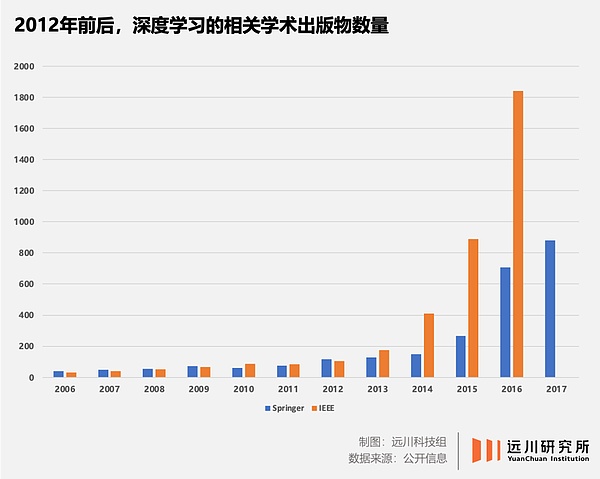

アルゴリズムレベルでは、ヒントンチームアレックス・ネットに関する論文を発表し、コンピュータサイエンスで最も引用された論文のひとつとなった。100の異なる技術ラインがあったものが、ディープラーニング1つに支配され、コンピュータビジョン研究のほとんどがニューラルネットワークに変わった。strong>ニューラルネットワークに変わっている。

演算のレベルでは、GPUは優れた並列コンピューティングです。能力とディープラーニング 適応性の高さは業界ですぐに認められ、6年前にCUDAを敷設し始めたNVIDIAは最大の勝者となりました。

データレベルでは、ImageNetが画像処理アルゴリズムの試金石となりました。アルゴリズムの試金石であり、高品質なデータセットにより、アルゴリズムによる認識精度は日に日に高まっています。2017年の最後のチャレンジでは、優勝したアルゴリズムは97.3%の認識精度を達成し、人間を上回りました。

2012年10月下旬、ヒントンの学生アレックス・クリシェフスキーがイタリアのフィレンツェで開催されたコンピュータビジョン会議で論文を発表した。1つはNVIDIAのグラフィックスカードをすべて買い占めること、もう1つは大学のAI研究者をすべて引き抜くことでした。

レイク・タホの4,400万ドルは、世界のディープラーニングの神々を再評価した。

公開されている情報では、当時まだバイドゥにいたカイ・ユーは、確かに最初にヒントンを掘りに来た。

当時、ユー・カイはバイドゥのマルチメディア部門の責任者で、バイドゥのディープラーニング研究所(IDL)の前身だった。ユカイからメールを受け取ったヒントンは、すぐに一緒に仕事をすることに同意すると返信し、ついでにバイドゥに資金を提供してほしいという要望を出した。

ユカイはロビン・リーに指示を仰ぎ、ロビン・リーは快諾した。

ユカイはロビン・リーに指示を仰ぎ、ロビン・リーは快諾した。

ユカイが「大丈夫だ」と答えた後、業界の飢餓感を察したのか、ヒントンはユカイに「グーグルなど、他の企業に頼んでも構わないか」と尋ねた。大きなチャンスに気づかせてしまった。でも、寛大な気持ちで、気にしないと言うのが精一杯でした」

。

結局、バイドゥはチーム・ヒントンに敗れた。しかし、ユカイはこの結果を覚悟していなかったわけではない。なぜなら、一方では、シントンは深刻な椎間板の健康問題を抱えており、運転することができない、飛ぶことができない、それは中国の太平洋を横断する旅に耐えることは困難である;他方では、シントンは、Googleで働くあまりにも多くの学生や友人を持っており、深いつながりの双方は、他の3つは、本質的に入札の同行である。

AlexNetのインパクトがまだ学術界に集中しているのであれば、レイクタホでの秘密のオークションは完全に業界に衝撃を与えました!というのも、グーグルは世界中のテック企業の鼻の下で4400万ドルを費やしたからだ!設立から1カ月も経っておらず、製品も収益もなく、たった3人の従業員と数本の論文しかない会社のために。

最も刺激を受けたのは明らかにバイドゥ(百度)で、オークションにもかかわらず、グーグルがどんな犠牲を払ってでもディープラーニングに投資している様子を目の当たりにし、バイドゥはディープラーニングに投資する決意を固め、2013年1月の年次総会でディープラーニングの研究所であるIDLの設立を発表した。

2014年5月、バイドゥは次のように述べた。2014年5月、バイドゥは「グーグル・キャット」プロジェクトの中心人物であるウー・エンダを招聘し、2017年1月にはマイクロソフトを退社したルー・チーを招聘した。

そしてグーグルはヒントンチームを引き受けた後、2014年にその年のライバルであったディープマインドを6億ドルで買収した。

当時、マスクはグーグル創業者にディープマインドへの自身の投資を勧めていた。

当時、マスク氏はディープマインドへの自身の投資をグーグル創業者に勧め、ヒントン氏を一緒にロンドンに連れて行き、色を確認できるようにするため、グーグルチームも特別にプライベート機をチャーターし、ヒントン氏が飛行機に座れないという問題を解決するために、座席を変形させた[6]。

「英国人選手「ディープマインドが囲碁でリー・セドルを破る(2016年)

ディープマインドをめぐってグーグルと競合したのはフェイスブックだった。ディープマインドがグーグルに移ったとき、ザッカーバーグはディープマインドを買収することにした。ザッカーバーグは、ディープマインドがグーグルの手に渡ると、"ディープラーニング三国志 "の一人であるヤン・リクンを引き抜こうとした。ザッカーバーグは楊立勲を傘下に収めるために、ニューヨークにAIラボを設置すること、ラボと製品チームを完全に分離すること、楊立勲がニューヨーク大学で働き続けることを認めることなど、多くの厳しい条件を彼に約束した。

2012年のImageNetチャレンジの後、AI分野は非常に深刻な「需要と供給のミスマッチ」問題に直面している。"問題:

推薦アルゴリズム、画像認識、自律走行といった産業化された空間が急速に開放されたことにより、人材に対する需要は急増している。

しかし、長期的な楽観主義の欠如により、深層学習研究者は非常に小さなサークルであり、トップクラスの学者は両手で数えられるほどで、供給は深刻に不足しています。

この場合、ハングリーなテック企業は「人材先物」を買うしかない。教授を掘り起こし、彼らが学生を連れてくるのを待つのだ。

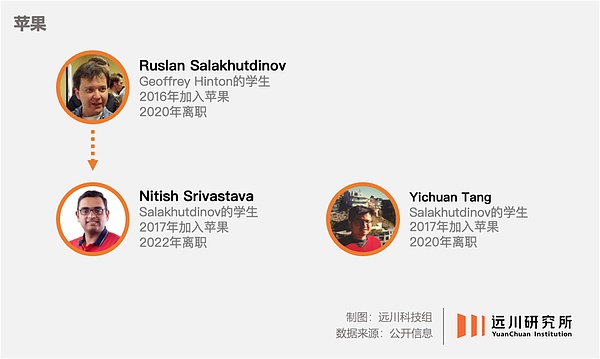

リクン・ヤンがフェイスブックに入社した後、6人の教え子が彼の後を追って就職した。自動車製造のバンドワゴンに飛び乗ろうとしているアップルは、ヒントンの教え子であるルスラン・サラフチノフをアップル初のAI担当ディレクターに引き抜いた。ヘッジファンドのシタデルもこのラッシュに加わり、ヒントンと共に音声認識の研究に取り組み、後にマイクロソフトの代理人として秘密裏に入札合戦を繰り広げたデン・リーを引き抜いた。

顔認識、機械翻訳、自律走行といった産業化されたシナリオは1日に何千マイルも移動し、GPUの注文はサンタクララのNVIDIA本社に雪だるま式に押し寄せ、AIの理論的建造物は日々注ぎ込まれている。

2017年、グーグルは論文「Attention is all you need」でトランスフォーマーモデルを提唱し、今日のビッグモデルの時代を切り開いた。その数年後、どこからともなくChatGPTが現れた。

そしてこれらすべての誕生は、2012年のImageNetチャレンジまで遡ることができる。

では、2012年の「ビッグバンの瞬間」に至る歴史的プロセスは何年だったのだろうか?

答えは2006年です。

素晴らしい

2006年以前のディープラーニングの現状は、ケルビン男爵の有名な言葉に要約することができます。晴れ渡った空の下には、小さな暗雲が3つ浮かんでいるだけだった。

アルゴリズム、算数、データです。

前述の通り、ディープラーニングは人間の脳のメカニズムを模倣しているため、理論的には完璧なソリューションだ。しかし問題は、ディープラーニングが必要とするデータと、ディープラーニングが必要とする演算の両方が、当時はSF的な規模であったことだ。

しかし、2006年にそれを変える3つの出来事が起こった。

シントンと学生のサラクフトディノフ(後にアップル社に進んだのと同じ)は、次のような論文をScience誌に発表した。Scienceは、ニューラルネットワークによるデータの次元の削減という論文を発表し、勾配の消失という問題に対する効果的な解決策を初めて提示し、アルゴリズムレベルで大きな前進を遂げた。.Salakhutdinov (左端)とHinton (中央)、2016年

スタンフォード大学のFeifei Liは、データの規模が現実世界を再現するのが難しい場合、どんなに優れたアルゴリズムでも「人間の脳をシミュレート」する訓練はできないことに気づいた。人間の脳」効果だ。そこで彼女は、ImageNetデータセットの構築を始めた。

NVIDIAのテスラ・アーキテクチャ上の新しいGPUに続いて、CUDAが登場した。

この3つの出来事は、ディープラーニングを覆う3つの暗雲を吹き飛ばし、2012年のImageNetチャレンジに集結し、ハイテク産業と人類社会全体の運命を完全に塗り替えた。

しかし2006年当時、ジェフ・ヒントンも、フェイフェイ・リーも、ジェンスン・フアンも、ディープラーニングの開発を推し進めた他の誰ひとりとして、彼らが果たした役割はおろか、それ以降AIが享受してきたブームを予測することもできなかったことは明らかだった。

ヒントン氏とサラクフチノフ氏。Salakhutdinovの論文

今日に至るまで、AIによる第4次産業革命が再び幕を開け、AIの進化は加速する一方だ。どれほどの刺激が得られるかといえば、次の3点以上ではないかもしれない。

1.産業の厚みがイノベーションの高さを決める。

ChatGPTが登場したとき、「なぜまたアメリカなんだ」という声がたくさんありました。しかし、時系列で見てみると、トランジスタや集積回路から、Unixやx86アーキテクチャ、そして現在の機械学習まで、米国の学術界と産業界はほとんどすべての面でトップランナーであることがわかります。

これは、米国の「産業空洞化」の議論は尽きないが、コンピュータサイエンス産業の中核であるソフトウェアが、他の経済圏に「国外流出」したことがないだけでなく、「他の経済圏に流出」したことがないからである。"他の経済に、逆に、利点はますます大きくなっている。これまで、70人以上のACMチューリング賞受賞者がいますが、そのほとんどがアメリカ人です。

ウ・エンダが「グーグル・キャット」プロジェクトで協力するためにグーグルを選んだのは、アルゴリズム学習に必要なデータと演算をグーグルだけが持っていることが大きな理由であり、これはグーグルの強い収益性に基づいている。グーグルの強い収益力の根拠。これが業界の厚みのメリットであり、人材、投資、イノベーションが業界の高みに近づくことになる。

中国は自国の産業においても、この「厚みの優位性」を発揮している。現在、最も典型的なのは新エネルギー自動車で、一方では、欧州の自動車会社がチャーター便で中国の自動車ショーに行き、新勢力を崇拝し、他方では、日本の自動車会社の幹部が頻繁にBYDに飛び乗った。明らかに、深センで社会保障を支払うことができます図だけではありません。

2.技術分野が最先端であればあるほど、人材の重要性は高まる。

グーグルが4400万ドルを投じてまでヒントン氏の会社を買収した理由は、ディープラーニングのような最先端技術分野では、コンピュータビジョンを専攻する1万人の新入生よりも、一流の学者の役割が大きいことが多いからだ。もし落札者がバイドゥやマイクロソフトだったら、人工知能の開発は書き換えられていたかもしれない。

このような「会社ごと買ってあげる」行動は、実は非常によくあることだ。

このような「会社を丸ごと買ってあげる」という行動は、実はとてもよくあることなのです。重要な段階でのアップルの自己研究チップは、ちなみにPASEMIの小さな会社を買いました。

これはまた、産業競争力がもたらす最大の利点である「人材の誘致」でもある。

ディープラーニング・トリオの誰もアメリカ人ではなく、AlexNetという名前は、ソ連のウクライナで生まれ、イスラエルで育ち、カナダに留学したヒントンの教え子、アレックス・クリシェフスキーに由来する。に留学した。現在も米国のハイテク企業で活躍している多くの中国人の顔は言うまでもない。

3.イノベーションの難しさは、不確実性にどう対処するかだ。

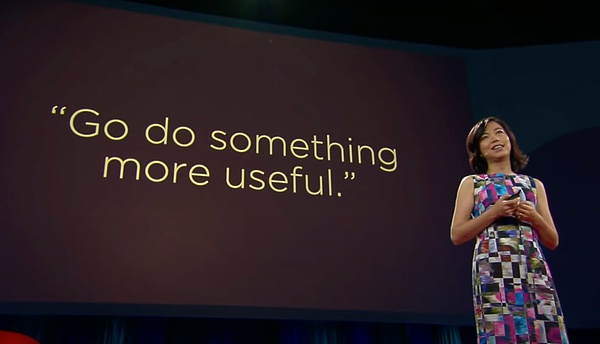

ディープラーニングに反対する「AIの父」マーヴィン・ミンスキーに加え、カリフォルニア大学バークレー校のジテンドラ・マリクもディープラーニングの反対者として有名だ。マリクも、ヒントンも、ウ・エンダも、彼に揶揄された。李菲菲もイメージネットを構築する際にマリクに相談し、マリクは「もっと役に立つことをしなさい」とアドバイスした。

フェイフェイ・リーのテッドトーク

ヤン・リクンは1980年代にニューラルネットワークの研究を始め、ベル研究所時代には同僚とともにANNAと呼ばれるチップを設計し、算数の問題を解決しようとした。その後、AT&Tは業務上のプレッシャーから研究部門に「事業の権限委譲」を求めたが、楊立勲は「私はコンピューター・ビジョンの研究をするだけで、できたらクビにする」と答えた。結局、ハンマーはハンマーで、N+1[6]に言及できてよかった。

どんな最先端技術の研究者も、これがうまくいかなかったらどうしよう、という疑問に直面しなければなりません。

ヒントン氏は、1972年にエジンバラ大学でディープラーニングの最前線に立ち、2012年にImageNetチャレンジが開催されたときには65歳だった。彼がアカデミアに挑んだ長い期間に、どれほどの自信喪失や否定を解消しなければならなかったかは想像に難くない。

今でこそ、2006年のヒントン氏が夜明け前の最後の暗闇に耐え抜いたことがわかるが、学術界や産業界全体はおろか、彼自身もそのことを知らなかっただろう。2007年にiPhoneがリリースされたとき、おそらくほとんどの人が当時のマイクロソフトCEOのバルマーと同じような反応を示したのと同じように、

歴史を運転する人は、しばしば歴史の過程で自分の座標を推測することができません。

偉大さが偉大であるのは、それがどこからともなく現れたときに素晴らしいからではなく、無限の暗闇の中で匿名と不可解さの長い期間に耐えなければならないからである。何年か経って初めて、人々はこれらの基準をたどり、そこにいた星や天才たちに驚嘆することができるのだ。

科学研究の分野に次ぐ分野で、無数の学者が希望の光を垣間見ることなく人生を過ごしてきた。このように、ある意味、ヒントンや他のディープラーニングを実現した人たちは、産業界で成功に次ぐ成功を間接的に後押しするような偉大さを生み出した幸運な人たちなのだ。

資本市場は成功に正当な価格をつけるだろうし、歴史は偉大さを生み出す人々の孤独と汗を記録するだろう。

参考文献

[1] 16,000 Computers Searching for a Cat, The New York Times

[2] Fei-Fei Li's Quest to Make AI Better for Humanity, Wired

[3] Fei-Fei Li's TED Talk

[4] ImageNetの虐殺モデルを21秒で見る、60以上のモデル・アーキテクチャが同じステージに、Heart of the Machine

[5] Convolutional Neural Networks' "Road to Godhood": It all began with AlexNet, NIC

【6】ディープラーニング革命、ケイド・メッツ

【7】AIエンジニアを見つけるために、グーグルとフェイスブックは彼らの教授を雇う。The Information

[8] 30 Years of Innovation in Deep Learning, Long Zhu

[9] Eight Years of ImageNet: Fei-Fei Li and the AI World She's Changed, Quantum Bits

[11]ディープラーニングのレビューdeep learning: concepts, CNN architectures, challenges, applications, future directions, Laith Alzubaidi et al

[12] ディープラーニングの研究分野の文献レビュー。

[13] The Real Hero Behind ChatGPT: Ilya Sutskever, Chief Scientist, OpenAI

[12] Deep Learning Research Areas, Mutlu Yapıcı et al.'s Leap of Faith, New Zeal

[14] 10年後、ディープラーニングの「革命」は激化している、とAIのパイオニアたちは言う。Hinton, LeCun and Li, Venturebeat

[15] From not working to neural networking, The Economist

[16] Huge 'foundation models' are turbo-charging AI progress, The Economist

[17] 2012: ABreakthrough Year for Deep Learning, Bryan House

[18] Deep Learning: The Magic Wand of AI, Axiom Securities

[19] Deep Learning: The Magic Wand of AI, Axiom Securities

.

破綻した暗号取引所FTXの創設者であるサム・バンクマン・フライドは、まだ自分の話を終えていない。

XingChi

XingChiハニェがテヘラン襲撃で死亡、バイドゥが追悼ページを白黒に変更し物議

ZeZheng

ZeZhengバイナンス創業者の趙昌鵬氏が、法的な課題を抱える中、非営利のオンライン教育プラットフォームであるギグル・アカデミーを導入。批判にもかかわらず、このイニシアチブは無料で、ゲーム化された教育を世界的に提供することを目指している。ザオのビジョンは、教育格差に対処することであり、アクセシビリティと適応性を重視している。

Sanya

Sanyaゴールデンファイナンスは、暗号通貨・ブロックチェーン業界の朝刊ニュースレター「ゴールデンモーニング8」2251号を創刊し、最新・最速のデジタル通貨・ブロックチェーン業界ニュースをお届けします。

JinseFinance

JinseFinanceロビンフッド、マサチューセッツ州証券規制当局と和解し、750万ドルの違約金とデジタル・エンゲージメント・ポリシーの改定に合意。この和解は、取引をゲーミフィケーション化し、経験の浅い投資家を欺いたという疑惑に対処するもの。和解は、投資家保護とサイバーセキュリティを重視し、特定のゲーミフィケーション要素の中止を含む慣行の変更を要求している。

Xu Lin

Xu Linビットコイン、イーサリアム、そして金融の未来を形作るETFとトークン化の変革の可能性についてのブラックロックCEO、ラリー・フィンクの洞察をご覧ください。

Miyuki

Miyukiブラックロックの最高経営責任者(CEO)ラリー・フィンク氏は、仮想通貨への世界的な関心が高まっていると語った。

dailyhodl

dailyhodlフィンク氏は暗号通貨を「金のデジタル化」に例え、ビットコインをインフレに対するヘッジとして機能する「国際資産」として概説した。

cryptopotato

cryptopotatoOpenSeaの公式ソーシャルメディアアカウントによると、OpenSeaはプロフィールページのコレクションカード、コレクションページの最高のオファー(NFTコレクションページに最高のオファーとその他のトップ指標を表示)、およびアクティビティミントの更新を開始しました。価格 (アクティビティ フィードにポリゴンを表示)、Klaytn、およびイーサリアムの鋳造価格) の 3 つの新機能。

链向资讯

链向资讯 Cointelegraph

Cointelegraph