著者: Doug Petkanics, Livepeer CEO; 翻訳: 0xxz@GoldenFinance

Introduction

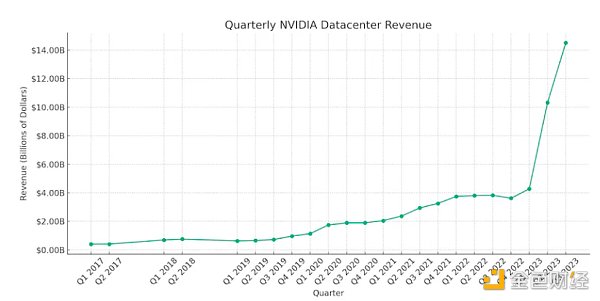

Livepeer ネットワークが週に何百万分もの動画をトランスコードするために何千もの GPU をアクティブにしていることが判明したとき、最も一般的な質問のひとつは、それらの GPU を他のタイプの計算を実行するために使用できるかどうかというものでした。というものだった。特に、2023年のAIの台頭と、それに伴うGPU(AIのトレーニングと推論を実行するために使用されるハードウェア)の需要の増加に伴い、Livepeerネットワークがそのコンピューティングパワーを使って、数十億ドルもするAIインフラに進出する可能性があると考えるのは自然なことだ。AIコンピューティング用のGPUを提供するnVidiaのデータセンター事業は、前四半期だけで140億ドルを売り上げた。は前四半期に140億ドルの増収を達成し、前年同期の40億ドルから増加した。

<

<

Source: NVidia Quarterly Report from @Thomas_Woodside on X

オーサリングの面では、ジェネレーティブAIを使って、テキストや画像を手掛かりにビデオクリップを作成することができます。シーンの設定には、撮影クルー、セット、カメラ、脚本、俳優、編集者などが必要でしたが、今では、ユーザーがキーボードにテキストキューを入力し、GPUが潜在的な結果のサンプルを生成するのを数分待つだけでよくなるかもしれません。ビデオを生成することは、高品質の制作に取って代わるものではありませんが、プロセスのすべての段階で大幅なコスト削減につながります。

制作側では、アップスケール、フレーム補間、字幕生成などの機能により、AIが作成したものであれ、制作者が提出したものであれ、動画コンテンツの品質とアクセシビリティを迅速に向上させることができます。動画のインタラクティブ性などの高度な機能は、自動オブジェクト検出、マスキング、シーン タイプの分類によって実現できます。

LivepeerがこのAI機能セットを活用するタイミングは、オープンソースの基本モデル(Stable Video Diffusion、ESRGAN、FASTなど)が最近リリースされ、クローズドソースのプロプライエタリモデルと同期しているためです。目標は、世界のオープンなビデオ インフラストラクチャが、誰もがアクセス可能なオープンソース モデルの実行をサポートすることであり、現在存在し、オープンソース AI コミュニティからの革新のおかげで急速に良くなっているモデルです。

AIのコンテキスト - Livepeerがフィットする場所

トレーニング、微調整、推論

AIのライフサイクルには多くの段階がありますが、一般的に多くのコンピューティングパワーを必要とするのは、トレーニング、微調整、推論の3つです。

トレーニングでは、モデルを作成し、非常に大規模なデータセットで計算を実行します。基礎となるモデル(たとえば、OpenAIやGoogle経由でトレーニングされたモデル)のトレーニングには、数千ドルから数億ドル相当の計算が必要になることもあります。

微調整はより費用対効果が高く、既存の基本モデルを使用しますが、特定のタスクの特定の入力セットに基づいて重みを調整します。

推論とは、学習・調整されたモデルを用いて、入力セットに基づいて出力を生成したり、予測を行ったりすることです。推論作業では、これは通常、最初の2つの段階に比べて計算量が少なくなりますが、通常、何百万回も繰り返し実行されるため、推論のコストはトレーニングのコストを上回り、トレーニングへの投資を正当化します。

トレーニングと微調整には、大規模なデータセットへのアクセスと、互いに通信して情報をすばやく共有できるように高密度にネットワーク化されたGPUが必要です。Livepeerのようなネットワークは、すぐに使えるトレーニングには適しておらず、仕事をこなすには大規模なアップデートが必要です。分散型ネットワークは、プロプライエタリな大規模技術のトレーニングクラウドに代わるものとして、トレーニングには魅力的ですが、ネットワークのオーバーヘッドや、基礎となるモデルをトレーニングする際の非効率性により、分散型ネットワークがコスト面で競争力を持つかどうかは疑問です。

一方で、Livepeerのような分散型ネットワークが活躍できるのは推論です。各ノードオペレーターは、与えられたモデルをGPUにロードするオプションがあり、ユーザー入力に基づいて推論ジョブを実行するコストを競うことができます。Livepeerのトランスコーディングネットワークのように、ユーザーはAI推論を実行するためにLivepeerネットワークにジョブを提出することができ、現在アイドル状態のGPUパワーを活用するために、オープン市場で競争力のある価格設定の恩恵を受けることができ、その結果、コストメリットを見ることができるはずです。

GPUはAIブームの活力源であり、GPU需要に基づくNVidiaのデータセンター事業は、この1年で飛躍的に成長した。イーロン・マスクは、GPUは麻薬よりも買いにくいと冗談を言っている。しかし、LivepeerのようなDePINネットワークは、そのオープンマーケットダイナミクスと、インフレ型トークン報酬によるインセンティブによって、需要に先駆けてGPUの世界的な供給を集めることができ、新しいユーザーやアプリケーションの成長を弾力的にサポートできることを示している。ほぼ無制限の従量課金制。開発者は、使用していないハードウェアを高額で事前に予約する必要がなくなり、代わりに可能な限り低い市場価格を支払うことができる。これは分散型ネットワークにとって、AIブームを牽引する大きなチャンスです。

Livepeerのチャンス - AI推論タスクをGPUではなくネットワークに投入

1,000個のGPUをLivepeerに接続する。

GCPやAWSのようなクラウドプロバイダーでは、企業向けクラウド上で「GPUサーバーを予約」することができます。Akashのようなオープンネットワークはさらに進んでおり、世界中の多くの分散型プロバイダーの1つからオンデマンドでサーバーを借りることができます。しかし、これらのオプションにかかわらず、モデルを実行しタスクを実行するためには、レンタルしたサーバーを管理しなければならない。一度に複数のタスクを実行できるアプリケーションを構築したいのであれば、それをスケールしなければならない。ワークフローをリンクさせなければならない。

Livepeerは物事を「ジョブ」として抽象化し、ネットワークに送信し、完了することを信頼することができます。ジョブをネットワークに送信するだけで、ブロードキャストノードが確実にジョブを完了させ、ワーカーノードの選択、フェイルオーバー、冗長性に気を配ってくれると確信できます。

AIビデオ・コンピューティング・タスクも同じように機能します。テキストからビデオを生成する」ジョブがあるかもしれません。これを実行するノードを信頼することができ、実際の計算を実行するために何千ものGPUのネットワークを活用できる単一のノードを通じて、同時に投入したいジョブの数に拡張することができます。これはまだ設計段階ですが、

Generate video from text

Rise one level

Interpolate frames to make it play smoothly

別々のマシンに別々のモデルを展開したり、IOを管理したり、ストレージを共有したりすることなく、ネットワークがこのようなことをしてくれます。サーバーの管理、サーバーのスケーリング、フェイルオーバーなどはもう必要ありません。Livepeerは、最大限のコスト効率と高い信頼性を備えたスケーラブルなインフラです。このネットワークが、ビデオトランスコーディングの取り組みで実現したように、AIビデオコンピューティングのこれらの約束を実現できれば、オープンAIの世界ではまだ見られない、新しいレベルの開発者エクスペリエンスとコスト削減を実現できるだろう。

AIビデオコンピューティングを迅速に導入し、ネットワークの費用対効果を検証する計画

AIビデオサブネットワーク

過去7年間のLivepeerの歩みに沿って、このプロジェクトは、"Livepeerにはこれがある "キャンペーンの前に、実際に使用可能で機能的な、オープンソースのソフトウェアとネットワーク機能を実証するために取り組みます。Livepeerにはこれがある "キャンペーンの前に。

- ビデオトランスコーディングだけでなく、他のタイプの仕事に対する具体的な初期ユースケースを選択します: AIのアップグレードとフレーム補間によってサポートされる、AIベースの生成ビデオ。この分野では、Stable Video Diffusionのような優れたオープンモデルが日々進化しています。

ノードのソフトウェアのフォーク/スパイク内に構築することで、コーディネータ(供給側)ノードとブロードキャスター(需要側)ノードにこれらの機能を追加し、迅速に動けるようにします。LivepeerのOpen Media Server Catalystは、これらの生成的な動画タスクを要求および使用するためのインターフェイスをサポートする必要があります。

このピークを実行しているユーザーは、Livepeer上である種のサブネットワークを形成しますが、Livepeerプロトコルを使用して、メインのLivepeerネットワークを通じて、この新しい機能を実行しているノードを発見し、支払いを行います。

消費者向けのフロントエンド・アプリケーションと提携し、Livepeerの非常にコスト効果の高いオープン・コンピュート・ネットワークを活用し、パブリック・クラウドに対するLivepeerのコスト効果を検証するデータを取得して提示します。

これを検証しながら、Livepeerのコアクライアントに統合し、他の種類の作業を追加し、AIベースのビデオコンピューティングの他の形態を活用するエコシステムを成長させていきます。

AAIビデオサブネットワークノードは、トランスコーディングノードと並行して稼働しながら、Livepeerメインネット決済を使用しています。Livepeerメインネット決済を使用しています。

AIビデオSPE

Livepeerは最近、デルタアップグレードでプロトコルにオンチェーンVault管理コミュニティを導入しました。すでに、AIビデオコンピューティングの実現を目指す特別目的事業体(SPE)に資金を提供するための事前提案が議論され、投票が間近に迫っています。

Livepeer ノードフォークとしてこれらの AI 機能を開発する

ノードオペレータは、Livepeer ノードをフォークするサブネットワークを形成することができます。Livepeerメインネットで支払うことで、Livepeerノードをフォークするサブネットワークを形成することができます。

これらの機能を消費者に示すフロントエンド・アプリケーション。

Livepeerネットワーク上でAI推論を大規模に実行することの費用対効果を示すベンチマークとデータのコレクション。

また、このデータ収集中に消費者が使用する初期費用を賄うための、保管庫からのインフラクレジットの将来的な資金調達のマイルストーンの可能性も示しています。

LivepeerのDiscordの#ai-videoチャンネルは、このイニシアチブをめぐる議論とコラボレーションのホットスポットになっており、オープンなAIインフラとビデオAIコンピューティングの未来を信じる人なら誰でも、立ち寄って挨拶し、参加するべきです。ノード・オペレーターはすでに、さまざまなハードウェアのベンチマークを開始し、これらのオープン・ビデオ・モデルの実行に慣れ、ビデオ・トランスコード専門から他のビデオに特化した職種に移行する課題に取り組んでいる。動きの速いプロジェクト チームの一員であることは楽しい時間でした。

将来

この最初のマイルストーンは、Livepeerがサポートする特定の形式のAIビデオ計算にとって費用対効果が高いことを示すことができますが、本当の究極の力は、AI開発者がモデルをBYOしたり、重みをBYOしたり、チューニングをBYOしたり、ネットワークの既存の基本モデルの上に構築するカスタムLoRAを展開したりする能力にあります。

多様なモデルと計算の形式にわたってこれらの初期機能をサポートすることで、AIビデオコンピューティングに関しては、ノード操作、GPU上でのモデルのロード/アンロード、ノードの発見とネゴシエーション、フェイルオーバー、支払い、認証などの分野で迅速な学習が可能になります。そこから、Livepeerネットワーク上であらゆる種類のAIビデオコンピューティングジョブを生産し、サポートするための将来のマイルストーンを評価することができます。

早い段階で、動画に特化したプラットフォーム(Livepeer Studioなど)は、動画開発者がサポートされているモデルを活用するためのAPIや製品を構築できます。AI Video SPEで提案されているような)消費者向けアプリケーションは、Catalystノードを通じて、Livepeerネットワーク上でこれらの機能を直接使用できます。しかし、これらの機能が拡張されるにつれて、新しいクリエイター中心のAIビジネスが形成され、LivepeerのグローバルGPUネットワークを活用して、ビジネスのバックボーンとして大規模で高価な技術クラウドと独自のモデルに依存することなく、カスタム体験をコスト効率よく構築できるようになります。

そこに到達するまでの道のりはエキサイティングだ。今後数年間で、AIが私たちの想像を超える速さで動画の世界を変えることは間違いありません。私たちは、世界のオープンな動画インフラストラクチャが、将来的にこの大胆な新技術を実現するために必要なすべてのコンピューティングにとって、最もコスト効率が高く、スケーラブルで信頼性の高いバックボーンになることを楽しみにしています。

JinseFinance

JinseFinance

JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance Xu Lin

Xu Lin JinseFinance

JinseFinance Catherine

Catherine Bitcoinist

Bitcoinist