著者:Azi.eth.sol|zo.me出典:X、@MagicofAzi翻訳:Good Oba、Golden Finance

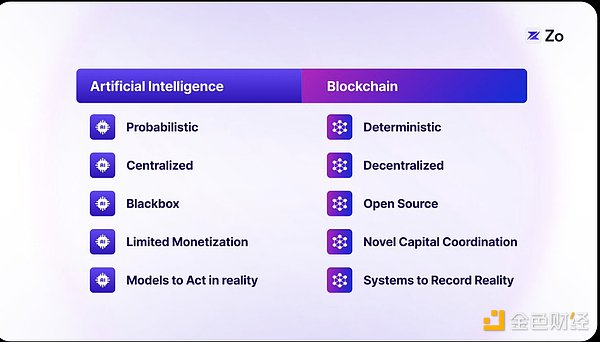

人工知能(AI)とブロックチェーン技術は、我々の世界を再構築する2つの変革的な力である。ブロックチェーン技術は、検証可能なデジタルの希少性を導入し、信用なき協調を可能にする。AIは機械学習とニューラルネットワークによって人間の認知能力を高め、ブロックチェーン技術は検証可能なデジタルの希少性を導入し、信頼のない協調を可能にする。これらの技術が融合すれば、次世代のインターネット、つまり分散型システムと相互作用する自律的なエージェントのネットワークの基礎が築かれる。この「エージェント化されたネットワーク」は、デジタル市民という新しいカテゴリーを導入する。このシフトは、デジタル領域におけるパワーを再分配し、個人が自身のデータに対する主権を取り戻すことを可能にすると同時に、人間とAIが前例のない方法でコラボレーションするエコシステムを育成する。

<

<

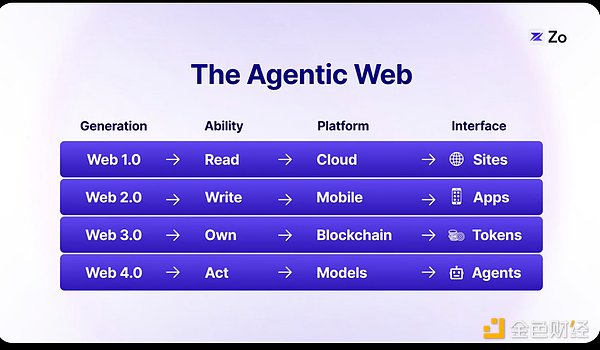

ウェブの進化

私たちがどこに向かっているのかを理解するために、ウェブの進化を見直すことから始めましょう。

ウェブの最初の2世代は情報の普及に重点を置いていましたが、最後の2世代は情報の強化を可能にしました。トークンによるウェブ3.0はデータの所有権を導入し、そして今、ウェブ4.0は大規模言語モデル(LLM)を通じてインテリジェンスを注入している。

大規模言語モデルからエージェントへ:自然な進化

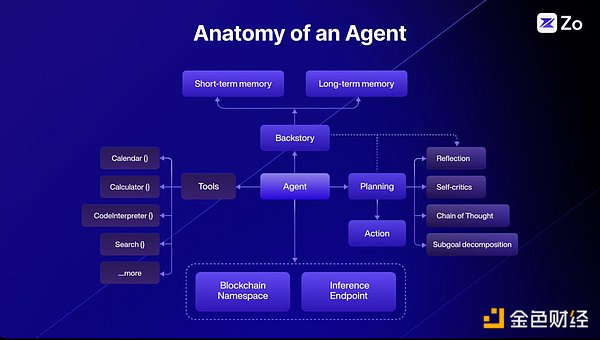

LLMは、動的なパターンマッチングシステムとして、膨大な知識を確率的計算によって文脈理解に変換する、機械知能の飛躍的な進歩を表しています。しかし、LLMの真の可能性が明らかになるのは、LLMがエージェントとして構築されたときです。LLMは、純粋な情報処理装置から、知覚、推論、行動が可能な目標指向のエンティティへと進化します。この変換により、言語と行動を通じて持続的で意味のある協力ができる新たな知性が生まれます。

「エージェント」という用語は、従来のチャットボットに関連する制限や否定的な連想を超えて、人間とAIとの関わり方を変える新しいパラダイムを導入しています。このシフトは単なる意味上の変化ではなく、AIシステムが人間との有意義なコラボレーションを維持しながら自律的に動作する方法の根本的な再定義です。エージェント化されたワークフローは最終的に、特定のユーザーの意図を中心とした市場の形成を可能にします。

結局のところ、エージェント化されたウェブは、単に新しいレベルのインテリジェンスというだけではありません。過去のバージョンのウェブが静的なインターフェイスとあらかじめ定義されたユーザーパスに依存していたのに対し、エージェント化されたウェブは、ユーザーのコンテキストと意図に応じて計算とインターフェイスがリアルタイムで適応する動的なランタイムインフラストラクチャを導入します。

従来のWebサイトとエージェント化されたWebの比較

従来のWebサイトは、今日のインターネットの基本的な単位であり、ユーザーが情報を読んだり、書き込んだり、やりとりしたりするための、あらかじめ定義された経路を持つ固定インターフェースを提供しています。このモデルは、十分に機能的ではあるものの、ユーザを個人のニーズではなく、一般的な使用のために設計されたインターフェイスに制限しています。エージェント化されたウェブは、コンテキストを意識した計算、適応的なインターフェイスの生成、RAGやその他のリアルタイム情報検索の革新によって解放された予測的なアクションプロセスを採用することで、これらの制限を打破します。

TikTokが、ユーザーの好みにリアルタイムで適応する高度にパーソナライズされたプッシュコンテンツを作成することで、コンテンツの消費方法にどのような革命を起こしたかを考えてみましょう。エージェント化されたウェブは、このコンセプトをインターフェース世代全体のレベルまで拡張します。固定されたページレイアウトをナビゲートする代わりに、ユーザーは次の行動を予測し促進する動的に生成されるインターフェイスと対話する。静的なウェブサイトから動的なエージェント駆動型インターフェースへのこのシフトは、ナビゲーションベースからインテンションベースのインタラクションモデルへの、デジタルシステムとのインタラクション方法の根本的な進化を表しています。

エージェントの構造

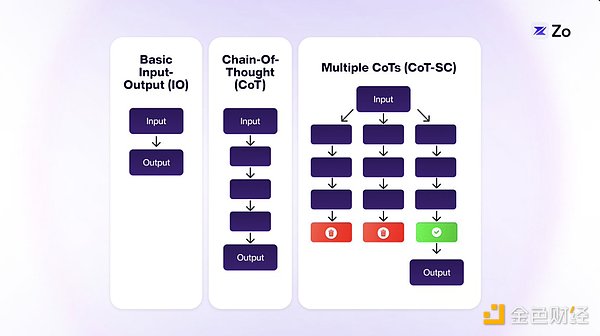

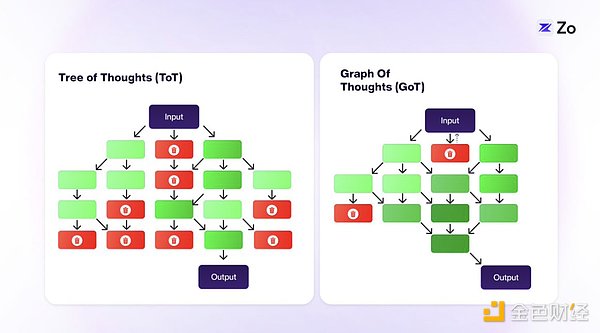

エージェントベースのアーキテクチャは、研究者や開発者にとって巨大な探求領域でした。推論と問題解決を強化するために、常に新しいアプローチが開発されています。Chain-of-Thought(CoT)、Tree-of-Thought(ToT)、Graph-of-Thought(GoT)などの技術は、より詳細で人間のような認知プロセスをモデル化することで、複雑なタスクに対処する大規模言語モデル(LLM)の能力を向上させる方法の革新的な例です。

Chained Thinking (CoT)は、大規模言語モデルに複雑なタスクをより小さく、管理しやすいステップに分解するよう促します。このアプローチは、短いPythonスクリプトを書いたり、数式を解いたりするような、論理的な推論を必要とする問題に特に効果的です。

Tree Thinking (ToT)CoTをさらに発展させたのが、複数の独立した思考経路を探索できるツリー構造の使用です。この改良により、LLMはより複雑なタスクを処理できるようになった。ToTでは、各「思考」(LLMのテキスト出力)はその前後の「思考」にのみ接続され、局所的なチェーン(枝)を形成する。この構造はCoTよりも柔軟性があるが、それでも思考を超えたコミュニケーションの可能性は制限される。

グラフィカル思考(GoT)はこの概念をさらに拡張し、古典的なデータ構造とLLMを組み合わせたものです。このアプローチでは、任意の1つの「思考」をグラフ内の他の思考に接続できるようにすることで、ToTの範囲を広げています。この思考の相互接続は、人間の認知プロセスに近い。

GoTのグラフ構造は通常、CoTやToTよりも人間の思考パターンを正確に反映しています。私たちの思考パターンが連鎖しているように見えたり、ツリーのように見えたりする文脈もありますが(例えば、緊急計画や標準作業手順を策定する場合など)、これはルールというよりはむしろ例外です。GoTモデルは、厳密な順序に従うのではなく、複数の思考にまたがることが多い人間の思考により沿っています。いくつかの状況(緊急計画や標準的な手順の策定など)は、まだ鎖や木のようなものかもしれませんが、私たちの思考は、多くの場合、複雑で相互接続された思考のネットワークを形成しており、これはGoTのグラフィカルな構造により適合しています。

<

<

『GoT』のグラフィカルなアプローチによって、よりダイナミックで柔軟なアイデアの探求が可能になり、より創造的で総合的な問題解決能力につながる可能性があります。

これらの再帰的なグラフベースの操作は、エージェントベースのワークフローの進化の一歩にすぎません。明らかな次の進化は、異なる専門性を持つ複数のエージェントが互いに協調し、特定の目標に向かって協力することです。エージェントの素晴らしさは、その組み合わせにあります。

エージェントは、マルチエージェントの調整を通じて、LLMのモジュール化と並列化を可能にします。

マルチエージェントシステム

マルチエージェントシステムのコンセプトは新しいアイデアではありません。そのルーツはMarvin Minskyの著書『The Society of Minds』まで遡ることができ、彼は複数のモジュール化されたマインドが一緒に働くことで、単一の大きなマインドを凌駕できると提唱しています。ChatGPTとClaudeはシングルエージェントであり、MistralはMixture of Experts(専門家の混合)を広めています。

バイオニックの観点から見ると、何十億もの同一のニューロンが均一で予測可能な方法で接続されているAIモデルとは異なり、人間の脳(本質的に意識的な機械である)は器官や細胞レベルで極めて異質である。神経細胞は、神経伝達物質の勾配、細胞内カスケード反応、さまざまな制御システムを含む複雑なシグナルを通じてコミュニケーションを行い、その機能は単純な二進法よりもはるかに複雑です。

このことは、生物学において、知能は構成要素の数や学習データセットの大きさ以上に由来することを示唆しています。知性は、異なる専門化されたユニット間の複雑な相互作用、つまり本質的にプロセスをモデル化する方法に由来します。

したがって、少数の大きなモデルではなく、何百万もの小さなモデルを開発し、それらの間で協調的な機能を可能にすることが、マルチエージェントシステムの構築に類似した、認知アーキテクチャの革新を促進する可能性が高いのです。

マルチエージェントシステムの設計は、シングルエージェントシステムと比較していくつかの利点があります。シングルエージェントのインターフェースだけが必要な場合でも、それをマルチエージェントフレームワークとして実装することで、システムがよりモジュール化され、開発者が必要に応じてコンポーネントを追加したり削除したりするプロセスが簡単になります。シングルエージェントシステムであっても、マルチエージェントアーキテクチャは非常に効果的な構築方法であることを認識することが重要です。

マルチエージェントシステムの利点

大規模言語モデル(LLM)は、人間のようなテキストを生成し、複雑な問題を解決し、さまざまなタスクを処理するなど、驚くべき能力を発揮してきました。-しかし、実世界のアプリケーションで個々のLLMエージェントが直面する限界は、その有効性に影響を与える可能性があります。ここでは、エージェントシステムに関連する5つの主要な課題と、マルチエージェントのコラボレーションによってそれらを克服し、LLMの可能性を最大限に引き出す方法を紹介します。

相互検証による錯覚の克服

単独のLLMエージェントは、しばしば幻覚を見たり、正しくない情報や不合理な情報を生成したりします。これは、モデルの広範な訓練にもかかわらず、出力が合理的に見えても、事実の正確さに欠けるという状況です。マルチエージェントシステムは、エージェント間の情報の相互検証を可能にすることで、エラーのリスクを軽減する。各エージェントに特化することで、エージェントはより信頼性の高い正確な回答を提供できるようになります。

分散処理によるコンテキストウィンドウの拡張

LLLMのコンテキストウィンドウは限られているため、長い文書やダイアログを処理するのは困難です。マルチエージェントフレームワークでは、各エージェントがコンテキストの一部を処理することで、エージェントが処理の負担を共有することができます。エージェント間で通信することで、テキスト全体の一貫性を維持し、コンテキストウィンドウを効果的に拡張することができる。

並列処理による効率の向上

単一のLLMは通常、一度に1つのタスクを処理するため、応答時間が遅くなる可能性があります。マルチエージェントシステムは並列処理をサポートし、複数のエージェントが同時に異なるタスクに取り組むことを可能にします。これにより、効率が向上し、応答時間が短縮され、組織は複数のクエリを滞りなく処理できるようになります。

複雑な問題解決のためのコラボレーションの促進

単一のLLMは、多様な専門知識を必要とする複雑な問題の解決に圧倒されがちです。マルチエージェントシステムは、エージェント間のコラボレーションを促進し、各エージェントが独自のスキルと視点を提供します。エージェントは協力することで、複雑な課題をより効果的に解決し、より包括的で革新的なソリューションを提供することができます。

リソースの最適化によるアクセシビリティの向上

高度なLLMは大量の計算リソースを必要とするため、コストがかかり、普及が難しくなります。マルチエージェントフレームワークは、異なるエージェントにタスクを割り当てることでリソースの使用を最適化し、全体的な計算コストを削減します。これにより、AI技術はより多くの組織により広く採用されるようになる。

マルチエージェントシステムは、分散型の問題解決やリソースの最適化において説得力のある利点を示しますが、その真の可能性は、ネットワークのエッジでの実装を考えたときに明らかになります。AIが進化し続ける中、マルチエージェントアーキテクチャとエッジコンピューティングの融合は、強力な相乗効果を生み出します。AIの展開に対するこの分散型アプローチは、マルチエージェント・システムの利点を自然に拡張し、特殊化された協調的インテリジェンスを最も必要とされる場所、つまりエンドユーザーにもたらします。

エッジコンピューティングにおけるインテリジェンス

デジタル空間におけるAIの普及は、コンピューティングアーキテクチャの根本的な再構成を促しています。専門化されたデータセンターが複雑な推論やドメイン固有のタスクを処理する一方で、エッジデバイスはパーソナライズされた、コンテキストに応じたクエリをローカルで処理します。このエッジ推論へのシフトは、単にアーキテクチャ上の好みというだけでなく、いくつかの重要な要因によって推進される必要性です。

第一に、AI主導のインタラクションの量が膨大になると、集中型の推論プロバイダーが圧倒され、持続不可能な帯域幅要件と待ち時間の問題が生じます。

第二に、エッジ処理により、自動運転車、拡張現実、IoTデバイスなどのアプリケーションにとって重要な機能であるリアルタイム応答が可能になります。

第3に、エッジ推論は、個人のデバイスに機密データを保持することで、ユーザーのプライバシーを保護します。

第4に、エッジコンピューティングは、ネットワークを介したデータの流れを最小限に抑えることで、エネルギー消費とカーボンフットプリントを大幅に削減します。

最後に、エッジ推論はオフライン機能と回復力をサポートし、ネットワーク接続が制限された場合でもAI機能が維持されるようにします。

この分散インテリジェンスのパラダイムは、単に現在のシステムを最適化するだけではありません。

さらに、私たちはLLMの計算要件における根本的な変化を目の当たりにしています。過去10年間は、大規模な言語モデルをトレーニングするための膨大な計算需要がAIを支配していましたが、現在は推論に関して計算が中心となる時代に突入しています。このシフトは、OpenAIのQ*ブレークスルーのようなエージェントベースのAIシステムの出現において特に明らかであり、動的推論が重要なリアルタイムの計算リソースを必要とする必要性を示しました。

モデル開発への1回の投資であるトレーニング時間の計算とは異なり、推論時間の計算は、自律エージェントが推論、計画、新しい状況への適応をサポートするための計算の継続的な対話を意味します。静的なモデルトレーニングから動的なエージェントの推論へのこのシフトは、コンピューティングインフラストラクチャの根本的な再考を必要とします。

この変革が展開される中、私たちは、スマートフォンからスマートホームシステムまで、何千もの接続されたデバイスが動的なコンピューティンググリッドを形成する、エッジ推論市場の台頭を目の当たりにしています。これらのデバイスは推論パワーをシームレスに交換することができ、コンピューティング・リソースが最も必要とされる場所に流れる有機的な市場が形成されます。アイドル状態のデバイスの予備のコンピューティングパワーは、リアルタイムで取引できる貴重なリソースとなり、従来の集中型システムよりも効率的で弾力性のあるインフラストラクチャを可能にします。

この推論コンピューティングの分散化により、リソースの利用が最適化されるだけでなく、デジタルエコシステムに新たな経済的機会が生まれます。その結果、AIの未来は、個々のモデルの能力だけでなく、接続されたエッジデバイスの集合的なインテリジェンスによって定義され、需要と供給に基づいて検証可能な推論のためのスポット市場に似た、グローバルで分散化された推論市場が形成されます。

エージェント中心のインタラクション

今日、LLMによって、従来のブラウジングではなく、会話を通じて膨大な量の情報にアクセスできるようになりました。インターネットが人間のユーザーのためだけの空間ではなく、AIエージェントのためのプラットフォームへと変化するにつれて、この会話的なアプローチはやがて、よりパーソナライズされ、ローカライズされるようになるでしょう。

ユーザーの視点に立てば、焦点は「最良のモデル」を選ぶことから、最もパーソナライズされた答えを得ることに移るだろう。より良い答えを得るための鍵は、ユーザー自身のデータと、一般化されたインターネットの知識を組み合わせることです。当初は、より大きなコンテキストウィンドウとRAG(Retrieval Augmented Generation)が個人データの統合を助けるでしょうが、最終的には、個人データが一般的なインターネットデータの重要性を追い越すでしょう。

これによって、個人のAIモデルが、より広範なインターネットの専門家モデルと相互作用する未来がやってきます。当初、パーソナライゼーションはリモートモデルと共に行われますが、プライバシーや応答性の懸念から、より多くのインタラクションがローカルデバイスに移行するでしょう。これにより、人と機械の間ではなく、個人モデルとインターネット専門家モデルの間に新たな境界が生まれることになります。

従来のインターネットモデルは時代遅れとなり、生のデータにアクセスすることはなくなります。むしろ、あなたのローカルモデルはリモートの専門家モデルと通信し、情報を収集し、可能な限りパーソナライズされた広帯域幅の方法であなたにそれを提示します。このようなパーソナルモデルは、あなたの好みや習慣をより深く知るにつれて、ますます不可欠なものとなるでしょう。

インターネットは、ローカルで高度に文脈に沿った個人モデルと、リモートで高度に知識のある専門家モデルという、相互に接続されたモデルのエコシステムへと変化していくでしょう。これには、これらのモデル間の情報を更新するために、Federated Learningのような新しい技術が必要になります。マシン・エコノミーが進化するにつれ、このプロセスを支える計算基盤、特に計算、スケーラビリティ、支払いの面において、私たちは再考する必要があるだろう。これは、エージェント中心、主権、高度にコンポーザブル、自己学習、進化する情報空間の再編成につながるだろう。

エージェントプロトコルのアーキテクチャ

エージェントウェブでは、人間とエージェントの相互作用は、エージェント間の複雑な通信ネットワークへと発展する。このアーキテクチャは、主権エージェントがデジタルインタラクションの主要なインターフェイスとなる、インターネットの構造の基本的な再概念化を提供します。以下は、エージェントプロトコルを実装するために必要なコアプリミティブです。style-type: square;">

従来のIPアドレスから、エージェントベースのアクターが所有する暗号化された公開鍵ペアへのデジタルIDの移行。

ブロックチェーンベースの名前空間システムが従来のDNSに取って代わり、中央管理ポイントをなくします。

評判システムは、エージェントの信頼性と容量のメトリクスを追跡します。

ゼロ知識証明は、プライバシーを維持した認証を可能にします。

アイデンティティの互換性により、エージェントは複数のコンテキストと役割を管理することができます。

Autonomous Agents

データ・インフラ

計算レイヤー

Peer-to-peerコンピューティング・マーケットプレイス

Proof-of-Computation Systems

Dynamic Resource Allocation

Edge Computing Integration

Computational Integrity

Result Reproducibility

検証可能な推論プロトコル

モデルのエコシステム

Task-specific Small Language Models (SLMs)

Generic Large Language Models (LLMs)

Specialized Multimodal Models

Specialized Multimodal Models

Specialized Multimodal Models

。Large Action Models (LAMs)

Hierarchical Model Architecture:

モデルの組み合わせと調整

継続的な学習と適応機能

標準化されたモデルインターフェースとプロトコル

協調フレームワーク

Concurrent task processing

リソースの分離

状態管理

コンフリクトの解決

暗号化されたプロトコルにより、エージェントの安全なやり取りを保証

デジタルプロパティ管理システム

経済的インセンティブ構造

<ガバナンス機構:紛争解決、リソース割り当て、プロトコル更新

並列実行環境のサポート:

エージェントマーケットプレイス

ガバナンスと配当

エージェントは、作成時にトークンのパーセンテージを所有します

集約された推論市場は、流動性を介して支払われます

オフチェーンアカウントを制御するオンチェーンキー

アイデンティティに使用されるオンチェーンプリミティブ(例えば、Gnosis、Squad multisigs)

経済学とエージェント間の取引

エージェントは流動性を所有する

エージェントは流動性を所有する

流動性を所有する。p>エージェントは収益を生む資産になる

エージェントDAO

知性のためのハイパーストラクチャを作る

現代の分散システム設計は、エージェントプロトコルを実装するためのユニークなインスピレーションとプロト言語学を提供します。

アクターモデルは、エージェントシステムを実装するためのエレガントな理論的基礎を提供します。

アクターモデルがエージェントシステムにもたらす主な利点は以下のとおりです。paddingleft-2">

分離:各アクターは独立して動作し、独自の状態と制御フローを維持します。

非同期通信:アクター間のメッセージングはノンブロッキングで、効率的な並列処理が可能です。

位置の透過性:アクター同士は物理的な位置に関係なく通信できます。

耐障害性:システムの耐障害性は、アクターの分離と監督階層によって達成されます。

スケーラビリティ:分散システムと並列コンピューティングを自然にサポートします。

私たちはNeuronを発表します。Neuronは、この理論的なエージェントプロトコルを多層分散アーキテクチャを通して実装する実用的なソリューションです。このアーキテクチャは、ブロックチェーンの名前空間、連携ネットワーク、CRDT(競合に強い自由データ型)、DHT(分散ハッシュテーブル)を組み合わせており、各層がプロトコルスタックの異なる機能を担っています。私たちは、ピアツーピアのオペレーティングシステム設計の初期のパイオニアであるUrbitとHolochainからインスピレーションを得ています。

Neuronでは、ブロックチェーン層が検証可能な名前空間と認証を提供し、決定論的なアドレス指定とエージェントの発見を可能にすると同時に、容量と評判の暗号的証明を維持します。その上、DHTレイヤーは、O(log n)のルックアップ時間で、効率的なエージェントとノードの発見、およびコンテンツのルーティングを容易にし、オンチェーン操作の数を減らすと同時に、ローカルに認識されたピアツーピアのノード発見を可能にします。CRDTでは、連携ノード間の状態同期が処理されるため、エージェントとノードは、相互作用ごとにグローバルなコンセンサスを必要とすることなく、一貫した共有状態を維持することができます。

このようなCRDTを使用することで、エージェントとノードは、各インタラクションでグローバルなコンセンサスを必要とすることなく、一貫した共有状態を維持することができます。/p>

このアーキテクチャは、自律エージェントがローカルエッジ推論機能を持つデバイス上の主権ノードとして動作し、アクターモデルのパターンを実装する連合ネットワークに自然にマッピングされます。フェデレートされたドメインは、エージェントの能力に応じて編成することができ、DHTはドメイン内およびドメイン間で効率的なルーティングとディスカバリを提供します。各エージェントは独自の状態を持つ独立したアクターとして動作し、CRDTレイヤーはフェデレーション全体の究極的な一貫性を保証します。

この実装は、エージェント間の効果的な相互作用を保証するために、主権、スケーラビリティ、回復力という重要な属性を維持しながら、複雑なエージェントシステムを構築するための強固な基盤を提供します。

結論

エージェントベースのネットワークは、人間とコンピュータの相互作用における重要な進化を示し、以前の時代の直線的な発展を超越し、デジタルプレゼンスの新しいパラダイムを確立しました。単に情報を消費したり所有したりする方法を変えた過去の反復とは異なり、エージェントベースのウェブは、インターネットを人間中心のプラットフォームから、自律的なエージェントが主要なアクターとなるインテリジェントなインフラ層へと変貌させます。このシフトは、エッジコンピューティング、大規模言語モデル、分散型プロトコルの融合によって推進され、個人のAIモデルがプロの専門家システムとシームレスに連携するエコシステムを作り出します。

このエージェント中心の未来に向かうにつれ、人間と機械知能の境界は曖昧になり始め、個人化されたAIエージェントが私たちのデジタルな延長として機能し、私たちのコンテキストを理解し、私たちのニーズを予測し、広大な分散型インテリジェンスランドスケープを自律的にナビゲートするという共生関係に取って代わられます。このように、エージェントベースのネットワークは、単なる技術的進歩ではなく、デジタル時代における人間の可能性を根本的に再構築するものであり、あらゆる相互作用がインテリジェンスを強化する機会となり、あらゆるデバイスが協調的なAIシステムのグローバルネットワークのノードとなるアーキテクチャです。

人間が空間と時間という物理的な次元をナビゲートするように、自律型エージェントは、存在するためのブロック空間と、思考するための推論時間という、独自の基本的な次元に存在します。このデジタルの存在論は、私たちの物理的な現実を映し出すものです。人間は距離を越え、時間の流れを経験しますが、エージェントは暗号的な証明や計算サイクルの中を「移動」し、アルゴリズム的な存在のパラレルワールドを作り出します。

分散化されたブロック空間で活動するポテンシャル空間のエンティティは、必然的に存在することになります。

Anais

Anais

Anais

Anais Kikyo

Kikyo Catherine

Catherine Weatherly

Weatherly Kikyo

Kikyo Weatherly

Weatherly Anais

Anais Catherine

Catherine Alex

Alex Miyuki

Miyuki