Tác giả: Cynic, Shigeru span>

Giới thiệu:Sử dụng sức mạnh của thuật toán, sức mạnh tính toán và dữ liệu, sự tiến bộ của công nghệ AI đang định nghĩa lại việc xử lý dữ liệu và thông minh biên giới ra quyết định. Đồng thời, DePIN thể hiện sự thay đổi mô hình từ cơ sở hạ tầng tập trung sang các mạng dựa trên blockchain phi tập trung.

Khi thế giới tiếp tục tăng tốc theo hướng chuyển đổi kỹ thuật số, AI và DePIN (cơ sở hạ tầng vật lý phi tập trung) đã trở thành động lực cho sự thay đổi trong mọi tầng lớp xã hội. Công nghệ cơ bản. Việc tích hợp AI và DePIN sẽ không chỉ thúc đẩy quá trình lặp lại nhanh chóng và ứng dụng công nghệ rộng rãi mà còn mở ra một mô hình dịch vụ an toàn, minh bạch và hiệu quả hơn, mang lại những thay đổi sâu rộng cho nền kinh tế toàn cầu.

DePIN: Phân quyền chuyển từ ảo sang thực, trụ cột của nền kinh tế kỹ thuật số

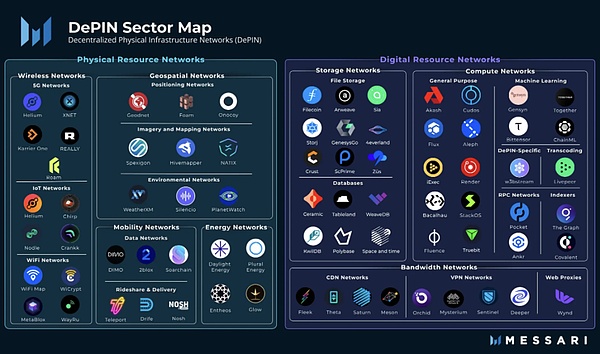

DePIN là tên viết tắt của Cơ sở hạ tầng vật lý phi tập trung. Theo nghĩa hẹp, DePIN chủ yếu đề cập đến mạng phân tán của cơ sở hạ tầng vật lý truyền thống được hỗ trợ bởi công nghệ sổ cái phân tán, như mạng điện, mạng truyền thông, mạng định vị, v.v. Nói rộng ra, tất cả các mạng phân tán được hỗ trợ bởi các thiết bị vật lý đều có thể được gọi là DePIN, chẳng hạn như mạng lưu trữ và mạng máy tính.

từ: Messari

Nếu tiền điện tử đã mang lại những thay đổi về Tập trung hóa thì DePIN là một giải pháp phi tập trung trong nền kinh tế thực. Có thể nói máy khai thác PoW là một loại DePIN. DePIN đã là trụ cột cốt lõi của Web3 ngay từ ngày đầu.

Trong ba yếu tố của AI—thuật toán, sức mạnh tính toán và dữ liệu, DePIN độc quyền sở hữu hai yếu tố đó

< p style="text -align: left;">Sự phát triển của trí tuệ nhân tạo nhìn chung được coi là phụ thuộc vào ba yếu tố chính: thuật toán, sức mạnh tính toán và dữ liệu. Thuật toán đề cập đến các mô hình toán học và logic chương trình điều khiển hệ thống AI, sức mạnh tính toán đề cập đến các tài nguyên điện toán cần thiết để thực thi các thuật toán này và dữ liệu là cơ sở để đào tạo và tối ưu hóa các mô hình AI.

Trong ba yếu tố nào là quan trọng nhất? Trước khi chatGPT xuất hiện, mọi người thường coi nó như một thuật toán, nếu không thì các hội nghị học thuật và tạp chí sẽ không tràn ngập các thuật toán tinh chỉnh lần lượt. Nhưng khi chatGPT và mô hình ngôn ngữ lớn LLM hỗ trợ trí thông minh của nó được ra mắt, mọi người bắt đầu nhận ra tầm quan trọng của hai mô hình sau. Sức mạnh tính toán khổng lồ là điều kiện tiên quyết cho sự ra đời của các mô hình, chất lượng và tính đa dạng của dữ liệu là yếu tố quyết định để xây dựng một hệ thống AI mạnh mẽ và hiệu quả, ngược lại, các yêu cầu về thuật toán không còn khắt khe như thường lệ.

Trong kỷ nguyên của các mô hình lớn, AI đã thay đổi từ sự khéo léo tỉ mỉ sang những viên gạch bay mạnh mẽ. Nhu cầu về sức mạnh tính toán và dữ liệu ngày càng tăng và DePIN có thể cung cấp nó. Khuyến khích mã thông báo thúc đẩy thị trường dài hạn, đồng thời sức mạnh tính toán và lưu trữ khổng lồ ở cấp độ người tiêu dùng sẽ trở thành nguồn dinh dưỡng tốt nhất cho các mô hình lớn.

Phân cấp AI không phải là một lựa chọn mà là một điều cần thiết

Tất nhiên một số người sẽ hỏi, vì sức mạnh tính toán và dữ liệu có sẵn trong phòng máy tính AWS và chúng tốt hơn DePIN về độ ổn định và trải nghiệm người dùng, tại sao chúng ta nên chọn DePIN thay vì dịch vụ tập trung?

Tuyên bố này đương nhiên có lý. Xét cho cùng, nhìn vào tình hình hiện tại, hầu như tất cả các mô hình lớn đều được phát triển trực tiếp hoặc gián tiếp bởi các công ty Internet lớn. Đằng sau chatGPT Đó là Microsoft , và đằng sau Gemini là Google. Hầu như tất cả mọi người trong các công ty Internet lớn của Trung Quốc đều có mô hình lớn. Tại sao? Bởi vì chỉ những công ty Internet lớn mới có đủ dữ liệu chất lượng cao và sức mạnh tính toán được hỗ trợ bởi nguồn tài chính mạnh. Nhưng điều này đã sai, mọi người không còn muốn bị những gã khổng lồ Internet kiểm soát nữa.

Một mặt, AI tập trung có rủi ro về quyền riêng tư và bảo mật dữ liệu và có thể bị kiểm duyệt và kiểm soát; mặt khác, AI được tạo ra bởi Những gã khổng lồ Internet sẽ khiến con người ngày càng tăng cường sự phụ thuộc và dẫn đến sự tập trung thị trường cũng như gia tăng các rào cản đối với sự đổi mới.

từ: https://www.gensyn.ai/

Con người Không cần có Martin Luther trong thời đại AI, con người nên có quyền nói chuyện trực tiếp với Chúa.

DePIN từ góc độ kinh doanh: giảm chi phí và tăng hiệu quả là chìa khóa

Ngay cả khi gác lại cuộc tranh luận về giá trị giữa phân cấp và tập trung hóa, từ góc độ kinh doanh, việc sử dụng DePIN cho AI vẫn có giá trị của nó.

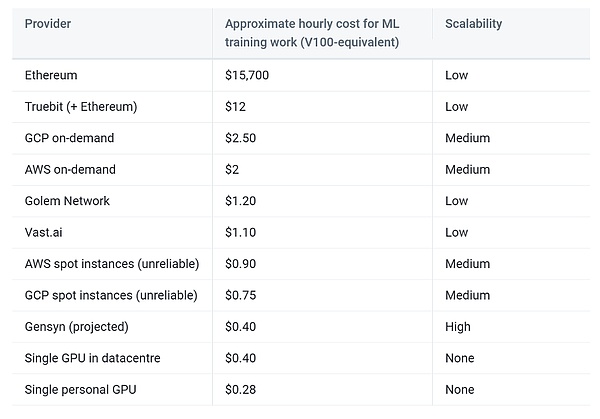

Trước hết, chúng ta cần hiểu rõ rằng mặc dù những gã khổng lồ Internet có số lượng lớn tài nguyên card đồ họa cao cấp nhưng sự kết hợp giữa card đồ họa cấp tiêu dùng nằm rải rác trong khu vực tư nhân cũng có thể tạo thành Một mạng lưới sức mạnh tính toán rất ấn tượng, đó là hiệu ứng kéo dài của sức mạnh tính toán. Tốc độ chạy không tải của loại card đồ họa dành cho người tiêu dùng này thực sự rất cao. Miễn là các ưu đãi do DePIN cung cấp có thể vượt quá hóa đơn tiền điện, người dùng sẽ có động cơ đóng góp sức mạnh tính toán cho mạng. Đồng thời, tất cả cơ sở vật chất đều do người dùng tự quản lý, mạng DePIN không cần phải chịu các chi phí vận hành không thể tránh khỏi của các nhà cung cấp tập trung mà chỉ cần tập trung vào chính việc thiết kế giao thức.

Đối với dữ liệu, mạng DePIN có thể giải phóng khả năng sẵn có của dữ liệu tiềm năng và giảm chi phí truyền tải thông qua điện toán biên và các phương pháp khác. Đồng thời, hầu hết các mạng lưu trữ phân tán đều có chức năng chống trùng lặp tự động, giúp giảm bớt công việc dọn dẹp dữ liệu đào tạo AI.

Cuối cùng, nền kinh tế tiền điện tử do DePIN mang lại sẽ nâng cao khả năng chịu lỗi của hệ thống và dự kiến sẽ đạt được tình hình đôi bên cùng có lợi cho nhà cung cấp, người tiêu dùng và nền tảng.

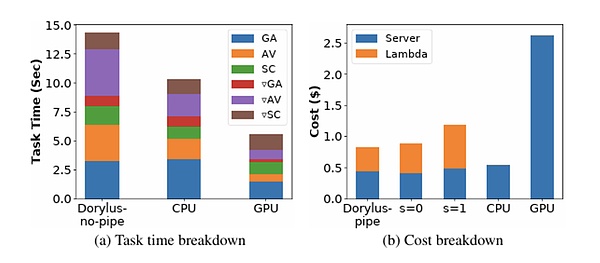

từ: UCLA

Trong trường hợp bạn không tin thì UCLA nghiên cứu mới nhất cho thấy việc sử dụng điện toán phi tập trung đạt được hiệu suất gấp 2,75 lần so với các cụm GPU truyền thống có cùng mức chi phí, cụ thể là nhanh hơn 1,22 lần và rẻ hơn 4,83 lần.

Con đường khó khăn phía trước: AIxDePIN sẽ gặp phải những thách thức gì?

Chúng tôi chọn lên mặt trăng trong thập kỷ này và làm những việc khác, không phải vì chúng dễ mà vì chúng khó.< /p>

——John Fitzgerald Kennedy

Lưu trữ phân tán và điện toán phân tán sử dụng DePIN mà không có sự tin cậy Vẫn còn nhiều thách thức trong việc xây dựng mô hình trí tuệ nhân tạo.

Xác minh công việc

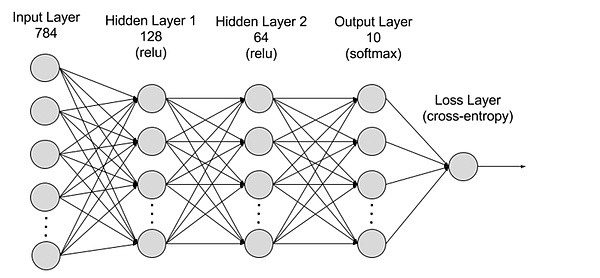

Về cơ bản, học sâu tính toán Cả hai mô hình và khai thác PoW là các phép tính có mục đích chung và lớp thấp nhất là sự thay đổi tín hiệu giữa các mạch cổng. Từ góc độ vĩ mô, khai thác PoW là một "phép tính vô dụng", cố gắng thu được giá trị băm với n số 0 được bắt đầu bằng vô số phép tính tạo số ngẫu nhiên và hàm băm; trong khi các phép tính học sâu là "các phép tính hữu ích", thông qua vô số việc tạo số ngẫu nhiên và tính toán hàm băm. Đạo hàm xuôi và đạo hàm lùi tính toán các giá trị tham số của từng lớp trong deep learning để xây dựng mô hình AI hiệu quả.

Thực tế là "các phép tính vô ích" như khai thác PoW sử dụng các hàm băm. Việc tính toán hình ảnh từ tiền ảnh rất dễ dàng và rất dễ dàng để tính toán tiền ảnh từ ảnh rất khó nên bất kỳ ai cũng có thể dễ dàng và nhanh chóng xác minh tính hợp lệ của phép tính, đối với việc tính toán mô hình deep learning, do cấu trúc phân cấp nên đầu ra của mỗi lớp được sử dụng làm đầu vào của lớp tiếp theo, do đó việc xác minh tính hợp lệ của phép tính đòi hỏi tất cả công việc trước đó không thể được xác minh một cách đơn giản và hiệu quả.

từ: AWS

Xác minh công việc là rất quan trọng, nếu không thì việc tính toán Nhà cung cấp hoàn toàn có thể bỏ qua việc tính toán và gửi kết quả được tạo ngẫu nhiên.

Một ý tưởng là cho phép các máy chủ khác nhau thực hiện các tác vụ tính toán giống nhau và xác minh tính hiệu quả của công việc bằng cách lặp lại quá trình thực thi và kiểm tra xem nó có giống nhau hay không. Tuy nhiên, phần lớn các tính toán mô hình là không xác định và không thể sao chép các kết quả tương tự ngay cả trong cùng một môi trường điện toán và chỉ có thể giống nhau theo nghĩa thống kê. Ngoài ra, việc tính hai lần sẽ dẫn đến chi phí tăng nhanh, điều này không phù hợp với mục tiêu chính của DePIN là giảm chi phí và tăng hiệu quả.

Một loại ý tưởng khác là cơ chế Optimistic, cơ chế này ban đầu tin tưởng một cách lạc quan rằng kết quả đã được tính toán một cách hiệu quả, đồng thời cho phép mọi người kiểm tra kết quả tính toán nếu phát hiện thấy sai sót, bạn có thể gửi Bằng chứng gian lận và thỏa thuận sẽ phạt kẻ lừa đảo và thưởng cho người báo cáo.

Song song hóa

Như đã đề cập trước đó, DePIN tận dụng Nó là chủ yếu là thị trường điện toán tiêu dùng dài hạn, có nghĩa là sức mạnh tính toán mà một thiết bị có thể cung cấp tương đối hạn chế. Đối với các mô hình AI lớn, việc đào tạo trên một thiết bị sẽ mất rất nhiều thời gian và phải sử dụng song song để rút ngắn thời gian đào tạo.

Khó khăn chính trong việc song song đào tạo deep learning nằm ở sự phụ thuộc giữa các nhiệm vụ trước đó và nhiệm vụ tiếp theo. Sự phụ thuộc này sẽ khiến cho việc song song hóa khó đạt được.

Hiện tại, việc song song hóa đào tạo deep learning chủ yếu được chia thành song song dữ liệu và song song mô hình.

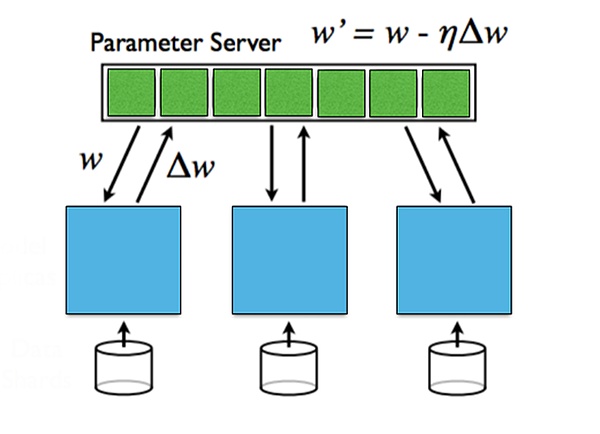

Song song dữ liệu đề cập đến việc phân phối dữ liệu trên nhiều máy. Mỗi máy lưu tất cả các tham số của một mô hình, sử dụng dữ liệu cục bộ để huấn luyện và cuối cùng huấn luyện các tham số của từng máy được tổng hợp. Song song dữ liệu hoạt động tốt khi lượng dữ liệu lớn, nhưng yêu cầu giao tiếp đồng bộ để tổng hợp các tham số.

Song song mô hình có nghĩa là khi kích thước của mô hình quá lớn để lắp vào một máy duy nhất, mô hình có thể được chia thành nhiều máy và mỗi máy sẽ tiết kiệm một phần tham số của mô hình. Tuyên truyền tiến và lùi yêu cầu giao tiếp giữa các máy khác nhau. Tính song song của mô hình có lợi thế khi mô hình lớn, nhưng chi phí truyền thông trong quá trình truyền tiến và truyền ngược lại lớn.

Đối với thông tin độ dốc giữa các lớp khác nhau, nó có thể được chia thành cập nhật đồng bộ và cập nhật không đồng bộ. Cập nhật đồng bộ đơn giản và trực tiếp nhưng sẽ làm tăng thời gian chờ đợi; thuật toán cập nhật không đồng bộ có thời gian chờ đợi ngắn nhưng sẽ gây ra các vấn đề về tính ổn định.

từ: Đại học Stanford, Học sâu song song và phân tán

Quyền riêng tư

Xu hướng toàn cầu về bảo vệ quyền riêng tư cá nhân đang gia tăng và các chính phủ trên thế giới đang tăng cường bảo vệ quyền riêng tư của dữ liệu cá nhân. Mặc dù AI sử dụng rộng rãi các bộ dữ liệu công cộng, nhưng điều thực sự khác biệt giữa các mô hình AI khác nhau là dữ liệu người dùng độc quyền của mỗi doanh nghiệp.

Làm cách nào để nhận được lợi ích từ dữ liệu độc quyền trong quá trình đào tạo mà không làm lộ quyền riêng tư? Làm thế nào để đảm bảo các thông số của mô hình AI được xây dựng không bị rò rỉ?

Đây là hai khía cạnh của quyền riêng tư, quyền riêng tư về dữ liệu và quyền riêng tư của mô hình. Quyền riêng tư dữ liệu bảo vệ người dùng, trong khi quyền riêng tư của mô hình bảo vệ tổ chức xây dựng mô hình. Trong tình hình hiện tại, quyền riêng tư dữ liệu quan trọng hơn nhiều so với quyền riêng tư của mô hình.

Có nhiều giải pháp đang cố gắng giải quyết vấn đề quyền riêng tư. Học tập liên kết đảm bảo quyền riêng tư của dữ liệu bằng cách đào tạo tại nguồn dữ liệu, lưu trữ dữ liệu cục bộ và truyền các tham số mô hình; và bằng chứng không có kiến thức có thể trở thành một ngôi sao đang lên.

Phân tích trường hợp: Có những dự án chất lượng cao nào trên thị trường?

Gensyn

Gensyn là một bản phân phối Mạng điện toán công thức để đào tạo các mô hình AI. Mạng sử dụng một lớp blockchain dựa trên Polkadot để xác minh rằng các tác vụ deep learning đã được thực thi chính xác và kích hoạt thanh toán thông qua các lệnh. Được thành lập vào năm 2020, nó đã tiết lộ khoản tài trợ Series A trị giá 43 triệu đô la Mỹ vào tháng 6 năm 2023, dẫn đầu là a16z.

Gensyn sử dụng siêu dữ liệu của các quy trình tối ưu hóa dựa trên độ dốc để xây dựng chứng chỉ của công việc đã thực hiện, phù hợp với các giao thức chính xác đa dạng, dựa trên biểu đồ và thực thi của người đánh giá chéo để cho phép công việc xác minh được chạy lại và so sánh về tính nhất quán và cuối cùng được xác nhận bởi chính chuỗi để đảm bảo tính hợp lệ của các tính toán. Để tăng cường hơn nữa độ tin cậy của việc xác minh công việc, Gensyn giới thiệu đặt cược để tạo động lực.

Có bốn loại người tham gia vào hệ thống: người gửi, người giải quyết, người xác minh và người báo cáo.

→ Người gửi là người dùng cuối của hệ thống, cung cấp các nhiệm vụ cần tính toán và trả tiền cho các đơn vị công việc đã hoàn thành.

→ Người giải quyết là nhân viên chính của hệ thống, thực hiện đào tạo mô hình và tạo bằng chứng để người xác minh kiểm tra.

Trình xác thực là chìa khóa để liên kết quá trình đào tạo không xác định với các phép tính tuyến tính xác định, sao chép các bằng chứng giải từng phần và so sánh khoảng cách với ngưỡng dự kiến.

Người cung cấp thông tin là tuyến phòng thủ cuối cùng, kiểm tra công việc của người xác minh và đưa ra các thử thách và được khen thưởng sau khi vượt qua các thử thách.

Người giải cần cam kết, người báo cáo sẽ kiểm tra công việc của người giải. Nếu phát hiện hành vi xấu sẽ thách thức. Sau khi thử thách vượt qua, token sẽ được nhận người giải quyết cam kết sẽ bị tịch thu, người tố cáo sẽ nhận được phần thưởng.

Theo dự đoán của Gensyn, giải pháp này được kỳ vọng sẽ giảm chi phí đào tạo xuống còn 1/5 so với các nhà cung cấp tập trung.

từ: Gensyn

FedML

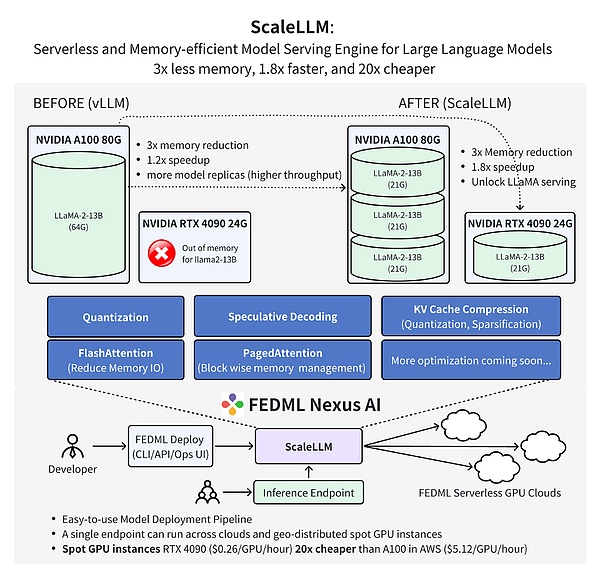

FedML là một nền tảng máy học cộng tác phi tập trung dành cho AI phi tập trung và cộng tác, ở mọi nơi và ở mọi quy mô. Cụ thể hơn, FedML cung cấp hệ sinh thái MLOps để đào tạo, triển khai, giám sát và liên tục cải tiến các mô hình học máy trong khi cộng tác trên dữ liệu, mô hình và tài nguyên máy tính kết hợp theo cách bảo vệ quyền riêng tư. Được thành lập vào năm 2022, FedML đã tiết lộ vòng hạt giống trị giá 6 triệu đô la vào tháng 3 năm 2023.

FedML bao gồm hai thành phần chính là FedML-API và FedML-core, lần lượt đại diện cho API cấp cao và API cấp thấp.

FedML-core bao gồm hai mô-đun độc lập: giao tiếp phân tán và đào tạo mô hình. Mô-đun giao tiếp chịu trách nhiệm về giao tiếp cơ bản giữa các nhân viên/khách hàng khác nhau và dựa trên MPI; mô-đun đào tạo mô hình dựa trên PyTorch.

FedML-API được xây dựng trên lõi FedML. Với FedML-core, các thuật toán phân tán mới có thể được triển khai dễ dàng bằng cách áp dụng các giao diện lập trình hướng tới khách hàng.

Công trình mới nhất của nhóm FedML đã chứng minh rằng việc sử dụng FedML Nexus AI để thực hiện suy luận mô hình AI trên GPU RTX 4090 dành cho người tiêu dùng rẻ hơn 20 lần và nhanh hơn 1,88 lần hơn A100.

từ: FedML

Tầm nhìn tương lai: DePIN mang đến Dân chủ AI

Một ngày nào đó, AI sẽ phát triển hơn nữa thành AGI và sức mạnh tính toán sẽ trở thành loại tiền tệ phổ quát trên thực tế. DePIN sẽ thúc đẩy quá trình này diễn ra .

Sự tích hợp giữa AI và DePIN đã mở ra một điểm tăng trưởng công nghệ mới và mang lại cơ hội lớn cho sự phát triển của trí tuệ nhân tạo. DePIN cung cấp cho AI sức mạnh tính toán và dữ liệu phân tán khổng lồ, giúp đào tạo các mô hình quy mô lớn hơn và đạt được trí thông minh mạnh mẽ hơn. Đồng thời, DePIN cũng cho phép AI phát triển theo hướng cởi mở, an toàn và đáng tin cậy hơn, giảm sự phụ thuộc vào một cơ sở hạ tầng tập trung duy nhất.

Nhìn về tương lai, AI và DePIN sẽ tiếp tục hợp tác phát triển. Mạng phân tán sẽ cung cấp nền tảng vững chắc cho việc đào tạo các mô hình rất lớn và những mô hình này sẽ đóng một vai trò quan trọng trong việc ứng dụng DePIN. Bên cạnh việc bảo vệ quyền riêng tư và bảo mật, AI cũng sẽ giúp tối ưu hóa các giao thức và thuật toán mạng DePIN. Chúng tôi mong muốn AI và DePIN mang đến một thế giới kỹ thuật số hiệu quả hơn, công bằng hơn và đáng tin cậy hơn.

JinseFinance

JinseFinance

JinseFinance

JinseFinance Brian

Brian JinseFinance

JinseFinance Hui Xin

Hui Xin Bitcoinworld

Bitcoinworld Ledgerinsights

Ledgerinsights Beincrypto

Beincrypto Cointelegraph

Cointelegraph Cointelegraph

Cointelegraph Cointelegraph

Cointelegraph