Tweet 13 lần liên tiếp!

Giám đốc liên kết siêu cấp của OpenAI Jan Leike, người vừa theo chân Ilya rời công ty, đã tiết lộ lý do thực sự khiến họ rời công ty và Thêm bên trong.

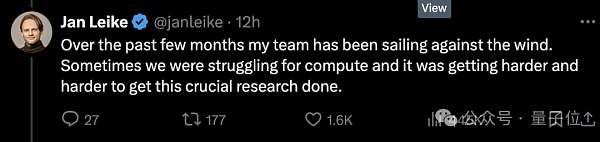

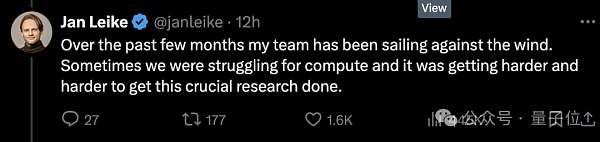

Trước hết, sức mạnh tính toán là không đủ và 20% đã hứa với nhóm siêu liên kết là thiếu tiền , khiến nhóm đi ngược lại xu hướng. Nhưng mọi chuyện ngày càng khó khăn hơn.

Thứ hai, vấn đề bảo mật không được coi trọng. Việc quản lý bảo mật của AGI không được ưu tiên cao bằng việc tung ra "sản phẩm tỏa sáng".

Ngay sau đó, người khác lại bới ra thêm tin đồn nhảm.

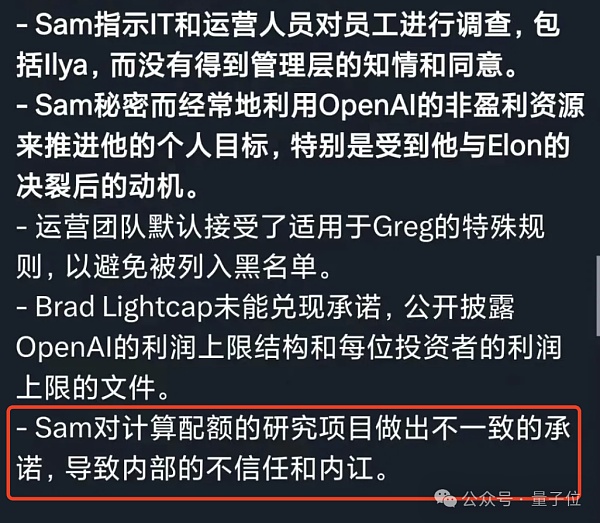

Ví dụ: mọi thành viên rời OpenAI đều phải ký thỏa thuận, hứa không nói xấu OpenAI ra bên ngoài sau khi từ chức, nếu không sẽ sẽ được coi là tự động Từ bỏ cổ phiếu công ty.

Tuy nhiên, vẫn có người không chịu ký và đưa ra những tin tức gay gắt (cười chết người), cho rằng ban lãnh đạo nòng cốt có những khác biệt lâu dài về mức độ ưu tiên của vấn đề an ninh.

Kể từ cuộc chiến trong cung điện năm ngoái, mâu thuẫn tư tưởng giữa hai phe đã đến mức nghiêm trọng và dường như họ đã sụp đổ một cách trang nghiêm.

Vì vậy, mặc dù Ultraman đã cử người đồng sáng lập đến tiếp quản nhóm Super Alignment nhưng vẫn không được thế giới bên ngoài ưa chuộng.

Cư dân mạng Twitter đi đầu cảm ơn Jan vì đã can đảm lên tiếng về điều tuyệt vời này và thở dài:

Tôi sẽ tiếp tục và có vẻ như OpenAI thực sự không quan tâm nhiều đến vấn đề bảo mật này!

Nhưng nhìn lại, Ultraman, người hiện đang phụ trách OpenAI, vẫn có thể ngồi yên ở thời điểm hiện tại.

Anh ấy đứng lên và cảm ơn Jan vì những đóng góp của anh ấy cho siêu liên kết và bảo mật OpenAI, nói rằng anh ấy thực sự rất buồn và không muốn rời khỏi Jan.

Tất nhiên, điểm mấu chốt thực ra là câu này:

Đợi đã, vượt qua, tôi sẽ đăng một tweet dài hơn thế này trong hai ngày nữa.

Sức mạnh tính toán 20% được hứa hẹn thực sự là một miếng bánh lớn

Từ trận chiến cung điện OpenAI năm ngoái đến nay, nhân vật linh hồn và cựu nhà khoa học trưởng Ilya đã có hầu như không xuất hiện và lên tiếng công khai nữa.

Trước khi ông công khai tuyên bố từ chức, đã có nhiều ý kiến khác nhau. Nhiều người cho rằng Ilya đã nhìn thấy điều gì đó khủng khiếp, chẳng hạn như hệ thống AI có thể hủy diệt loài người.

△Netizen: Điều đầu tiên tôi làm khi thức dậy mỗi ngày là nghĩ về những gì Ilya đã thấy

Lần này Jan mở lời và cho rằng nguyên nhân cốt lõi là bên kỹ thuật và bên thị trường có quan điểm khác nhau về mức độ ưu tiên bảo mật.

Sự khác biệt là nghiêm trọng và hậu quả hiện tại... mọi người đều đã thấy.

Theo Vox, các nguồn tin quen thuộc với OpenAI tiết lộ rằng những nhân viên tập trung hơn vào sự an toàn đã mất niềm tin vào Ultraman, " Đó là một quá trình niềm tin bị phá vỡ từng chút một.”

Nhưng như bạn có thể thấy, không có nhiều nhân viên đã nghỉ việc sẵn sàng nói về vấn đề này một cách công khai trên các nền tảng và dịp công cộng.

Một phần lý do là OpenAI có lịch sử yêu cầu nhân viên ký thỏa thuận thôi việc với các thỏa thuận không chê bai. Nếu bạn từ chối ký, bạn sẽ từ bỏ các tùy chọn OpenAI mà bạn đã nhận trước đó. Điều này có nghĩa là những nhân viên lên tiếng có thể bị mất một khoản tiền rất lớn.

Tuy nhiên, các quân domino vẫn lần lượt đổ——

Việc Ilya từ chức càng làm tăng thêm sự thất bại của OpenAI làn sóng khởi hành gần đây.

Sau thông báo từ chức, ngoài Jan, trưởng nhóm Super Alignment, ít nhất 5 thành viên của đội an ninh đã từ chức.

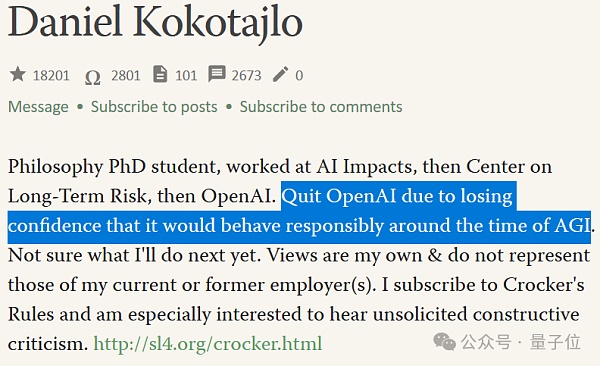

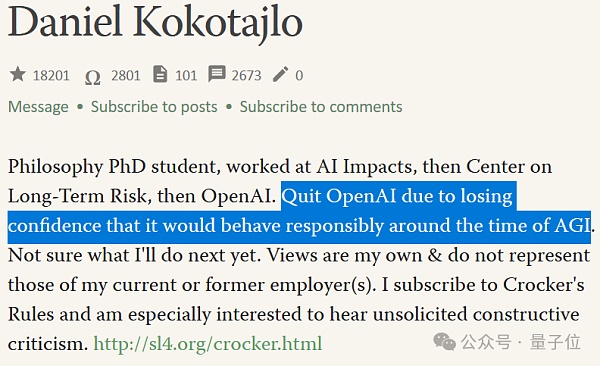

Trong số đó có Daniel Kokotajlo (sau đây gọi là Anh DK), người chưa ký thỏa thuận không chê bai.

△Năm ngoái, Anh DK đã viết rằng anh tin rằng khả năng xảy ra thảm họa hiện hữu trong AI là 70%

Anh DK gia nhập OpenAI vào năm 2022 và làm việc trong nhóm quản trị. Công việc chính của anh là hướng dẫn OpenAI triển khai AI một cách an toàn.

Nhưng gần đây anh ấy cũng đã từ chức và nhận lời phỏng vấn:

OpenAI đang thực hiện mục tiêu đào tạo các hệ thống AI mạnh hơn cuối cùng sẽ vượt qua trí thông minh của con người.

Đây có thể là điều tốt nhất từng xảy ra với nhân loại, nhưng cũng có thể là điều tồi tệ nhất nếu chúng ta không hành động cẩn thận.

Anh DK giải thích rằng khi gia nhập OpenAI, anh tràn đầy sự trả thù và hy vọng vào việc quản trị an ninh, hy vọng rằng OpenAI sẽ trở nên có trách nhiệm hơn khi tiến gần hơn đến AGI . Nhưng nhiều người trong nhóm dần dần nhận ra rằng điều này sẽ không xảy ra với OpenAI.

"Dần dần mất niềm tin vào ban lãnh đạo OpenAO và khả năng xử lý AGI một cách có trách nhiệm của họ." Đây là lý do khiến Brother DK từ chức.

Thất vọng về tương lai của công tác an ninh AGI là một phần nguyên nhân khiến Ilya gia tăng làn sóng rời đi.

Một phần lý do lànhóm Super Alignment có thể không có nhiều nguồn lực để tiến hành nghiên cứu như thế giới bên ngoài tưởng tượng.

Ngay cả khi nhóm Super Alignment hoạt động hết công suất, nhóm cũng chỉ có thể đạt được 20% sức mạnh tính toán mà OpenAI đã hứa.

Và một số yêu cầu của nhóm thường bị từ chối.

Tất nhiên, điều này là do tài nguyên máy tính cực kỳ quan trọng đối với các công ty AI và mọi điểm phải được phân bổ hợp lý và cũng vì công việc của nhóm Super Alignment; là để "giải quyết vấn đề nếu công ty xây dựng AGI thành công, các loại vấn đề bảo mật khác nhau thực sự phát sinh."

Nói cách khác, Nhóm siêu liên kết tương ứng với các vấn đề bảo mật trong tương lai mà OpenAI cần phải đối mặt—những điểm chính nằm trong tương lai và chúng tôi không biết liệu chúng có xuất hiện hay không.

Tính đến thời điểm viết bài, Ultraman vẫn chưa gửi "tweet dài hơn (so với tiết lộ nội dung bên trong của Jan)".

Nhưng anh ấy đề cập ngắn gọn rằng Jan đã đúng khi lo ngại về các vấn đề an toàn, "Chúng tôi vẫn còn nhiều việc phải làm; chúng tôi cũng cam kết về điều này Hãy làm đi ”

Về điểm này, mọi người có thể kê một chiếc ghế dài nhỏ và chờ đợi, sau đó chúng ta có thể ăn cùng nhau càng sớm càng tốt.

Tóm lại, rất nhiều người đã rời khỏi đội Super Alignment, đặc biệt là sự ra đi của Ilya và Jan, khiến đội bóng đầy giông bão này không còn người lãnh đạo.

Các thỏa thuận tiếp theo sẽ do người đồng sáng lập John Schulma đảm nhận, nhưng không còn một nhóm chuyên trách nữa.

Nhóm Super Alignment mới sẽ là một nhóm lỏng lẻo hơn với các thành viên trải rộng khắp các phòng ban trong công ty, điều mà người phát ngôn của OpenAI mô tả là "Tích hợp sâu hơn".

Điều này cũng đã bị thế giới bên ngoài nghi ngờ, bởi vì Công việc toàn thời gian ban đầu của John là đảm bảo tính bảo mật cho các sản phẩm OpenAI hiện tại .

Tôi tự hỏi liệu John có thể bận rộn sau khi đột nhiên có nhiều trách nhiệm hơn và lãnh đạo hai nhóm tập trung vào các vấn đề bảo mật hiện tại và tương lai không?

Tranh chấp Ilya-Altman

Nếu dòng thời gian bị kéo dài ra, tình hình ngày nay thực sự sẽ sụp đổ Đây là phần tiếp theo của cuộc tranh chấp Ilya-Altman "Palace Fight" OpenAI.

Trở lại tháng 11 năm ngoái, khi Ilya vẫn còn ở đó, ông đã làm việc với ban giám đốc OpenAI để cố gắng sa thải Altman.

Lý do được đưa ra lúc đó là anh không thành thật trong cách giao tiếp. Nói cách khác, chúng tôi không tin tưởng anh ta.

Nhưng kết quả cuối cùng là hiển nhiên. Altman dọa gia nhập Microsoft cùng với các "đồng minh" của mình. việc thu hồi không thành công. Ilya rời khỏi ban giám đốc. Ultraman về phía mình đã chọn những thành viên có lợi hơn cho mình để tham gia vào ban giám đốc.

Sau đó, Ilya biến mất khỏi mạng xã hội cho đến khi có thông báo chính thức về việc từ chức vài ngày trước. Và người ta nói rằng anh ấy đã không xuất hiện ở văn phòng OpenAI trong khoảng 6 tháng.

Anh ấy cũng để lại một dòng tweet hấp dẫn vào thời điểm đó, nhưng nó nhanh chóng bị xóa.

Trong tháng vừa qua, tôi đã học được rất nhiều bài học. Một trong những bài học là câu “đánh đập sẽ tiếp tục cho đến khi tinh thần được cải thiện” được áp dụng thường xuyên hơn mức cần thiết.

Nhưng theo những người trong cuộc, Ilya đã đồng lãnh đạo nhóm Super Alignment từ xa.

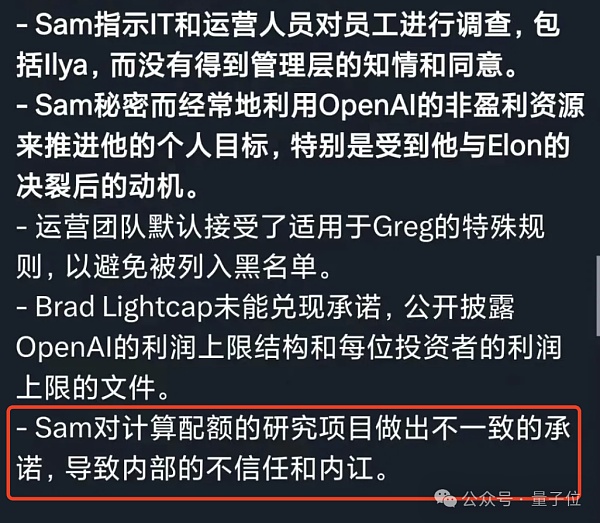

Đối với Ultraman, lời buộc tội lớn nhất của nhân viên đối với anh là lời nói và hành động của anh không nhất quán. Ví dụ, anh tuyên bố rằng anh muốn ưu tiên sự an toàn, nhưng thực tế là anh không thể làm được điều đó. hành vi của mình Nhưng rất mâu thuẫn.

Ngoại trừ việc các tài nguyên máy tính đã hứa ban đầu không được cung cấp. Ví dụ: gần đây chúng tôi đã tiếp cận Ả Rập Saudi và các nước khác để gây quỹ sản xuất lõi.

Những nhân viên chú ý đến an toàn sẽ bối rối.

Nếu thực sự quan tâm đến việc xây dựng và triển khai trí tuệ nhân tạo theo cách an toàn nhất có thể, chẳng phải ông ấy sẽ điên cuồng tích lũy chip để đẩy nhanh sự phát triển của công nghệ sao? ?

Trước đó, OpenAI đã đặt mua chip từ một công ty khởi nghiệp do Altman đầu tư. Số tiền lên tới 51 triệu USD (khoảng 360 triệu RMB).

Mô tả về Ultraman dường như đã được xác nhận một lần nữa trong thư báo cáo của một cựu nhân viên OpenAI thời Gong Dou.

Chính vì "sự khác biệt giữa lời nói và việc làm" mà nhân viên dần mất niềm tin vào OpenAI và Ultraman.

Ilya là thế này, Jan Laike là thế này, và nhóm Super Alignment là thế này.

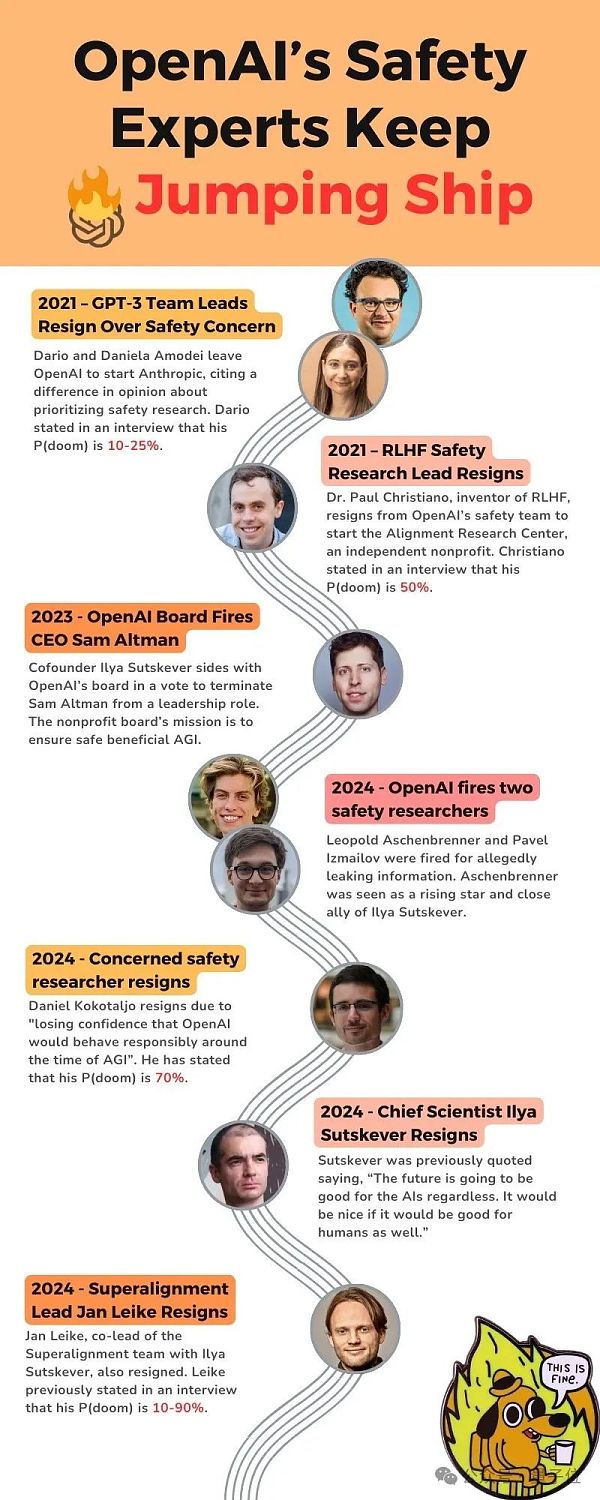

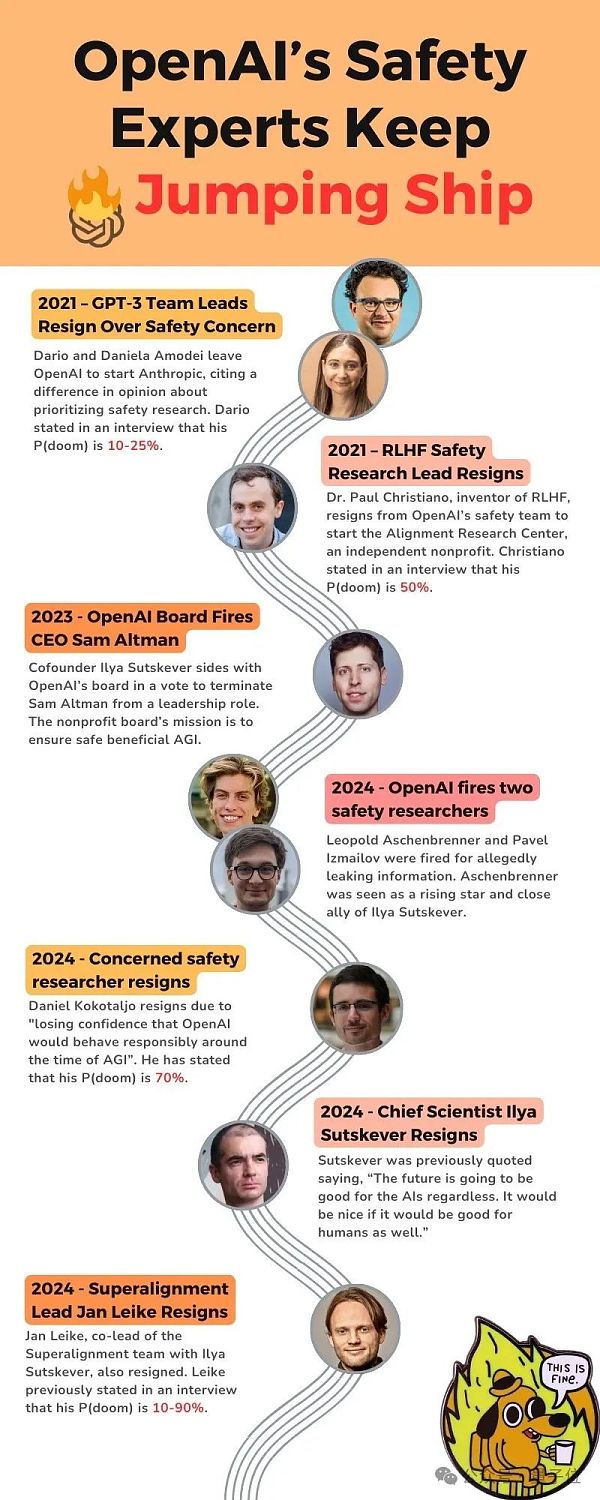

Một số cư dân mạng chu đáo đã sắp xếp các nút quan trọng của những sự việc có liên quan đã xảy ra trong vài năm qua - hãy để tôi đưa ra cho bạn một lời nhắc nhở chu đáo, được đề cập bên dưới P (sự diệt vong)đề cập đến “khả năng AI gây ra kịch bản ngày tận thế”.

Năm 2021, trưởng nhóm GPT-3 rời OpenAI do vấn đề "bảo mật" và thành lập Anthropic; 10-25% ;

Năm 2021, người đứng đầu nghiên cứu bảo mật RLHF từ chức, P (doom) là 50%;

Năm 2023, ban giám đốc OpenAI đã sa thải Altman;

Năm 2024, OpenAI đã sa thải hai nhà nghiên cứu bảo mật;

< p style="text -align: left;">Vào năm 2024, một nhà nghiên cứu OpenAI, người đặc biệt quan tâm đến bảo mật, đã từ chức. Ông tin rằng P (sự diệt vong) đã ở mức 70%.

Năm 2024, Ilya và JAN Laike từ chức.

Công nghệ hay thị trường?

Vì sự phát triển của các mô hình lớn, "làm thế nào để triển khai AGI?" thực sự có thể được quy cho hai con đường.

Trường kỹ thuật hy vọng rằng công nghệ này sẽ hoàn thiện và có thể kiểm soát được trước khi ứng dụng; Trường phái thị trường tin rằng điều đó sẽ được mở và áp dụng cùng một lúc.

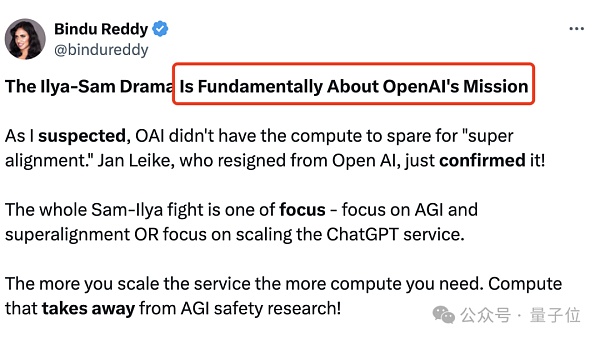

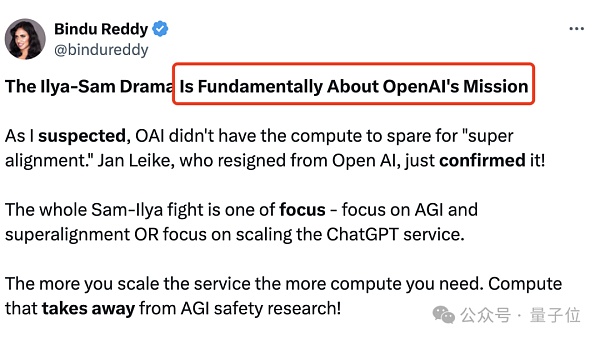

Đây cũng là điểm khác biệt cơ bản trong tranh chấp Ilya-Altman, cụ thể là sứ mệnh của OpenAI:

Chúng ta nên tập trung vào AGI và siêu liên kết hay nên tập trung mở rộng dịch vụ ChatGPT?

Quy mô dịch vụ ChatGPT càng lớn thì khối lượng tính toán cần thiết càng lớn; điều này cũng sẽ tiêu tốn thời gian cho nghiên cứu bảo mật AGI.

Nếu OpenAI là một tổ chức phi lợi nhuận chuyên nghiên cứu, họ nên dành nhiều thời gian hơn cho việc siêu liên kết.

Đánh giá từ một số sáng kiến bên ngoài của OpenAI, kết quả rõ ràng là không Họ chỉ muốn dẫn đầu trong cuộc cạnh tranh của các mô hình lớn và cung cấp cho doanh nghiệp. với và nhiều dịch vụ hơncho người tiêu dùng.

Theo Ilya, đây là một điều rất nguy hiểm. Mặc dù chúng tôi không biết điều gì sẽ xảy ra khi quy mô tăng lên, theo ý kiến của Ilya, cách tiếp cận tốt nhất là đặt sự an toàn lên hàng đầu.

Hãy cởi mở và minh bạch để con người chúng ta có thể đảm bảo rằng AGI được xây dựng một cách an toàn chứ không phải theo cách bí mật nào đó.

Nhưng dưới sự lãnh đạo của Ultraman, OpenAI dường như không theo đuổi nguồn mở hay siêu liên kết. Thay vào đó, nó tập trung vào việc chạy điên cuồng theo hướng AGI trong khi cố gắng xây dựng một con hào.

Vậy cuối cùng, nhà khoa học AI Ilya đã đưa ra lựa chọn đúng đắn hay doanh nhân Ultraman ở Thung lũng Silicon sẽ đi đến cùng?

Chưa có cách nào để biết. Nhưng ít nhất OpenAI hiện phải đối mặt với một quyết định quan trọng.

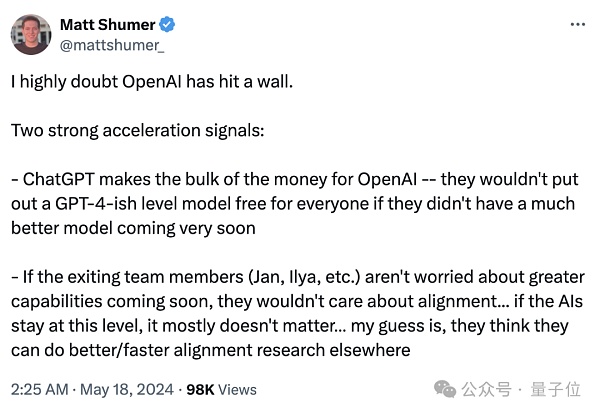

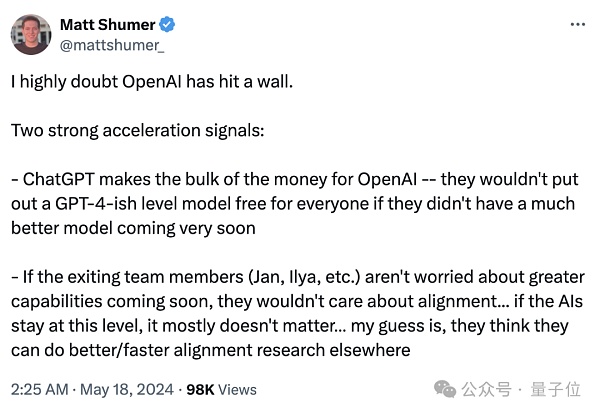

Một số người trong ngành đã tóm tắt hai tín hiệu chính,

Một< /p> strong>Có ChatGPT là nguồn thu chính của OpenAI. Nếu không có sự hỗ trợ mô hình tốt hơn, GPT-4 sẽ không được cung cấp miễn phí cho mọi người;

Một điều nữalà nếu các thành viên trong nhóm sắp rời đi (Jan, Ilya, v.v.) không lo lắng về việc sắp ra mắt các tính năng mạnh mẽ hơn, họ sẽ không quan tâm đến vấn đề liên kết… Nếu AI vẫn ở mức này thì về cơ bản nó không thành vấn đề.

Nhưng mâu thuẫn cơ bản của OpenAI vẫn chưa được giải quyết. Một mặt là những lo ngại của các nhà khoa học AI ăn trộm lửa về sự phát triển có trách nhiệm của AGI, mặt khác là sự cấp bách của Silicon Các bên tham gia thị trường ở Thung lũng nhằm thúc đẩy tính bền vững của công nghệ thông qua thương mại hóa.

Hai bên không thể hòa giải. Nhóm khoa học hoàn toàn đứng ngoài OpenAI, thế giới bên ngoài vẫn chưa biết GPT đã vươn tới đâu?

Những người nóng lòng muốn biết câu trả lời cho câu hỏi này đều hơi mệt mỏi.

Một cảm giác bất lực dâng lên trong lòng tôi, giống như giáo viên Hinton của Ilya, một trong ba người khổng lồ của Giải thưởng Turing, đã nói:

Tôi già rồi, tôi lo lắng nhưng chẳng thể làm gì được.

Liên kết tham khảo:

[1]https://www.vox.com/future-perfect/2024/5/17/ 24158403/openai-resignations-ai-safety-ilya-sutskever-jan-leike-artificial-intelligence

[2]https://x.com/janleike/status/1791498174659715494

[3]https:// twitter.com/sama/status/1791543264090472660

JinseFinance

JinseFinance