Nguồn: Heart of the Machine

Các mô hình ngôn ngữ lớn vẫn có thể tạo ra những bước đột phá và OpenAI một lần nữa đã chứng minh được sức mạnh của mình.

Nửa đêm ngày 13 tháng 9 theo giờ Bắc Kinh, OpenAI đã chính thức trình làng hàng loạt mô hình AI cỡ lớn mới được thiết kế đặc biệt để giải quyết các vấn đề khó khăn. Đây là một bước đột phá lớn, mô hình mới có thể cho phép suy luận phức tạp, một mô hình phổ quát để giải quyết các vấn đề khó khăn hơn các mô hình khoa học, mã và toán học trước đây có thể làm được.

OpenAI cho biết những gì mới được phát hành trong ChatGPT và API mô hình lớn ngày nay là Mô hình đầu tiên trong chuỗi và chỉ là phiên bản xem trước - o1-preview. Ngoài o1, OpenAI cũng trình bày đánh giá về bản cập nhật tiếp theo hiện đang được phát triển.

Mô hình o1 lập nhiều kỷ lục lịch sử trong một lần thất bại.

Trước hết, o1 là mô hình dâu tây cỡ lớn mà OpenAI đã "quảng cáo rầm rộ" từ Ultraman Sam đến các nhà khoa học. Nó sở hữu khả năng lý luận thực sự phổ quát. Nó đã thể hiện sức mạnh siêu phàm trong một loạt các bài kiểm tra điểm chuẩn khó khăn. So với GPT-4o, nó đã được cải thiện rất nhiều, cho phép giới hạn trên của các mẫu xe lớn tăng trực tiếp từ mức “vô hình” lên mức xuất sắc. huy chương trong Olympic Toán học mà không cần đào tạo đặc biệt và thậm chí có thể vượt trội hơn các chuyên gia về con người trong các buổi hỏi đáp khoa học cấp tiến sĩ.

Ultraman nói rằng mặc dù màn trình diễn của O1 vẫn còn những sai sót nhưng bạn vẫn là một cú sốc lần đầu tiên bạn sử dụng nó.

Thứ hai, o1 mang đến một chiều hướng mới cho đường cong mở rộng quy mô mô hình lớn so với hiệu suất. Nó tái tạo thành công của việc học tăng cường của AlphaGo trong lĩnh vực mô hình lớn - nó càng mang lại nhiều sức mạnh tính toán thì càng tạo ra nhiều trí thông minh hơn, cho đến khi vượt qua trình độ của con người.

Nói cách khác, từ góc độ phương pháp luận, mô hình lớn o1 lần đầu tiên đã chứng minh rằng một mô hình ngôn ngữ có thể thực hiện việc học tăng cường thực sự.

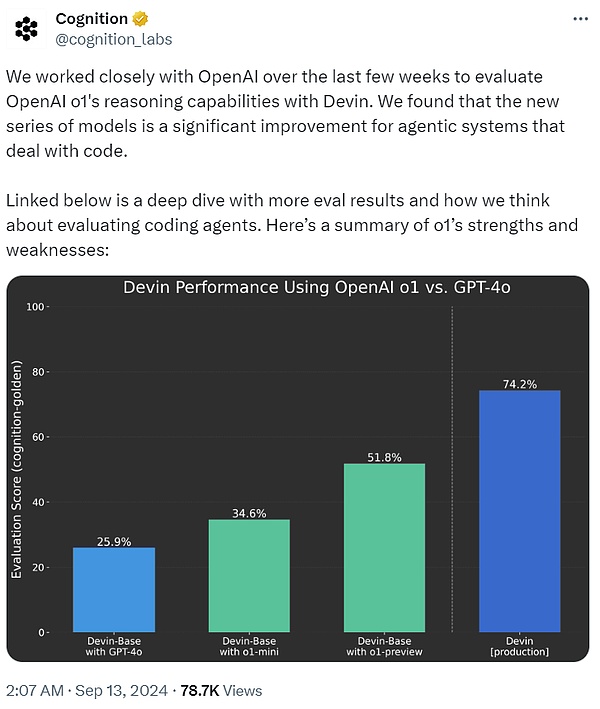

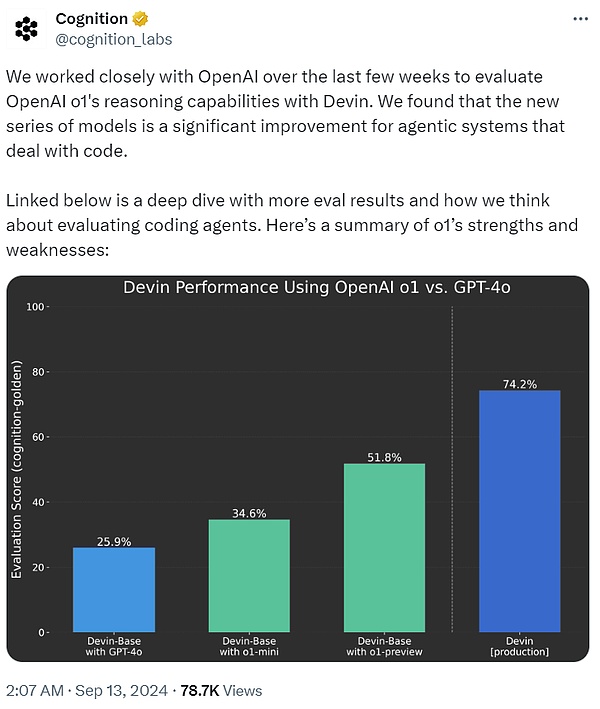

Cognition AI, công ty đã phát triển kỹ sư phần mềm AI đầu tiên Devin, đã nói rằng trong vài tuần qua Chúng tôi đã hợp tác chặt chẽ với OpenAI để sử dụng Devin nhằm đánh giá khả năng suy luận của o1. Người ta nhận thấy rằng so với GPT-4o, dòng mô hình o1 là một cải tiến đáng kể cho các hệ thống tác nhân xử lý mã.

Cuối cùng, trong thực tế, sau khi o1 lên mạng, ChatGPT giờ đây có thể trả lời các câu hỏi trước Think hãy cẩn thận trước thay vì buột miệng trả lời ngay. Cũng giống như Hệ thống 1 và Hệ thống 2 của bộ não con người, ChatGPT đã phát triển từ việc chỉ sử dụng Hệ thống 1 (nhanh, tự động, trực quan, dễ mắc lỗi) sang sử dụng tư duy Hệ thống 2 (chậm, thận trọng, nhận thức, đáng tin cậy). Điều này cho phép nó giải quyết các vấn đề không thể giải quyết trước đây.

Đánh giá từ trải nghiệm người dùng ChatGPT ngày nay, đây là một bước tiến nhỏ. Với những lời nhắc đơn giản, người dùng có thể không nhận thấy nhiều sự khác biệt, nhưng nếu họ hỏi một số câu hỏi toán học hoặc mã hóa phức tạp, sự khác biệt sẽ bắt đầu trở nên rõ ràng. Quan trọng hơn, con đường phía trước đã bắt đầu xuất hiện.

Nói chung, bom tấn do OpenAI tung ra tối nay đã gây sốc cho toàn bộ cộng đồng AI. Họ đều tỏ ra tql, không ngủ được và bắt đầu học đến khuya. Tiếp theo, chúng ta hãy xem các chi tiết kỹ thuật của mô hình lớn OpenAI o1.

Cách thức hoạt động của OpenAI o1

Trong blog kỹ thuật "Học cách lập luận với LLM", OpenAI đã giới thiệu kỹ thuật chi tiết về loạt mô hình ngôn ngữ o1 .

OpenAI o1 là một mô hình ngôn ngữ mới được đào tạo bằng phương pháp học tăng cường để thực hiện các tác vụ suy luận phức tạp. Đặc điểm là o1 sẽ suy nghĩ trước khi trả lời - nó có thể tạo ra một chuỗi suy nghĩ nội bộ dài trước khi trả lời người dùng.

Tức là, mô hình cần dành nhiều thời gian hơn để suy nghĩ về vấn đề giống như con người trước khi phản ứng. Thông qua đào tạo, họ học cách tinh chỉnh quá trình suy nghĩ của mình, thử các chiến lược khác nhau và nhận ra sai lầm của mình.

Trong các thử nghiệm của OpenAI, các mô hình sau này trong chuỗi hoạt động tương tự như các nghiên cứu sinh tiến sĩ trong các nhiệm vụ tiêu chuẩn đầy thử thách về vật lý, hóa học và sinh học. OpenAI cũng được đánh giá là vượt trội về toán và mã hóa.

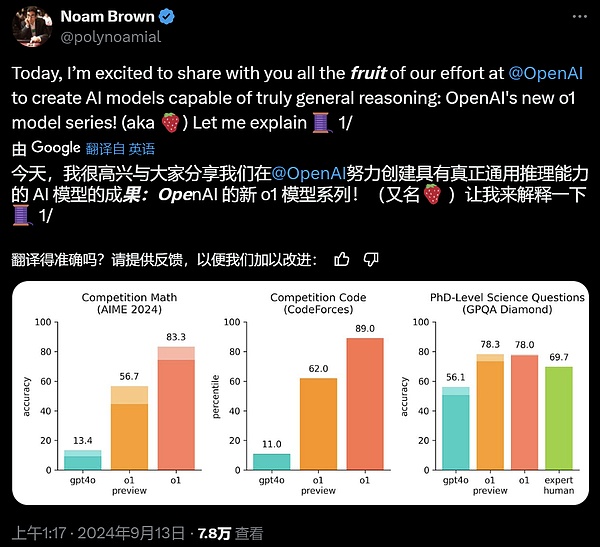

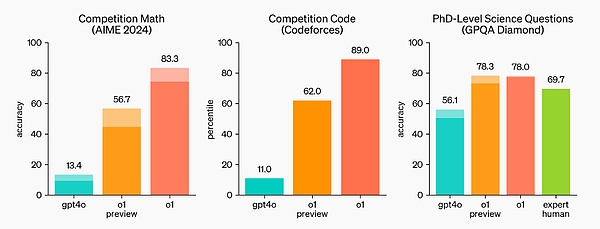

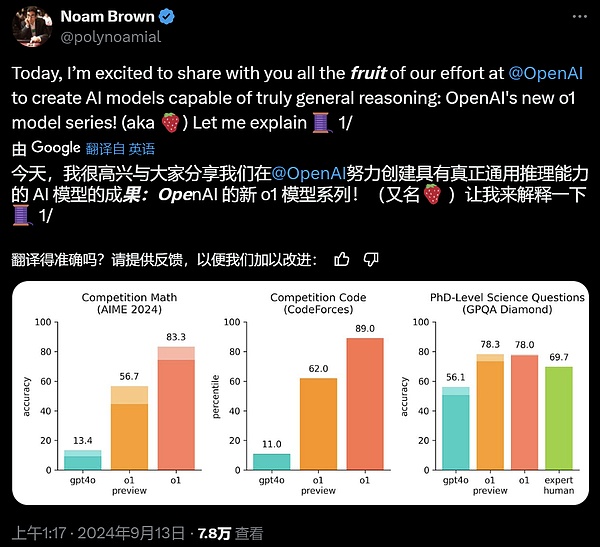

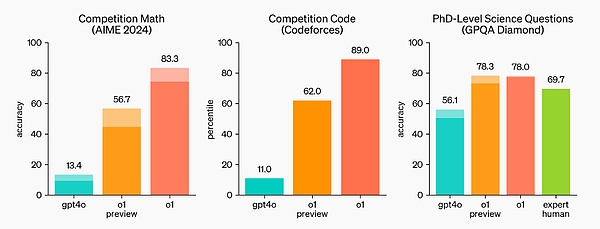

Trong kỳ thi vòng loại Olympic Toán quốc tế (IMO), GPT-4o chỉ trả lời đúng 13% số câu hỏi, trong khi mẫu o1 trả lời đúng 83% số câu hỏi.

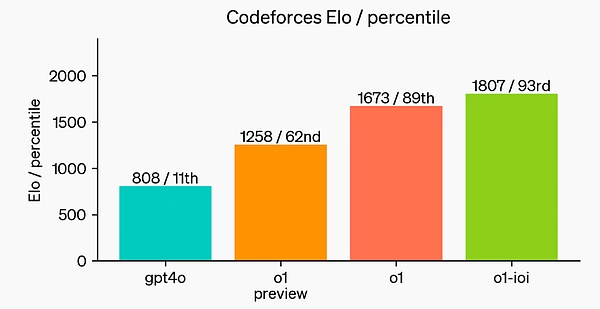

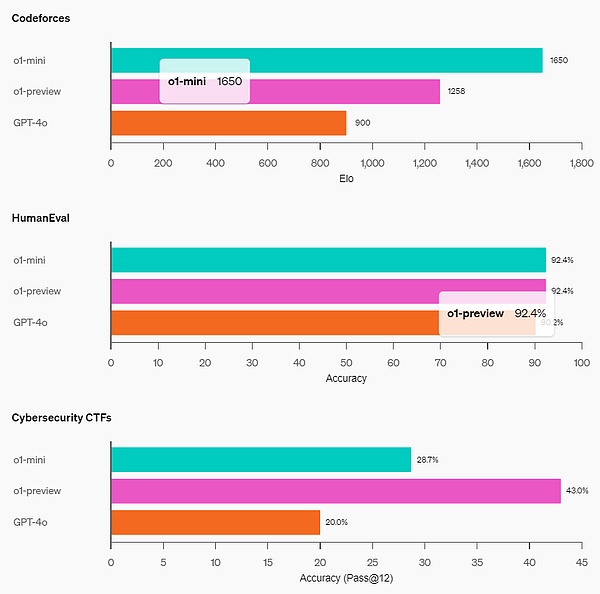

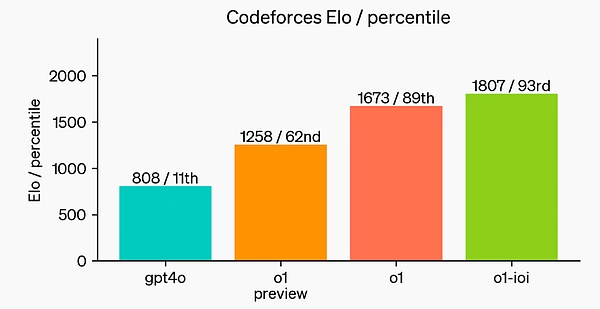

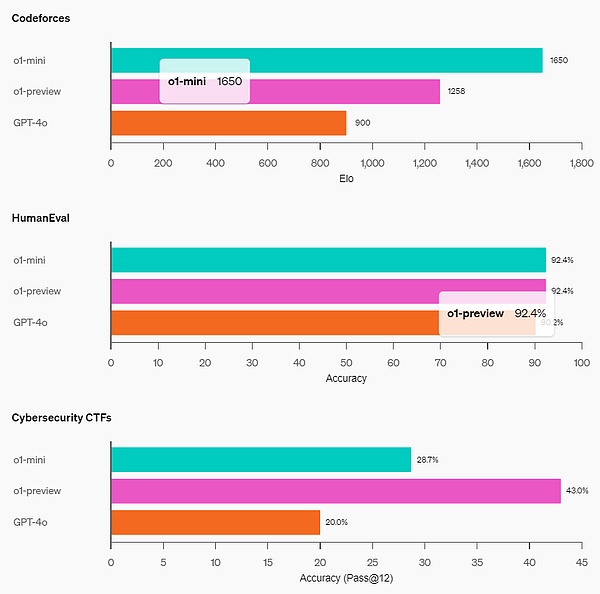

Khả năng mã hóa của mô hình cũng được đánh giá trong cuộc thi, xếp hạng 89% trong cuộc thi Codeforces.

OpenAI cho biết, là mô hình ban đầu, nó chưa có nhiều tính năng hữu ích của ChatGPT, chẳng hạn như duyệt web để tìm thông tin cũng như tải tệp và hình ảnh lên.

Nhưng đối với các nhiệm vụ suy luận phức tạp, đây là một bước tiến đáng kể và thể hiện một cấp độ mới về khả năng trí tuệ nhân tạo. Do đó, OpenAI đặt lại bộ đếm về 1 và đặt tên cho dòng mô hình là OpenAI o1.

Điểm mấu chốt là Thuật toán học tăng cường quy mô lớn của OpenAI dạy mô hình cách sử dụng chuỗi suy nghĩ của nó để suy nghĩ hiệu quả trong quá trình đào tạo với dữ liệu hiệu quả cao. Nói cách khác, tương tự như Quy luật mở rộng của việc học tăng cường.

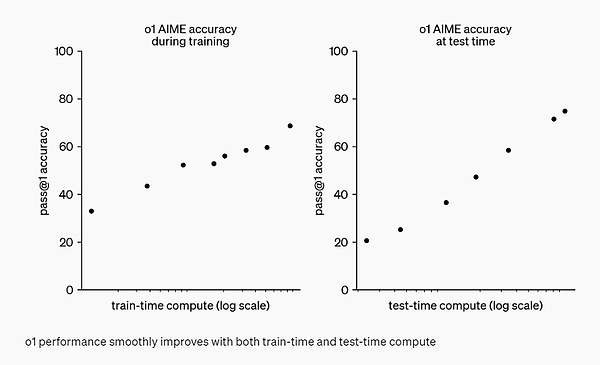

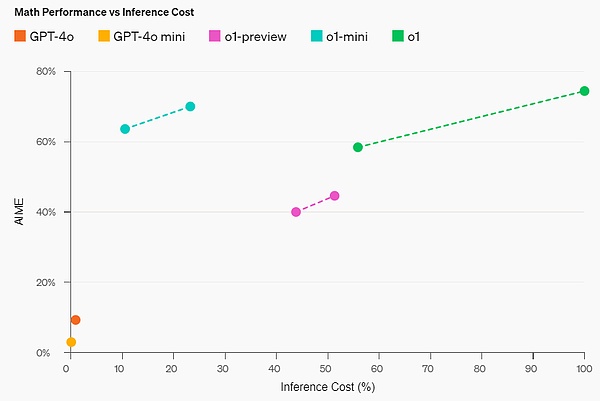

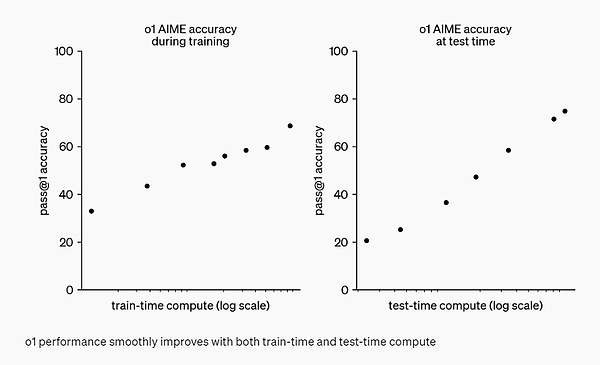

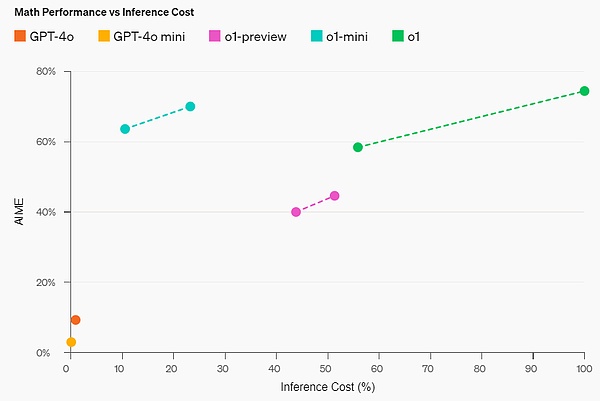

OpenAI nhận thấy rằng hiệu suất của o1 tiếp tục được cải thiện nhờ học tập tăng cường nhiều hơn (được tính toán trong thời gian đào tạo) và nhiều thời gian suy nghĩ hơn (được tính toán trong thời gian kiểm tra). Và những hạn chế của việc mở rộng quy mô phương pháp này rất khác với những hạn chế của đào tạo trước mô hình lớn mà OpenAI vẫn tiếp tục nghiên cứu.

Đánh giá

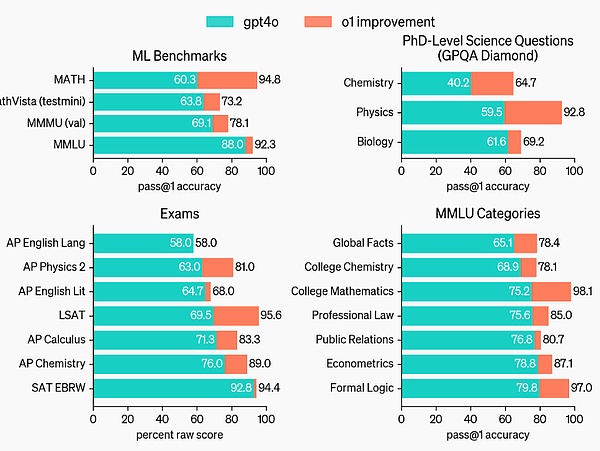

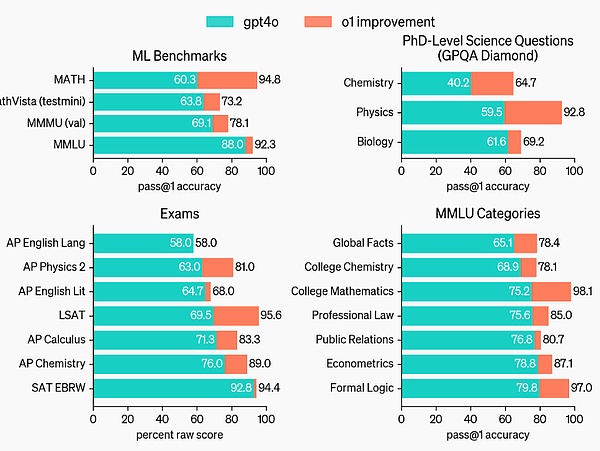

Dành cho Nêu bật những cải tiến về hiệu suất suy luận so với GPT-4o, OpenAI đã thử nghiệm mô hình o1 trên một loạt các bài kiểm tra con người và điểm chuẩn học máy khác nhau. Kết quả thử nghiệm cho thấy o1 hoạt động tốt hơn đáng kể so với GPT-4o trong phần lớn các tác vụ lý luận.

o1 cung cấp những cải tiến đáng kể so với GPT-4o về các tiêu chuẩn suy luận đầy thách thức.

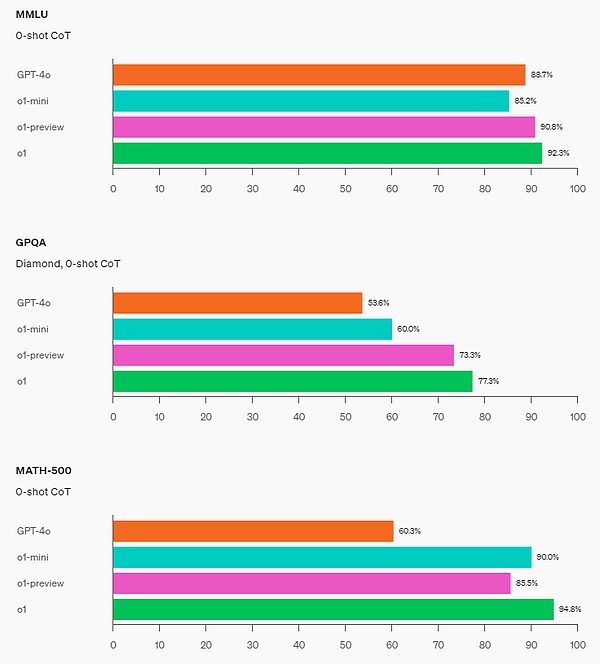

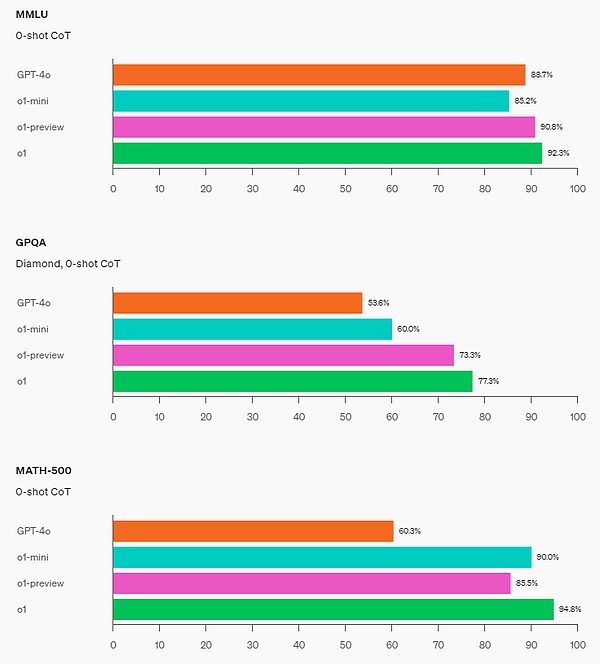

o1 cải thiện hơn GPT-4o ở nhiều điểm chuẩn, bao gồm 54/57 danh mục phụ MMLU, 7 trong số đó được hiển thị để minh họa.

Hiệu suất của O1 có thể so sánh với các chuyên gia về con người trên nhiều tiêu chuẩn chuyên sâu về suy luận. Các mô hình hàng đầu gần đây hoạt động tốt trên MATH và GSM8K đến mức các điểm chuẩn này không còn hiệu quả trong việc phân biệt các mô hình. Vì vậy, OpenAI đã đánh giá thành tích toán học trên AIME, một bài kiểm tra được thiết kế để kiểm tra những học sinh trung học giỏi toán nhất nước Mỹ.

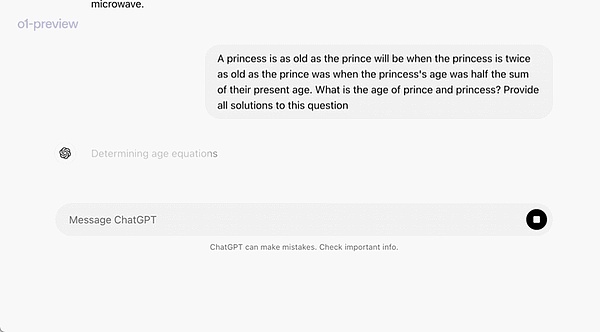

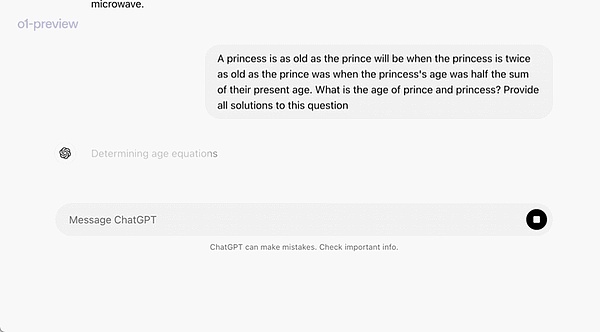

Trong bản demo chính thức, o1-preview đã giải quyết được một vấn đề lý luận rất khó: khi tuổi công chúa gấp đôi hoàng tử thì công chúa bằng tuổi hoàng tử và công chúa bằng một nửa tuổi hiện tại của họ lứa tuổi kết hợp. Tuổi của hoàng tử và công chúa là bao nhiêu? Cung cấp tất cả các giải pháp cho vấn đề này.

Trong kỳ thi AIME 2024, GPT-4o chỉ giải trung bình 12% (1,8/15) câu hỏi, trong khi o1 đạt trung bình 74 với chỉ một mẫu cho mỗi câu hỏi % (11,1/15) ), 83% (12,5/15) khi đạt được sự thống nhất giữa 64 mẫu và 93% (13,9/15) khi sắp xếp lại 1000 mẫu bằng chức năng tính điểm đã học. Điểm 13,9 sẽ đưa bạn vào top 500 toàn quốc và cao hơn điểm chuẩn của Olympic Toán Hoa Kỳ.

OpenAI cũng đánh giá o1 trên điểm chuẩn GPQA Diamond, một điểm chuẩn trí thông minh khó kiểm tra kiến thức chuyên môn về hóa học, vật lý và sinh học. Để so sánh mô hình với con người, OpenAI đã thuê các chuyên gia có bằng tiến sĩ để trả lời các câu hỏi về tiêu chuẩn GPQA Diamond.

Kết quả thử nghiệm cho thấy: o1 vượt qua hiệu suất của các chuyên gia con người, trở thành mô hình đầu tiên làm được điều đó trên tiêu chuẩn này.

Những kết quả này không có nghĩa là o1 có khả năng hơn Tiến sĩ về mọi mặt - chỉ là mô hình này giải quyết tốt hơn một số vấn đề mà Tiến sĩ có thể giải quyết. Trong số một số điểm chuẩn ML khác, o1 đạt được SOTA mới.

Khi kích hoạt nhận thức trực quan, o1 đạt 78,2% điểm chuẩn MMMU, trở thành mô hình đầu tiên ngang hàng với các chuyên gia về con người. o1 cũng hoạt động tốt hơn GPT-4o ở 54 trên 57 danh mục phụ MMLU.

Chuỗi suy nghĩ (CoT)

Tương tự như cách con người suy nghĩ trong thời gian dài trước khi trả lời một câu hỏi khó, o1 sử dụng CoT khi cố gắng giải quyết một vấn đề Thông qua học tăng cường, o1 học cách trau dồi chuỗi suy nghĩ của mình và cải thiện các chiến lược mà nó sử dụng. o1 Học cách nhận biết và sửa lỗi cũng như có thể chia các bước phức tạp thành những bước đơn giản hơn. o1 cũng đã học cách thử các cách tiếp cận khác nhau khi cách tiếp cận hiện tại không hiệu quả. Quá trình này cải thiện đáng kể khả năng suy luận của mô hình.

Khả năng lập trình

Sau khi khởi tạo dựa trên o1 và đào tạo thêm các kỹ năng lập trình, chương trình đào tạo OpenAI đã tạo ra một mô hình lập trình rất mạnh mẽ (o1-ioi). Người mẫu đạt 213 điểm trong kỳ thi Olympic Tin học quốc tế (IOI) năm 2024, lọt top 49%. Và điều kiện để người mẫu tham gia cuộc thi cũng giống như thí sinh con người tại IOI 2024: cần giải 6 câu hỏi thuật toán khó trong vòng 10 giờ, và mỗi câu chỉ được gửi 50 câu trả lời.

Đối với mỗi câu hỏi, mô hình o1 được đào tạo đặc biệt sẽ lấy mẫu một số câu trả lời của ứng viên rồi gửi 50 câu trả lời trong số đó dựa trên chiến lược lựa chọn thời gian kiểm tra. Tiêu chí lựa chọn bao gồm hiệu suất trên các trường hợp kiểm thử công khai IOI, các trường hợp kiểm thử do mô hình tạo và chức năng tính điểm đã học.

Nghiên cứu cho thấy chiến lược này có hiệu quả. Vì nếu gửi đáp án trực tiếp một cách ngẫu nhiên thì điểm trung bình chỉ là 156. Điều này có nghĩa là trong các điều kiện cạnh tranh này, chiến lược này có giá trị ít nhất là 60 điểm.

OpenAI nhận thấy rằng hiệu suất của mô hình có thể được cải thiện đáng kể nếu các hạn chế gửi được nới lỏng. Nếu cho phép 10.000 lượt gửi câu trả lời cho mỗi câu hỏi, ngay cả khi không sử dụng chiến lược lựa chọn thời gian làm bài kiểm tra được mô tả ở trên thì mô hình sẽ ghi được 362,14 điểm—đủ tốt để giành huy chương vàng.

Cuối cùng, OpenAI đã mô phỏng một cuộc thi lập trình mang tính cạnh tranh do Codeforces tổ chức để thể hiện kỹ năng viết mã của mô hình. Việc đánh giá được áp dụng rất gần với các quy tắc cạnh tranh, cho phép gửi 10 mã. GPT-4o có điểm Elo là 808, nằm trong top 11% đối thủ cạnh tranh của con người. Mô hình này vượt trội đáng kể so với GPT-4o và o1 - với số điểm Elo là 1807, nó vượt trội hơn 93% so với các đối thủ cạnh tranh.

Việc tinh chỉnh hơn nữa trong các cuộc thi lập trình đã nâng cao khả năng của o1 và được xếp hạng trong top 49% theo quy định của Olympic Tin học Quốc tế (IOI) năm 2024.

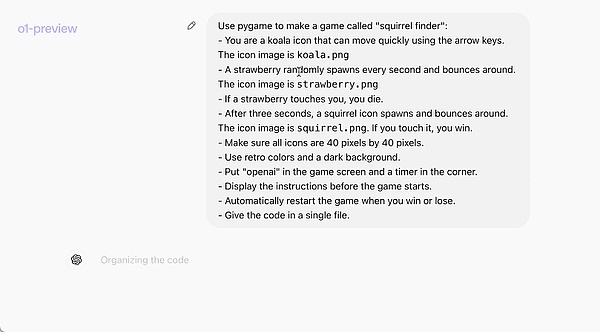

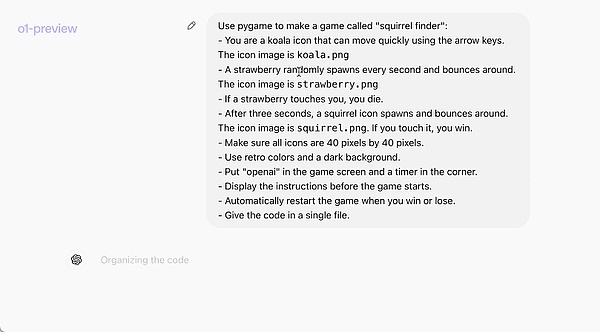

Ví dụ chính thức sau đây thể hiện một cách trực quan khả năng lập trình của o1-preview: một từ nhắc nhở cho phép nó viết một trò chơi hoàn chỉnh có thể chạy được.

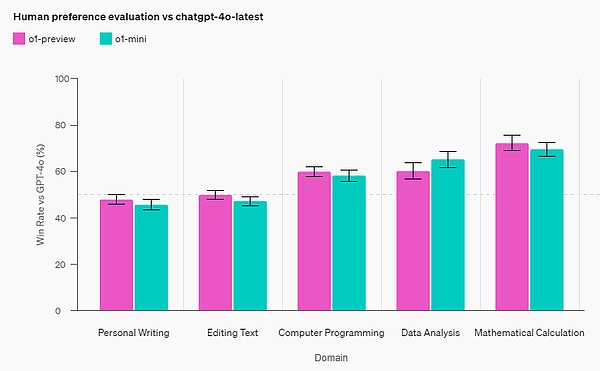

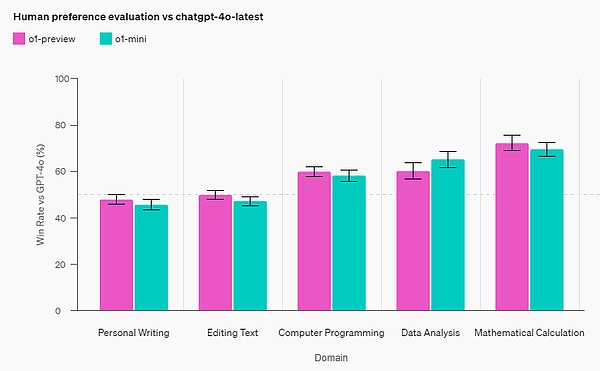

Đánh giá sở thích của con người

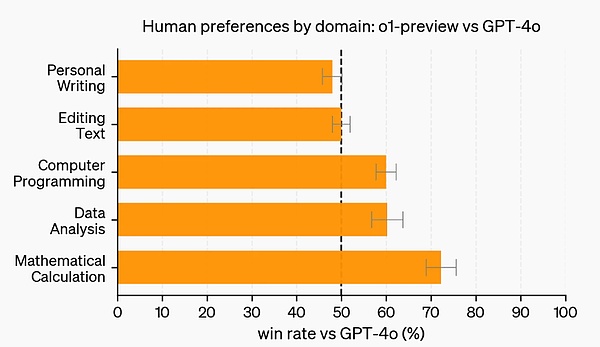

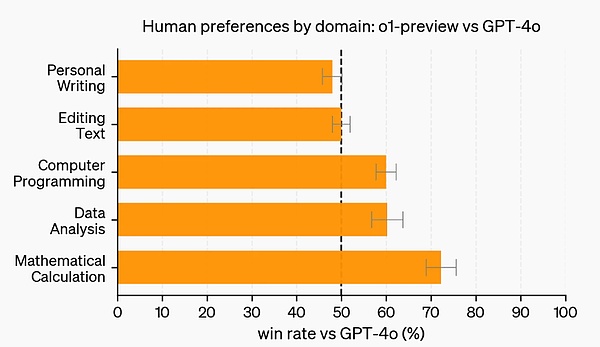

Ngoài các điểm chuẩn về kỳ thi và học thuật, OpenAI còn đánh giá sở thích của con người đối với o1-preview và GPT-4o về các lời nhắc mở đầy thử thách trong nhiều lĩnh vực hơn.

Trong đánh giá này, người huấn luyện con người đã trả lời ẩn danh các lời nhắc từ o1-preview và GPT-4o, đồng thời bỏ phiếu cho câu trả lời mà họ ưa thích. Trong các danh mục có khả năng suy luận mạnh mẽ như phân tích dữ liệu, lập trình và toán học, o1-preview phổ biến hơn nhiều so với GPT-4o. Tuy nhiên, o1-preview không phổ biến đối với một số tác vụ ngôn ngữ tự nhiên nhất định, cho thấy rằng nó không phù hợp với mọi trường hợp sử dụng.

Trong các lĩnh vực yêu cầu khả năng suy luận mạnh mẽ hơn, mọi người thích o1-preview hơn.

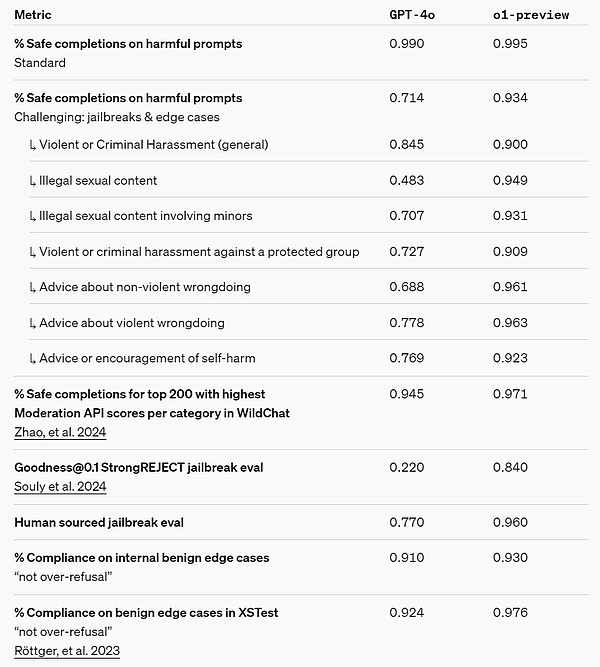

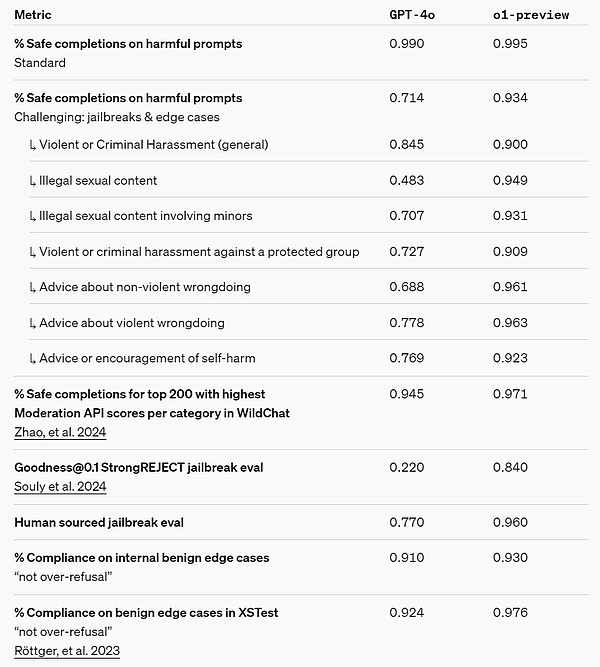

Bảo mật

Lý luận về Chuỗi tư duy (CoT) cung cấp những ý tưởng mới về bảo mật và liên kết. OpenAI nhận thấy rằng việc tích hợp các chiến lược hành vi của mô hình vào chuỗi tư duy của các mô hình lý luận có thể dạy các giá trị và nguyên tắc của con người một cách hiệu quả và mạnh mẽ. Bằng cách dạy các mô hình các quy tắc bảo mật của riêng nó và cách suy luận về chúng trong ngữ cảnh, OpenAI đã tìm thấy bằng chứng cho thấy khả năng suy luận trực tiếp mang lại lợi ích cho sự mạnh mẽ của mô hình: o1-preview về các đánh giá bẻ khóa quan trọng và các tiêu chuẩn nội bộ nghiêm ngặt nhất được sử dụng để đánh giá các giới hạn từ chối bảo mật mô hình. đạt được.

OpenAI tin rằng việc sử dụng chuỗi suy nghĩ có thể mang lại những cải tiến đáng kể về an toàn và liên kết vì 1) nó mang lại một cách rõ ràng để quan sát tư duy mô hình và 2) lập luận theo mô hình về các quy tắc an toàn đáng tin cậy hơn đối với những người không có khả năng kịch bản phân phối mạnh mẽ.

Để kiểm tra hiệu quả các cải tiến của mình, OpenAI đã tiến hành một loạt thử nghiệm bảo mật và thử nghiệm đội đỏ dựa trên khung sẵn sàng bảo mật trước khi triển khai. Người ta nhận thấy rằng lý luận chuỗi suy nghĩ đã giúp cải thiện khả năng trong suốt quá trình đánh giá. Đặc biệt lưu ý, OpenAI đã quan sát thấy các trường hợp hack phần thưởng thú vị.

Link khung chuẩn bị an toàn: https://openai.com/safety/

Chuỗi tư duy ẩn

OpenAI tin rằng chuỗi suy nghĩ ẩn mang lại cơ hội đặc biệt cho các mô hình giám sát. Giả sử nó trung thực và rõ ràng, các chuỗi suy nghĩ ẩn giúp có thể “đọc” được suy nghĩ của người mẫu và hiểu được quá trình suy nghĩ của nó. Ví dụ: trong tương lai người ta có thể muốn theo dõi chuỗi suy nghĩ để tìm dấu hiệu thao túng người dùng.

Nhưng để làm được điều này, mô hình phải có khả năng tự do thể hiện suy nghĩ của mình ở dạng không thay đổi và do đó không thể được đào tạo về chuỗi suy nghĩ để đào tạo về tuân thủ chính sách hoặc sở thích của người dùng. OpenAI cũng không muốn người dùng nhìn thấy trực tiếp chuỗi suy nghĩ không nhất quán.

Do đó, sau khi cân nhắc nhiều yếu tố như trải nghiệm người dùng, lợi thế cạnh tranh và các lựa chọn để theo đuổi việc giám sát chuỗi suy nghĩ, OpenAI đã quyết định không hiển thị chuỗi suy nghĩ ban đầu cho người dùng. OpenAI thừa nhận nhược điểm của quyết định này và cố gắng bù đắp một phần bằng cách dạy mô hình tái tạo bất kỳ ý tưởng hữu ích nào trong chuỗi suy nghĩ trong các câu trả lời của nó. Đồng thời, đối với chuỗi mô hình o1, OpenAI hiển thị bản tóm tắt chuỗi tư duy do mô hình tạo ra.

Có thể nói, o1 đã cải thiện đáng kể tính năng suy luận AI tiên tiến nhất. OpenAI có kế hoạch phát hành các phiên bản cải tiến của mô hình này theo một quy trình lặp đi lặp lại và hy vọng những khả năng suy luận mới này sẽ cải thiện khả năng điều chỉnh mô hình phù hợp với các giá trị và nguyên tắc của con người. OpenAI tin rằng o1 và những người kế nhiệm nó sẽ mở ra những trường hợp sử dụng mới cho AI trong khoa học, lập trình, toán học và các lĩnh vực liên quan.

OpenAI o1-mini

o1 là một chuỗi các mô hình. Lần này OpenAI cũng phát hành phiên bản mini của OpenAI o1-mini. Công ty đã đưa ra các định nghĩa khác nhau về phiên bản xem trước và phiên bản mini trên blog của mình: "Để cung cấp cho các nhà phát triển các giải pháp hiệu quả hơn, chúng tôi cũng đã phát hành OpenAI o1-mini, đây là phiên bản nhanh hơn và rẻ hơn, đặc biệt tốt trong lập trình mô hình suy luận. " Nhìn chung, chi phí của o1-mini thấp hơn 80% so với o1-preview.

Vì các mô hình ngôn ngữ lớn như o1 được đào tạo trước trên các tập dữ liệu văn bản lớn nên mặc dù chúng có kiến thức sâu rộng về thế giới nhưng chúng có thể tốn kém và chậm đối với các ứng dụng thực tế.

Ngược lại, o1-mini là mô hình nhỏ hơn được tối ưu hóa cho suy luận STEM trong quá trình đào tạo trước. Sau khi được đào tạo bằng cách sử dụng cùng một quy trình học tăng cường tính toán chuyên sâu (RL) như o1, o1-mini đạt được hiệu suất tương đương trên nhiều tác vụ suy luận hữu ích đồng thời tiết kiệm chi phí hơn đáng kể.

Ví dụ: trong các điểm chuẩn yêu cầu trí thông minh và lý luận, o1-mini hoạt động tốt so với o1-preview và o1. Nhưng nó hoạt động kém trong các nhiệm vụ đòi hỏi kiến thức thực tế không phải STEM.

Khả năng toán học: Trong cuộc thi toán AIME cấp trung học, o1-mini (70.0 % ) ngang bằng với o1 (74,4%), nhưng rẻ hơn nhiều và tốt hơn so với o1-preview (44,6%). Điểm o1-mini (khoảng 11/15 câu hỏi) xấp xỉ trong số 500 học sinh trung học hàng đầu nước Mỹ.

Khả năng mã hóa: Trên trang web thi đấu Codeforces, o1-mini có điểm Elo là 1650, ngang bằng với o1 (1673) và cao hơn o1-preview (1258). Ngoài ra, o1-mini còn hoạt động tốt trong tiêu chuẩn mã hóa HumanEval và thử thách bắt cờ (CTF) an ninh mạng dành cho trường trung học.

STEM: Về một số điểm chuẩn học thuật yêu cầu suy luận, chẳng hạn như GPQA (Khoa học) và MATH-500, o1-mini hoạt động tốt hơn GPT-4o. o1-mini hoạt động kém hơn GPT-4o trong các nhiệm vụ như MMLU và tụt hậu so với o1-preview trên điểm chuẩn GPQA do thiếu kiến thức sâu rộng về thế giới.

Đánh giá sở thích của con người: OpenAI khiến người đánh giá con người gặp thách thức trong nhiều lĩnh vực khác nhau So sánh o1-mini và GPT-4o trên lời nhắc mở. Tương tự như o1-preview, o1-mini phổ biến hơn GPT-4o trong các miền suy luận chuyên sâu; nhưng trong các miền tập trung vào ngôn ngữ, o1-mini không phổ biến hơn GPT-4o.

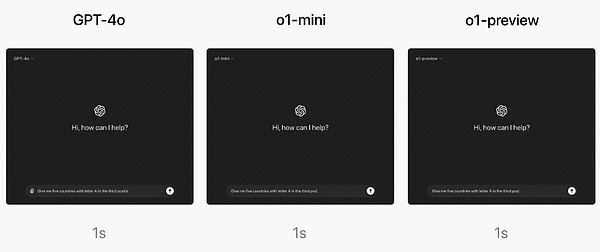

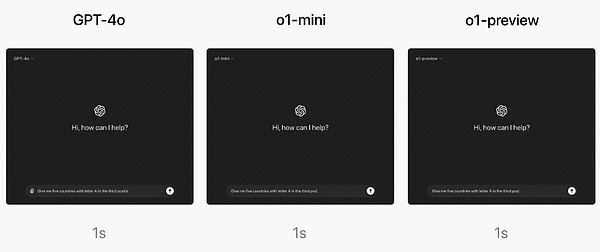

Về tốc độ, OpenAI so sánh GPT-4o, o1-mini và o1 -xem trước câu trả lời cho câu hỏi lý luận từ. Kết quả cho thấy GPT-4o trả lời sai, trong khi cả o1-mini và o1-preview đều trả lời đúng, trong đó o1-mini đưa ra câu trả lời nhanh hơn khoảng 3-5 lần.

Làm cách nào để sử dụng OpenAI o1?

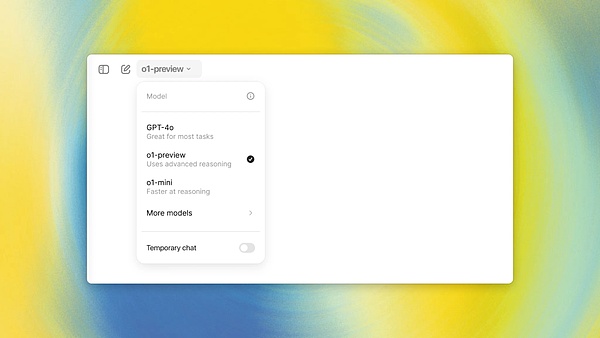

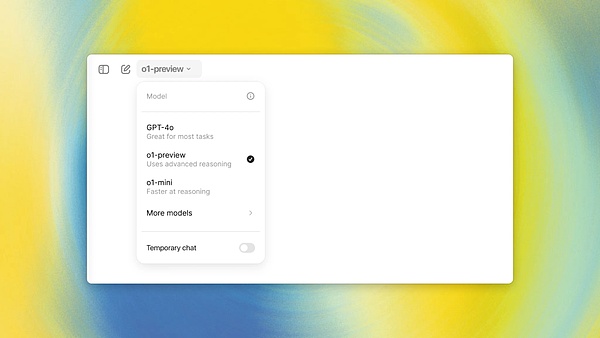

Người dùng ChatGPT Plus và Team (phiên bản cá nhân và nhóm) có thể bắt đầu sử dụng mô hình o1 trong sản phẩm chatbot ChatGPT của công ty ngay lập tức. Bạn có thể chọn sử dụng o1-preview hoặc o1-mini theo cách thủ công. Tuy nhiên, việc sử dụng của người dùng bị hạn chế.

Hiện tại, mỗi người dùng chỉ có thể gửi 30 tin nhắn đến o1-preview và 50 tin nhắn đến o1-mini mỗi tuần.

Có, rất ít! Tuy nhiên, OpenAI cho biết họ đang nỗ lực để tăng số lần người dùng có thể sử dụng nó và cho phép ChatGPT tự động chọn và sử dụng mô hình phù hợp cho một từ nhắc nhất định.

Đối với người dùng Enterprise và Education Edition, họ sẽ không thể bắt đầu sử dụng phần mềm này cho đến tuần tới. Hai mô hình.

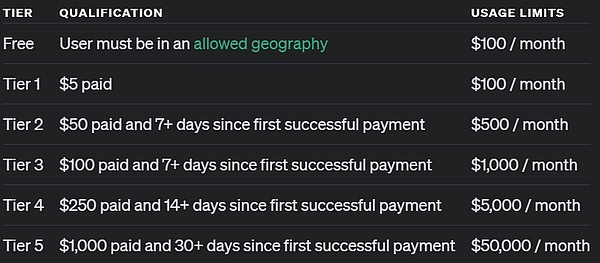

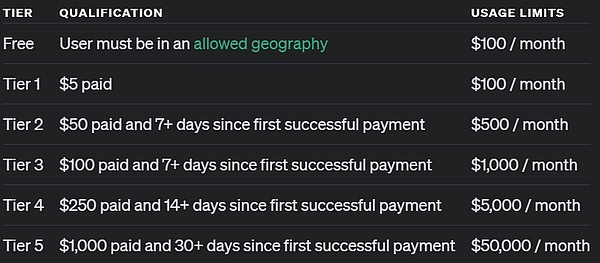

Đối với người dùng truy cập thông qua API, OpenAI tuyên bố rằng các nhà phát triển đã đạt mức sử dụng API cấp 5 có thể ngay lập tức bắt đầu sử dụng hai mô hình này để bắt đầu phát triển nguyên mẫu ứng dụng, nhưng tốc độ cũng bị giới hạn: 20 RPM. Việc sử dụng API cấp 5 là gì? Nói một cách đơn giản, điều đó có nghĩa là bạn đã chi hơn 1.000 USD và là người dùng trả phí được hơn 1 tháng. Vui lòng xem hình bên dưới:

OpenAI chỉ ra rằng API gọi tới hai mô hình không. Nó không bao gồm các cuộc gọi chức năng, phát trực tuyến, tin nhắn hỗ trợ hệ thống, v.v. Tương tự như vậy, OpenAI cho biết họ đang nỗ lực cải thiện những giới hạn này.

Tương lai

OpenAI tuyên bố rằng trong tương lai, ngoài các bản cập nhật mô hình, nó cũng sẽ bổ sung các chức năng như duyệt mạng, tải lên tệp và hình ảnh, v.v. để làm cho những mô hình này trở nên hữu ích hơn.

"Ngoài các mẫu dòng o1 mới, chúng tôi dự định tiếp tục phát triển và tung ra các mẫu dòng GPT của mình."

Nội dung tham khảo:

https://openai.com/index/introducing-openai-o1-preview/

https://openai.com/index/openai-o1-mini-advancing-cost-factor-reasoning/

https: //openai.com/index/learning-to-reason-with-llms/

https://x .com/ sama/status/1834283100639297910

JinseFinance

JinseFinance