المؤلف: تنغ يان، سلسلة الفكر الترجمة: Golden Finance xiaozou

يؤسفني ذلك بشدة لا يزال يزعجني أنها كانت بلا شك الفرصة الاستثمارية الأكثر وضوحًا لأي شخص مهتم، لكنني لم أستثمر فيها فلسًا واحدًا. لا، أنا لا أتحدث عن قاتل سولانا التالي أو عملة ميمي كلب يرتدي قبعة مضحكة.

لكن... NVIDIA.

p>

p>

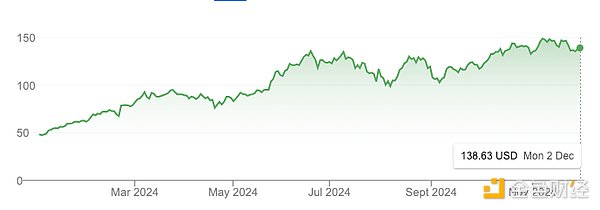

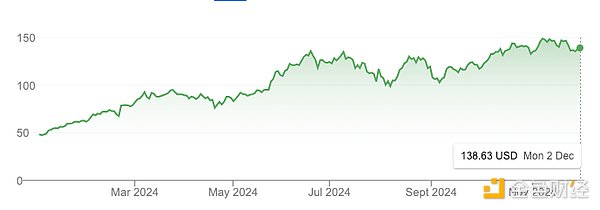

في عام واحد فقط، ارتفعت القيمة السوقية لـ NVDA من 1 تريليون دولار أمريكي إلى 3 تريليون دولار أمريكي، أي بزيادة قدرها 3 مرات، حتى أنها تجاوزت عملة البيتكوين خلال نفس الفترة.

بالطبع هناك ضجيج حول الذكاء الاصطناعي، لكن جزءًا كبيرًا منه يعتمد على الواقع. أعلنت NVIDIA أن إيراداتها للعام المالي 2024 بلغت 60 مليار دولار أمريكي، بزيادة قدرها 126% عن العام المالي 2023، وهو أداء مذهل.

إذن لماذا فاتني ذلك؟

في العامين الماضيين كنت أركز على مجال التشفير ولم أنظر إلى العالم الخارجي أو أهتم بمجال الذكاء الاصطناعي. لقد ارتكبت خطأً فادحًا لا يزال يطاردني حتى اليوم.

لكنني لن أرتكب نفس الخطأ مرة أخرى.

اليوم، يبدو Crypto AI مشابهًا جدًا. نحن على وشك انفجار الابتكار. وهذا يشبه إلى حد كبير حمى البحث عن الذهب في كاليفورنيا في منتصف القرن التاسع عشر، حيث نشأت الصناعات والمدن بين عشية وضحاها، وتطورت البنية التحتية بسرعة مذهلة، وتم تكوين الثروة على يد أولئك الذين تجرأوا على التفكير والتصرف.

مثل NVIDIA في أيامها الأولى، ستكون Crypto AI فرصة واضحة بعد فوات الأوان.

في الجزء الأول من هذه المقالة، سأوضح سبب كون Crypto AI هو الفرصة الأكثر إثارة للمستثمرين والبناة اليوم.

نظرة عامة مختصرة هي كما يلي:

لا يزال الكثير من الناس يعتقدون أن هذا خيال.

لا يزال الذكاء الاصطناعي المشفر في مراحله الأولى وربما لا يزال على بعد سنة أو سنتين من ذروة الضجيج.

يحتوي هذا المجال على ما لا يقل عن 230 مليار دولار أمريكي من فرص النمو.

في الأساس، Crypto AI هو ذكاء اصطناعي يعتمد على البنية التحتية للتشفير. وهذا يعني أنه من المرجح أن تتبع مسار النمو الأسي للذكاء الاصطناعي بدلاً من سوق العملات المشفرة الأوسع. لذا، حتى لا تتخلف عن الركب، من الضروري متابعة أحدث أبحاث الذكاء الاصطناعي على Arxiv والتحدث مع المؤسسين الذين يعتقدون أنهم يقومون بإنشاء المنتجات والخدمات الرائعة القادمة.

في الجزء الثاني من هذه المقالة، سوف أتعمق في الحقول الفرعية الأربعة الواعدة في Crypto AI:

الحوسبة اللامركزية: التدريب والاستدلال وسوق GPU

شبكة البيانات

ذكاء اصطناعي يمكن التحقق منه

عامل ذكاء اصطناعي يعمل على السلسلة

< p style="text-align: left;">لكتابة هذا المقال، أمضيت عدة أسابيع في إجراء بحث متعمق والتحدث مع المؤسسين والفرق في مجال Crypto AI، وهذه المقالة هي تتويج لتلك الجهود. لا تتناول هذه المقالة كل المجالات بشكل شامل، وبدلاً من ذلك، يمكنك اعتبارها بمثابة خريطة طريق عالية المستوى مصممة لتحفيز فضولك، وتحسين مستوى بحثك، وتوجيه تفكيرك الاستثماري.

p>

p>

1. مشهد الذكاء الاصطناعي المشفر

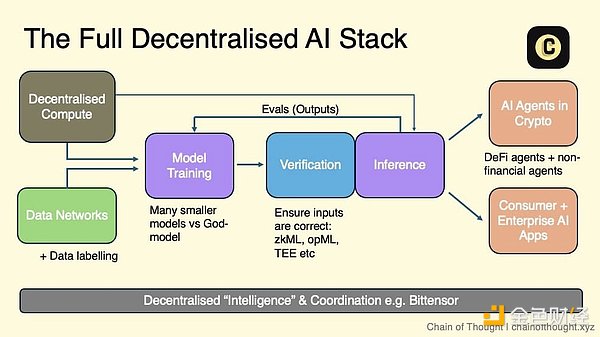

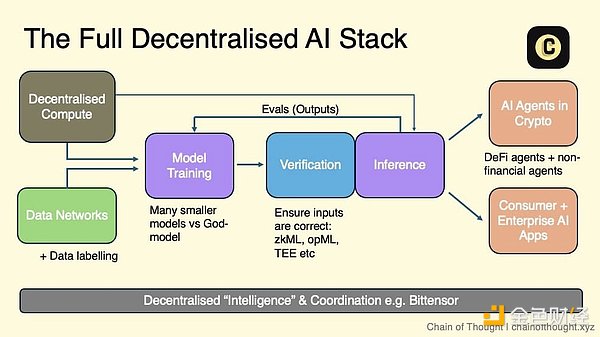

أصف مجموعة الذكاء الاصطناعي اللامركزي كنظام بيئي متعدد الطبقات: أحد طرفي يبدأ بالحوسبة اللامركزية وشبكات البيانات المفتوحة، مما يوفر الدعم للتدريب اللامركزي على نماذج الذكاء الاصطناعي.

يتم بعد ذلك استخدام مجموعة من التشفير والحوافز الاقتصادية المشفرة وشبكات التقييم للتحقق من كل استنتاج - سواء المدخلات أو المخرجات. تتدفق هذه المخرجات التي تم التحقق منها إلى وكلاء الذكاء الاصطناعي الذين يمكنهم العمل بشكل مستقل على السلسلة، بالإضافة إلى تطبيقات الذكاء الاصطناعي للمستهلكين والمؤسسات التي يمكن للمستخدمين الوثوق بها حقًا.

تربط شبكة التنسيق كل شيء معًا، مما يتيح التواصل والتعاون السلس عبر النظام البيئي بأكمله.

في هذه الرؤية، يمكن لأي شخص يقوم ببناء ذكاء اصطناعي الاستفادة من طبقة واحدة أو أكثر من هذه المجموعة وفقًا لاحتياجاته الخاصة. سواء كنت تستفيد من الحوسبة اللامركزية للتدريب النموذجي أو تستخدم شبكة تقييم لضمان مخرجات عالية الجودة، فإن الحزمة توفر مجموعة من الخيارات.

نظرًا لقابلية التركيب المتأصلة في blockchain، أعتقد أننا سنتحرك بشكل طبيعي نحو مستقبل معياري. أصبحت كل طبقة متخصصة للغاية، مع بروتوكولات محسنة لوظائف مختلفة بدلاً من اتباع نهج التكامل الشامل.

p>

p>

هناك عدد كبير من الشركات الناشئة في كل طبقة من طبقات الذكاء الاصطناعي اللامركزي، وقد تم تأسيس معظمها في السنوات 1-3 الماضية. ومن الواضح أن هذا المجال لا يزال في مراحله الأولى.

تتم صيانة خريطة بدء تشغيل Crypto AI الأكثر شمولاً وحداثة التي رأيتها على الإطلاق بواسطة Casey وفريقها في topology.vc. هذا مورد لا يقدر بثمن لأي شخص يتتبع هذا المجال.

بينما أتعمق في المجال الفرعي لـ Crypto AI، أظل أسأل نفسي: ما هي الفرص؟ أنا لست مهتمًا بالأشياء الصغيرة، بل أبحث عن أسواق يبلغ حجمها مئات المليارات من الدولارات.

(1) حجم السوق

لنفعل ذلك أولاً انظر إلى حجم السوق. عند تقييم أحد المجالات المتخصصة، أسأل نفسي:هل يؤدي ذلك إلى إنشاء سوق جديدة تمامًا أم تغيير السوق الحالية؟

خذ الحوسبة اللامركزية كمثال. وهذه فئة ثورية يمكن تقييم إمكاناتها من خلال النظر إلى سوق الحوسبة السحابية الحالي، والذي تقدر قيمته حاليًا بحوالي 680 مليار دولار، ومن المتوقع أن تصل إلى 2.5 تريليون دولار بحلول عام 2032.

من الصعب قياس الأسواق الجديدة غير المسبوقة، مثل عملاء الذكاء الاصطناعي. وبدون بيانات تاريخية، فإن تقييمهم يتطلب التخمين وتقييم المشكلة التي يقومون بحلها. من المهم أن نلاحظ أنه في بعض الأحيان، ما يبدو وكأنه سوق جديد هو في الواقع مجرد جهد لإيجاد حل لمشكلة ما.

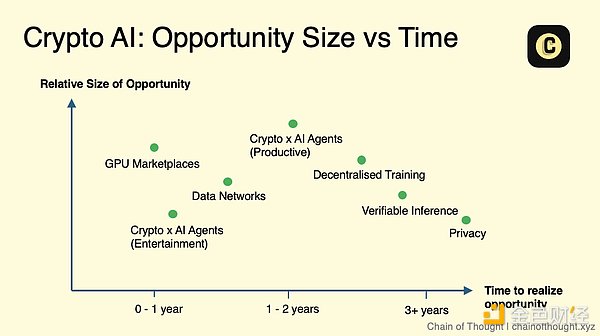

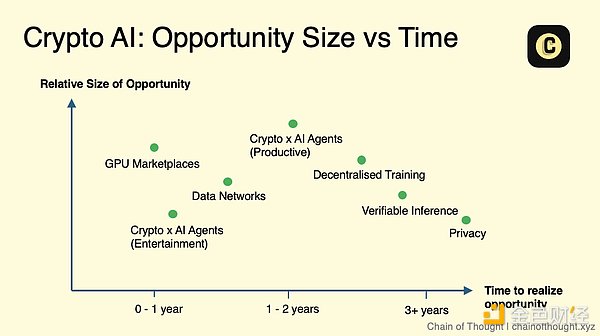

(2) التوقيت

التوقيت هو كل شيء. تميل التكنولوجيا إلى التحسن وتصبح أقل تكلفة بمرور الوقتلكن وتيرة التطور تختلف.

ما مدى نضج التكنولوجيا في قطاع معين؟ فهل هو جاهز للتبني على نطاق واسع، أم أنه لا يزال في مرحلة البحث، ولا يزال أمامنا عدة سنوات لتطبيقاته العملية؟ يحدد التوقيت ما إذا كانت الصناعة تستحق الاهتمام الفوري أو "الانتظار والترقب".

لنأخذ التشفير المتماثل بالكامل (FHE) كمثال: إمكاناته لا يمكن إنكارها، ولكن تطويره حاليًا لا يزال بطيئًا جدًا بحيث لا يمكن استخدامه على نطاق واسع. قد يستغرق الأمر بضع سنوات قبل أن نرى التبني السائد. من خلال التركيز على المجالات الأقرب إلى النطاق أولاً، يمكنني قضاء وقتي وطاقتي في المجالات التي تبني الزخم والفرص.

p>

p>

إذا أردت تعيين هذه الفئات على مقياس الرسم البياني مقابل الرسم البياني الزمني، فسيبدو الأمر هكذا. ضع في اعتبارك أن هذه خريطة مفاهيمية وليست دليلًا صعبًا. هناك العديد من الفروق الدقيقة - على سبيل المثال، في الاستدلال الذي يمكن التحقق منه، تتمتع الأساليب المختلفة مثل zkML وopML بمستويات مختلفة من الاستعداد للاستخدام.

ومع ذلك، أعتقد أن حجم الذكاء الاصطناعي سيكون كبيرًا جدًا لدرجة أنه حتى المجال الذي يبدو "متخصصًا" اليوم قد يتطور إلى سوق مهم .

من الجدير بالذكر أيضًا أن التقدم التكنولوجي لا يتقدم دائمًا في خط مستقيم، بل غالبًا ما يأتي على شكل طفرات. عندما ينفجر فجأة، ستتغير وجهة نظري بشأن التوقيت وحجم السوق.

مع وضع هذا الإطار في الاعتبار، دعونا نلقي نظرة على كل حقل فرعي بالتفصيل.

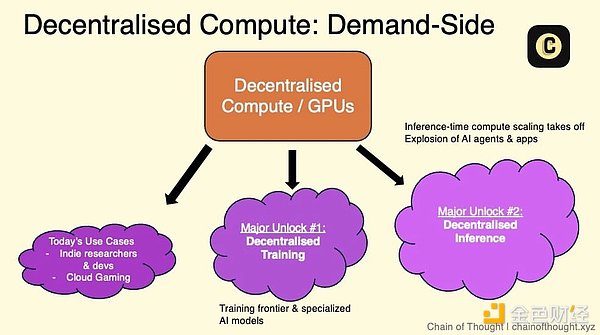

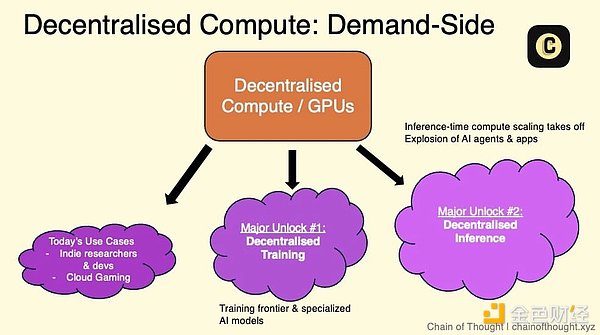

2. المنطقة 1: الحوسبة اللامركزية

< li> الحوسبة اللامركزية هي العمود الفقري للذكاء الاصطناعي اللامركزي.

يرتبط سوق GPU والتدريب اللامركزي والاستدلال اللامركزي ارتباطًا وثيقًا.

يأتي جانب العرض عادةً من مراكز البيانات الصغيرة والمتوسطة الحجم ووحدات معالجة الرسومات الاستهلاكية.

على الرغم من أن الطلب صغير، إلا أنه لا يزال ينمو. أما اليوم، فهي تأتي من مستخدمين حساسين للسعر، وغير حساسين لوقت الاستجابة، وشركات ناشئة أصغر حجمًا تعمل بالذكاء الاصطناعي.

التحدي الأكبر الذي يواجه سوق Web3 GPU حاليًا هو كيفية تشغيلها بشكل صحيح.

يتطلب تنسيق وحدات معالجة الرسومات على شبكة لا مركزية تقنيات هندسية متقدمة وبنية شبكة موثوقة ومصممة جيدًا.

2.1 GPU Market/Computing Network

هناك العديد من فرق Crypto AI التي يتم إنشاؤها استجابة لنقص GPU الذي لا يمكنها تلبية الطلب على الشبكة اللامركزية، وذلك باستخدام قوة الحوسبة المحتملة في العالم.

تتضمن القيمة الأساسية المقترحة لسوق وحدات معالجة الرسومات ثلاثة جوانب:

يمكنك الوصول إلى الحوسبة بأسعار "أقل بنسبة 90%" من AWS لأنه لا يوجد وسطاء وجانب العرض مفتوح. في الأساس، تتيح لك هذه الأسواق الاستفادة من أقل تكاليف الحوسبة الهامشية في العالم.

مرونة أكبر: لا عقود مقفلة، ولا عملية KYC، ولا وقت انتظار.

مقاومة الرقابة

من أجل حل مشكلة جانب العرض في السوق، تأتي القوة الحاسوبية لهذه الأسواق من:

وحدات معالجة الرسوميات على مستوى المؤسسات (مثل A100 وH100) التي يصعب العثور عليها في مراكز البيانات الصغيرة والمتوسطة الحجم، أو القائمين بتعدين Bitcoin الذين يبحثون عن التنويع. أعرف أيضًا فرقًا تعمل في مشاريع البنية التحتية الكبيرة التي تمولها الحكومة حيث تم بناء مراكز البيانات كجزء من خطط نمو التكنولوجيا. غالبًا ما يتم تحفيز موفري وحدات معالجة الرسومات هؤلاء للاحتفاظ بوحدة معالجة الرسومات الخاصة بهم على الشبكة، مما يساعدهم على تعويض التكلفة المطفأة لوحدة معالجة الرسومات.

وحدة معالجة الرسومات الاستهلاكية لملايين اللاعبين والمستخدمين المنزليين الذين يقومون بتوصيل أجهزة الكمبيوتر الخاصة بهم بالإنترنت للحصول على مكافآت الرموز المميزة .

ومن ناحية أخرى، يأتي الطلب اليوم على الحوسبة اللامركزية من:

المستخدمون الحساسون للسعر وغير الحساسين لزمن الوصول. يعطي هذا الجزء الأولوية للسعر على السرعة. فكر في الباحثين الذين يستكشفون مجالات جديدة، ومطوري الذكاء الاصطناعي المستقلين، وغيرهم من المستخدمين المهتمين بالتكلفة والذين لا يحتاجون إلى معالجة في الوقت الفعلي. نظرًا لقيود الميزانية، قد لا يكون العديد منهم راضين عن الخوادم التقليدية ذات الحجم الكبير مثل AWS أو Azure. ولأنها موزعة على نطاق واسع بين السكان، فإن التسويق المستهدف أمر بالغ الأهمية لجذب هذه المجموعة.

الشركات الصغيرة الناشئة في مجال الذكاء الاصطناعي التي تواجه التحدي المتمثل في عدم توقيع عقود طويلة الأجل مع موفري الخدمات السحابية الرئيسيين التحدي المتمثل في الحصول على موارد حوسبة مرنة وقابلة للتطوير. يعد تطوير الأعمال أمرًا بالغ الأهمية لجذب هذا القطاع حيث يبحثون بنشاط عن بدائل للقفل الفائق النطاق.

بدء تشغيل الذكاء الاصطناعي المشفر إنهم يبنون منتجات ذكاء اصطناعي لامركزية ولكن ليس لديهم خوارزميات خاصة بهم. الحاجة إلى الاستفادة من موارد إحدى الشبكات.

الألعاب السحابية:على الرغم من أن الألعاب السحابية لا تعتمد بشكل مباشر على الذكاء الاصطناعي، إلا أنها تتطلب موارد وحدة معالجة الرسومات (GPU). أكبر.

الشيء الأساسي الذي يجب تذكره هو: يعطي المطورون دائمًا الأولوية للتكلفة والموثوقية .

التحدي الحقيقي هو الطلب وليس العرض.

غالبًا ما تشير الشركات الناشئة في هذا المجال إلى حجم شبكات توريد وحدات معالجة الرسومات الخاصة بها كعلامة على النجاح. لكن هذا أمر مضلل، فهو في أفضل الأحوال مقياس للغرور.

إن القيد الحقيقي ليس العرض، بل الطلب. المقاييس الرئيسية التي يجب تتبعها ليست عدد وحدات معالجة الرسومات المتاحة، ولكن الاستخدام وعدد وحدات معالجة الرسومات المستأجرة بالفعل.

يقوم الرمز المميز بعمل ممتاز في تمهيد العرض، مما يخلق الحوافز اللازمة للتوسع بسرعة. ومع ذلك، فهي لا تحل مشكلة الطلب بشكل أساسي. الاختبار الحقيقي هو جعل المنتج في حالة جيدة بما يكفي لتحقيق الطلب الكامن.

قالها حسيب قريشي (اليعسوب) جيدًا:

جعل شبكات الحوسبة تعمل فعليًا

خلافًا للاعتقاد السائد، فإن أكبر عقبة تواجه حاليًا سوق وحدات معالجة الرسومات الموزعة على web3 هي جعلها تعمل بشكل صحيح.

هذا ليس سؤالًا تافهًا.

يعد تنسيق وحدات معالجة الرسومات في شبكة موزعة أمرًا معقدًا للغاية، مع وجود العديد من التحديات - تخصيص الموارد، وتوسيع نطاق عبء العمل الديناميكي، وموازنة تحميل العقدة، وزمن الوصول الإدارة ونقل البيانات والتسامح مع الأخطاء ومعالجة الأجهزة المختلفة الموزعة في مواقع جغرافية مختلفة بين وحدات معالجة الرسومات. يمكنني الاستمرار.

يتطلب تحقيق ذلك هندسة مدروسة وبنية شبكة موثوقة ومصممة بشكل جيد.

لكي تفهم بشكل أفضل، فكر في Kubernetes من Google. ويعتبر على نطاق واسع المعيار الذهبي لتنسيق الحاويات، وأتمتة العمليات مثل موازنة التحميل والقياس في البيئات الموزعة، والتي تشبه إلى حد كبير التحديات التي تواجهها شبكات GPU الموزعة. تم بناء Kubernetes نفسها على أكثر من عقد من خبرة Google، وحتى ذلك الحين، استغرق الأمر سنوات من التكرار المستمر لتحقيق الأداء الجيد.

يمكن لبعض أسواق حوسبة وحدة معالجة الرسومات عبر الإنترنت حاليًا التعامل مع أعباء عمل صغيرة الحجم، ولكن بمجرد محاولتها التوسع، تظهر المشكلات. أظن أن السبب في ذلك هو أن أسسهم المعمارية سيئة التصميم.

هناك تحدٍ/فرصة أخرى لشبكات الحوسبة اللامركزية وهو ضمان الجدارة بالثقة: التحقق من أن كل عقدة توفر بالفعل قوة الحوسبة المطالب بها. يعتمد هذا حاليًا على سمعة الشبكة، وفي بعض الحالات يتم تصنيف موفري طاقة التجزئة بناءً على درجات السمعة. يبدو أن Blockchain مناسب تمامًا لنظام التحقق غير الموثوق به. تسعى الشركات الناشئة مثل Gensyn وSpheron إلى حل هذه المشكلة باستخدام نهج غير موثوق به.

لا تزال العديد من فرق web3 تتصارع مع هذه التحديات اليوم، مما يعني أن باب الفرص مفتوح على مصراعيه.

حجم سوق الحوسبة اللامركزية

اللامركزية ما حجم سوق الحوسبة اللامركزية؟ سوق شبكات الكمبيوتر؟

اليوم، قد يكون مجرد جزء صغير من صناعة الحوسبة السحابية بقيمة 680 مليار دولار إلى 2.5 تريليون دولار. ومع ذلك، على الرغم من الاحتكاك الإضافي بالنسبة للمستخدمين، سيكون هناك دائمًا طلب طالما أن التكلفة أقل من الموردين التقليديين.

أعتقد أن التكاليف ستظل منخفضة على المدى القصير إلى المتوسط بسبب الدعم الرمزي وفتح العرض للمستخدمين غير الحساسين للسعر (على سبيل المثال، إذا كنت أرغب في ذلك) إذا كان بإمكاني استئجار الكمبيوتر المحمول المخصص للألعاب لكسب أموال إضافية، سواء كانت 20 دولارًا أو 50 دولارًا في الشهر).

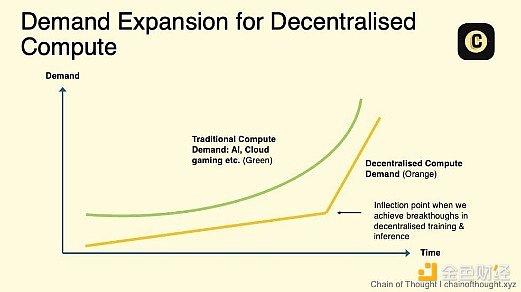

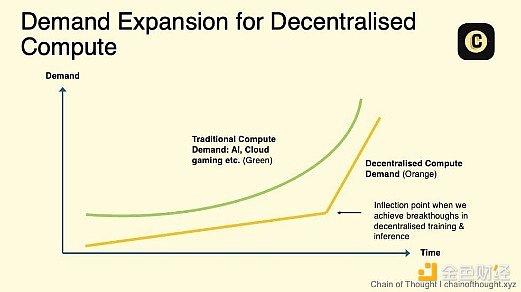

p>

p>

لكن إمكانات النمو الحقيقية لشبكات الحوسبة اللامركزية - والتوسع الحقيقي لشبكات TAM الخاصة بها - ستحدث عندما:

< li>أصبح التدريب اللامركزي لنماذج الذكاء الاصطناعي أمرًا عمليًا.

لقد ارتفع الطلب على الاستدلال، ولا تستطيع مراكز البيانات الحالية تلبية الطلب. وقد بدأ هذا يحدث بالفعل. وقال جنسن هوانغ إن الطلب على الاستدلال سيزداد "مليار مرة".

أصبحت اتفاقيات مستوى الخدمة المناسبة (SLAs) متاحة، مما يعالج عقبة تبني المؤسسات الرئيسية. حاليًا، يتيح تشغيل الحوسبة اللامركزية للمستخدمين تجربة مستويات مختلفة من جودة الخدمة (مثل نسبة وقت التشغيل). ومن خلال اتفاقيات مستوى الخدمة، يمكن لهذه الشبكات توفير موثوقية موحدة ومقاييس أداء، مما يجعل الحوسبة اللامركزية بديلاً قابلاً للتطبيق لموفري الحوسبة السحابية التقليديين.

الحوسبة اللامركزية غير المصرح بها هي الطبقة الأساسية للنظام البيئي للذكاء الاصطناعي اللامركزي - البنية التحتية.

على الرغم من توسع سلسلة توريد وحدة معالجة الرسومات، إلا أنني أعتقد أننا ما زلنا في فجر عصر الذكاء البشري. سيكون الطلب على الحوسبة لا يشبع.

من المهم ملاحظة أن نقطة الانعطاف التي قد تؤدي إلى إعادة تصنيف جميع أسواق GPU العاملة قد تأتي قريبًا.

ملاحظات أخرى:

إن سوق وحدات معالجة الرسومات (GPU) المحض مزدحم، مع منافسة شرسة بين المنصات اللامركزية وصعود الخدمات السحابية الناشئة لـ web2 AI مثل Vast.ai وLambda.

العقد الصغيرة (مثل 4 x H100) ليس عليها طلب كبير لأن استخدامها محدود، ولكن حظًا سعيدًا في العثور على شخص يبيع مجموعات كبيرة - لا يزال هناك بعض الطلب عليها

هل سيقوم لاعب مهيمن واحد بتجميع كل إمدادات طاقة التجزئة لبروتوكول لامركزي، أم أنه سيبقي قوة التجزئة منتشرة عبر أسواق متعددة؟ أفضّل الأول، حيث يؤدي الدمج عمومًا إلى زيادة كفاءة البنية التحتية. لكن هذا سيستغرق وقتًا، وفي هذه الأثناء يستمر الانقسام والارتباك

يريد المطورون التركيز على تطوير التطبيقات بدلاً من التعامل مع النشر والتكوين. يجب على الأسواق التخلص من هذه التعقيدات لجعل الوصول إلى الحوسبة سهلاً قدر الإمكان.

2.2 التدريب اللامركزي

إذا كان قانون التوسع صحيحًا، فإن تدريب الجيل القادم من نماذج الذكاء الاصطناعي المتطورة في مركز بيانات واحد سيصبح مستحيلاً يومًا ما.

يتطلب تدريب نماذج الذكاء الاصطناعي نقل كميات كبيرة من البيانات بين وحدات معالجة الرسومات. غالبًا ما تكون سرعات نقل البيانات المنخفضة (التوصيل البيني) بين وحدات معالجة الرسومات الموزعة هي أكبر عقبة.

يستكشف الباحثون طرقًا متعددة في وقت واحد ويحققون اختراقات (مثل Open DiLoCo، DisTrO). سوف تتراكم هذه التطورات وتسرع التقدم في هذا المجال

قد يكمن مستقبل التدريب اللامركزي في ذلك. صمم نماذج صغيرة متخصصة للتطبيقات المتخصصة بدلاً من النماذج المتطورة التي تركز على الذكاء الاصطناعي العام

مع الانتقال إلى OpenAI o1 ومع تغير النموذج، سيرتفع الطلب على الاستدلال، مما يخلق فرصًا لشبكات الاستدلال اللامركزية.

تخيل هذا: نموذج ذكاء اصطناعي ضخم ومغير للعالم لم يتم تطويره في مختبر سري للنخبة، بل تم تشكيله بواسطة الملايين من الناس العاديين. اللاعبون، الذين تنتج وحدات معالجة الرسوميات الخاصة بهم عادةً انفجارات شبيهة بالمسرح في لعبة Call of Duty، يقومون الآن بإعارة أجهزتهم إلى شيء أكبر بكثير - وهو نموذج ذكاء اصطناعي مفتوح المصدر ومملوك بشكل جماعي بدون حارس بوابة مركزي.

في المستقبل حيث لا تقتصر النماذج على مستوى المؤسسة على أفضل مختبرات الذكاء الاصطناعي.

ولكن دعونا نرسي هذه الرؤية على واقع اليوم. في الوقت الحاضر، لا يزال معظم تدريب الذكاء الاصطناعي الثقيل يتركز في مراكز البيانات المركزية، وقد يصبح هذا هو القاعدة لبعض الوقت.

تقوم شركات مثل OpenAI بتوسيع مجموعاتها الضخمة. أعلن Elon Musk مؤخرًا أن شركة xAI على وشك بناء مركز بيانات يعادل 200000 وحدة معالجة رسوميات H100.

لكن الأمر لا يتعلق فقط بأعداد GPU الأولية. يعد استخدام نموذج FLOPS (MFU) مقياسًا اقترحته Google في مقال بحثي لعام 2022 PaLM يتتبع مدى كفاءة استخدام السعة القصوى لوحدة معالجة الرسومات. والمثير للدهشة أن MFU عادة ما يتراوح بين 35-40٪.

لماذا هذا الانخفاض؟ وفقًا لقانون مور، ارتفع أداء وحدة معالجة الرسومات بشكل مفاجئ في السنوات القليلة الماضية، لكن التحسينات في الشبكة والذاكرة والتخزين تأخرت بشكل كبير، مما شكل عنق الزجاجة. لذلك، غالبًا ما تكون وحدة معالجة الرسومات في حالة اختناق، في انتظار البيانات.

لا يزال تدريب الذكاء الاصطناعي اليوم شديد التركيز بسبب كلمة واحدة - الكفاءة.

يعتمد تدريب النماذج الكبيرة على التقنيات التالية:

توازي البيانات: تنفيذ العمليات بالتوازي عبر مجموعات البيانات المقسمة عبر وحدات معالجة الرسومات المتعددة، مما يؤدي إلى تسريع عملية التدريب.

توازي النموذج: توزيع أجزاء من النموذج عبر وحدات معالجة الرسومات المتعددة، وتجاوز قيود الذاكرة.

تتطلب هذه الطرق من وحدة معالجة الرسومات تبادل البيانات بشكل مستمر، سرعة الاتصال البيني - البيانات الموجودة في الشبكة أصبحت سرعة النقل عبر أجهزة الكمبيوتر أمرًا بالغ الأهمية.

عندما تتجاوز تكلفة تدريب نماذج الذكاء الاصطناعي المتطورة مليار دولار، فإن كل تحسين في الكفاءة مهم.

من خلال الاتصال البيني عالي السرعة، يمكن لمراكز البيانات المركزية نقل البيانات بسرعة بين وحدات معالجة الرسومات وتوفير تكاليف كبيرة أثناء وقت التدريب. هذا إعداد لامركزي لا يضاهى.

التغلب على سرعات الاتصال البطيئة

إذا كنت تتعامل مع تحدث إلى الأشخاص الذين يعملون في مجال الذكاء الاصطناعي، وسيخبرك الكثيرون أن التدريب اللامركزي ببساطة لا يعمل.

في الإعداد اللامركزي، لا تتعايش مجموعات GPU فعليًا، لذا يكون نقل البيانات فيما بينها أبطأ بكثير ويصبح عنق الزجاجة. يتطلب التدريب أن تقوم وحدة معالجة الرسومات بمزامنة البيانات وتبادلها في كل خطوة. وكلما زاد تباعدهما، زاد زمن الوصول. الكمون العالي يعني تدريبًا أبطأ وتكلفة أعلى.

قد يستغرق الأمر عدة أيام في مركز بيانات مركزي، وقد يمتد إلى أسبوعين في مركز بيانات لامركزي، كما أن التكلفة أعلى أيضًا. وهذا ببساطة غير ممكن.

لكن هذا على وشك التغيير.

الخبر السار هو أن هناك زيادة في الاهتمام البحثي بالتدريب الموزع. يستكشف الباحثون طرقًا متعددة في وقت واحد، كما يتضح من العديد من الدراسات والأبحاث المنشورة. سوف تتراكم هذه التطورات وتندمج لتسريع التقدم في هذا المجال.

يتعلق الأمر أيضًا بالاختبار في الإنتاج لمعرفة إلى أي مدى يمكننا تجاوز الحدود.

يمكن لبعض تقنيات التدريب اللامركزية التعامل بالفعل مع نماذج أصغر في بيئات مترابطة بطيئة. والآن، تقود الأبحاث المتطورة إلى تطبيق هذه الأساليب على النماذج الكبيرة.

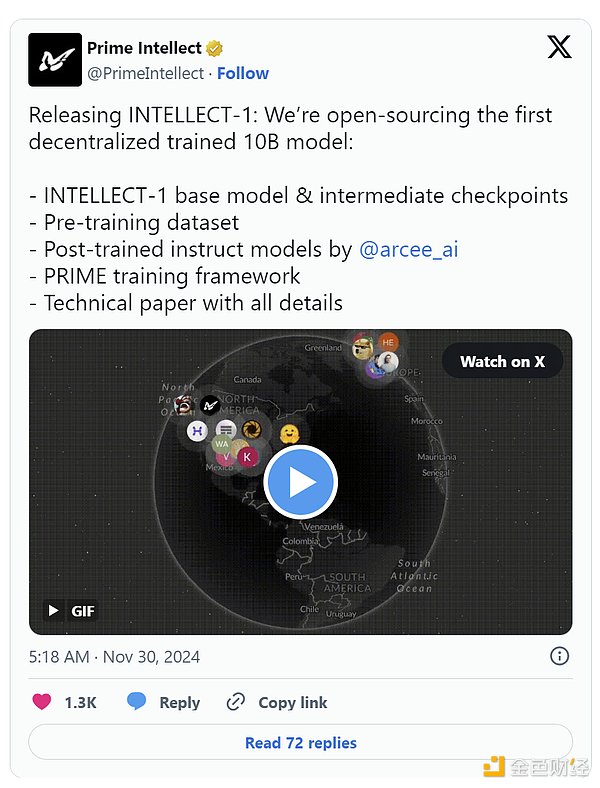

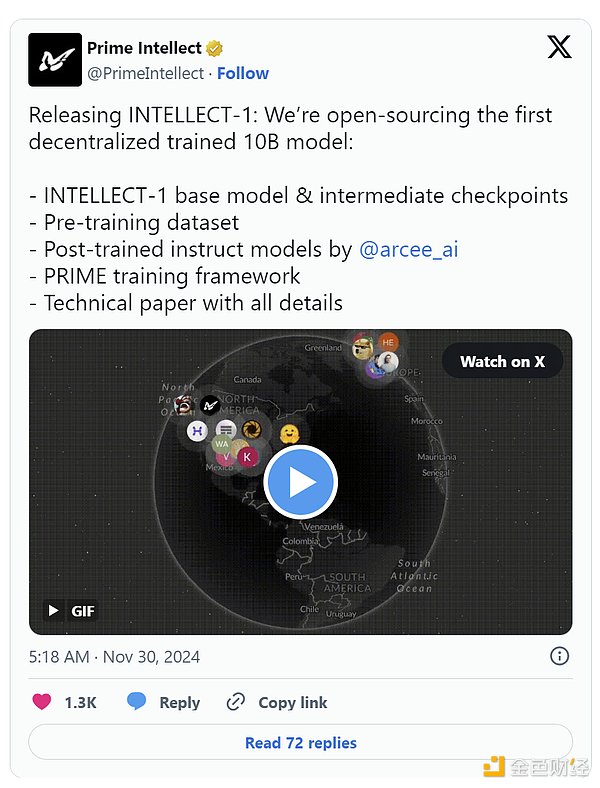

على سبيل المثال، تعرض مقالة DiCoLo مفتوحة المصدر الخاصة بـ Prime Intellect منهجًا عمليًا يشتمل على "جزر" وحدة معالجة الرسومات قبل المزامنة وتنفيذ 500 خطوة محلية يقطع متطلبات عرض النطاق الترددي 500 مرة. إن ما بدأ كأبحاث Google DeepMind على النماذج الصغيرة توسع ليشمل تدريب نموذج مكون من 10 مليارات معلمة في نوفمبر، وهو الآن مفتوح المصدر بالكامل.

ص>

ص>

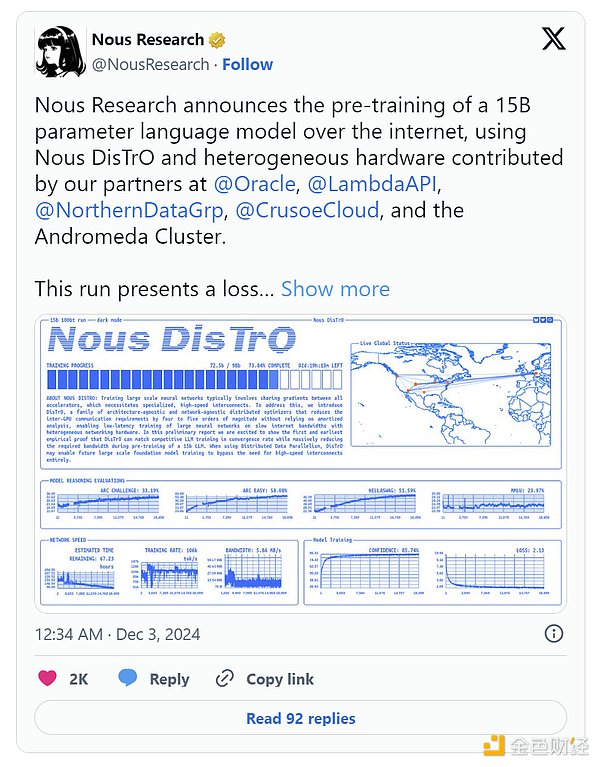

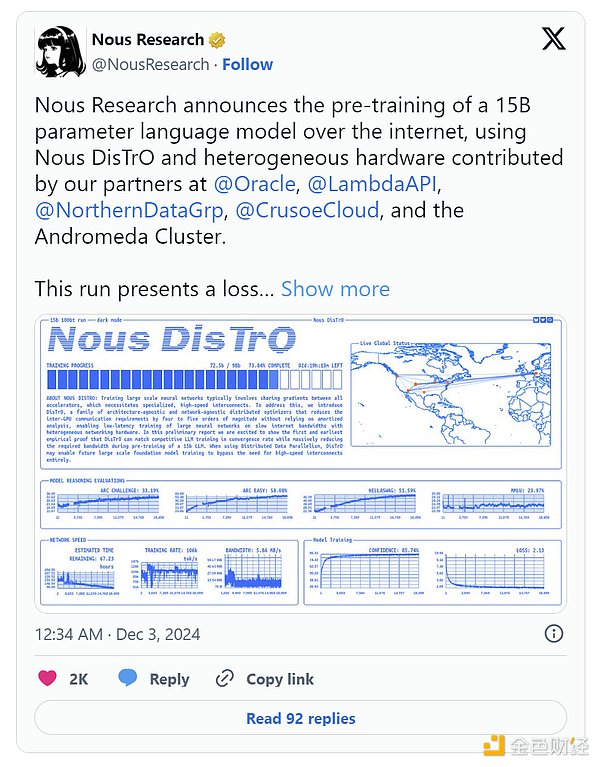

تقوم شركة Nous Research برفع المستوى من خلال إطار عمل DisTrO الخاص بها، والذي يستخدم مُحسِّنًا لتدريب نموذج معلمة 1.2B مع وضع متطلبات اتصال GPU يتم تخفيضها بنسبة مذهلة 10،000 مرة.

ولا يزال هذا الزخم ينمو. في ديسمبر، أعلن Nous عن تدريب مسبق لنموذج معلمة 15B مع منحنيات الخسارة (كيف يتناقص خطأ النموذج بمرور الوقت) ومعدلات التقارب (مدى سرعة استقرار أداء النموذج) التي تتطابق حتى مع النتائج النموذجية للتدريب المركزي بشكل أفضل. نعم أفضل من المركزية.

تمثل إدارة مجموعة واسعة من أجهزة وحدة معالجة الرسومات تحديًا آخر، بما في ذلك قيود الذاكرة النموذجية لوحدة معالجة الرسومات على مستوى المستهلك في الشبكات اللامركزية. يمكن أن تساعد تقنيات مثل توازي النماذج (تقسيم طبقات النموذج عبر الأجهزة) في هذا الأمر.

مستقبل التدريب اللامركزي

اللامركزية حاليًا النموذج لا يزال حجم أساليب التدريب المركزية أقل بكثير من النماذج الرائدة (يقال إن GPT-4 يحتوي على ما يقرب من تريليون معلمة، وهو أكبر 100 مرة من نموذج Prime Intellect 10B). لتحقيق نطاق حقيقي، نحتاج إلى تحقيق اختراقات في بنية النماذج، وبنية تحتية أفضل للشبكة، وتوزيع أكثر ذكاءً للمهام عبر الأجهزة.

يمكننا أن نحلم بشكل كبير. تخيل عالمًا يجمع فيه التدريب اللامركزي قوة حوسبة GPU أكبر مما تستطيع حتى أكبر مراكز البيانات المركزية حشده.

يعتقد فريق Pluralis Research (فريق النخبة المتخصص في التدريب اللامركزي الذي يستحق الاهتمام به) أن هذا ليس ممكنًا فحسب، بل لا مفر منه. في حين أن مراكز البيانات المركزية مقيدة بالقيود المادية مثل توفر المساحة والطاقة، فإن الشبكات اللامركزية يمكنها الاستفادة من مجموعة غير محدودة حقًا من الموارد العالمية.

حتى Jensen Huang من NVIDIA يعترف بأن التدريب اللامركزي غير المتزامن يمكن أن يفتح الإمكانات الحقيقية لتوسيع نطاق الذكاء الاصطناعي. كما أن شبكات التدريب الموزعة أكثر قدرة على تحمل الأخطاء.

لذلك، في عالم مستقبلي محتمل،سيتم تدريب أقوى نماذج الذكاء الاصطناعي في العالم بطريقة لا مركزية.

هذا احتمال مثير، لكنني لست مقتنعًا تمامًا بعد. ونحن في احتياج إلى أدلة أقوى تثبت أن التدريب اللامركزي لأكبر النماذج أمر ممكن من الناحيتين الفنية والاقتصادية.

أرى وعدًا كبيرًا في هذا: أفضل شيء في التدريب اللامركزي قد يكون نماذج صغيرة مفتوحة المصدر مصممة خصيصًا لهذا الغرض ومصممة لحالات الاستخدام المستهدفة< < /strong>بدلاً من التنافس مع النماذج الرائدة كبيرة الحجم التي تعمل بالذكاء الاصطناعي العام. أثبتت بعض البنيات، وخاصة النماذج غير المحولة، أنها مناسبة تمامًا للإعدادات اللامركزية.

هناك قطعة أخرى للغز: الرموز المميزة. وبمجرد أن يصبح التدريب اللامركزي ممكنًا على نطاق واسع، يمكن أن تلعب الرموز المميزة دورًا رئيسيًا في تحفيز المساهمين ومكافأتهم، مما يؤدي إلى تشغيل هذه الشبكات بشكل فعال.

لا يزال الطريق إلى تحقيق هذه الرؤية طويلاً، ولكن التقدم مشجع. وبما أن النماذج المستقبلية ستتجاوز قدرة مركز بيانات واحد، فإن التقدم في التدريب اللامركزي سيفيد الجميع، حتى شركات التكنولوجيا الكبرى ومختبرات أبحاث الذكاء الاصطناعي الكبرى.

المستقبل موزع. عندما تتمتع التكنولوجيا بمثل هذه الإمكانات الواسعة، يُظهر التاريخ أنها تعمل دائمًا بشكل أفضل وأسرع مما توقعه أي شخص.

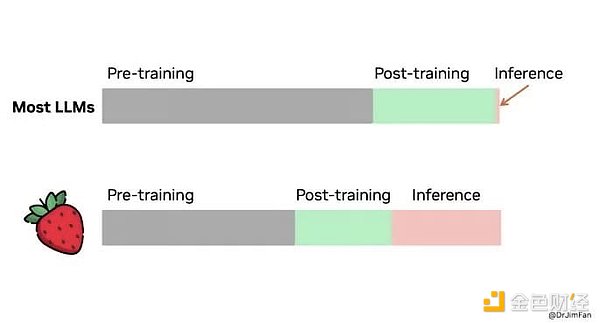

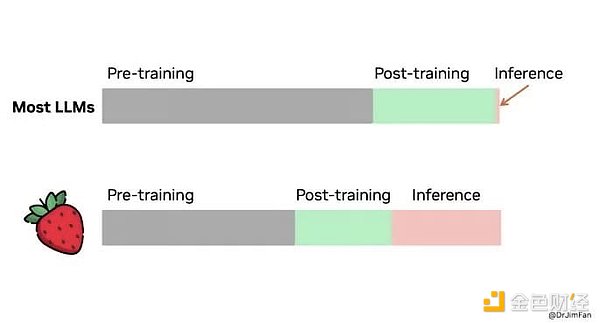

2.3 الاستدلال اللامركزي

حاليًا، الكثير من الاستدلال المصطنع. تركز القوة الحاسوبية لشركة Intelligence على تدريب النماذج واسعة النطاق. هناك منافسة مستمرة بين أفضل مختبرات الذكاء الاصطناعي لمعرفة من يمكنه تطوير أفضل النماذج الأساسية وتحقيق الذكاء الاصطناعي العام في نهاية المطاف.

لكن وجهة نظري هي: في السنوات القليلة المقبلة، ستتحول هذه الحوسبة التي تركز على التدريب إلى الاستدلال. مع تزايد دمج الذكاء الاصطناعي في التطبيقات التي نستخدمها كل يوم - من الرعاية الصحية إلى الترفيه - فإن كمية موارد الحوسبة المطلوبة لدعم الاستدلال ستكون مذهلة.

p>

p>

هذه ليست مجرد تكهنات. يُعد قياس حساب وقت الاستدلال أحدث الكلمات الطنانة في مجال الذكاء الاصطناعي. أصدرت OpenAI مؤخرًا نسخة معاينة/نسخة مصغرة من أحدث طراز لها 01 (الاسم الرمزي: الفراولة)، هل يعد هذا تحولًا كبيرًا؟ يستغرق الأمر وقتًا للتفكير، اسأل نفسك أولاً ما هي الخطوات التي يجب عليك اتخاذها للإجابة على هذا السؤال، ثم تابع خطوة بخطوة.

تم تصميم هذا النموذج للمهام الأكثر تعقيدًا التي تتطلب الكثير من التخطيط، مثل الكلمات المتقاطعة، والمشكلات التي تتطلب تفكيرًا أعمق. ستلاحظ أنه أبطأ، ويستغرق وقتًا أطول لإنشاء الاستجابات، ولكن النتائج أكثر دقة وعمقًا. كما أن تشغيله أكثر تكلفة بكثير (25 مرة أغلى من GPT-4).

إن التحول في التركيز واضح: فالقفزة التالية في أداء الذكاء الاصطناعي لن تأتي فقط من تدريب نماذج أكبر، ولكن أيضًا من توسيع تطبيق الحوسبة أثناء الاستدلال.

إذا كنت تريد معرفة المزيد، فبعض المقالات البحثية توضح:

بمجرد تدريب النماذج القوية، يمكن نقل مهامها الاستدلالية - ما تفعله النماذج - إلى شبكة حوسبة لا مركزية. وهذا منطقي لأن:

يتطلب الاستدلال موارد أقل بكثير. بعد التدريب، يمكن ضغط النموذج وتحسينه باستخدام تقنيات مثل التكميم أو التقليم أو التقطير. ويمكن أيضًا تقسيمها لتعمل على الأجهزة الاستهلاكية اليومية. لا تحتاج إلى وحدة معالجة رسومات متطورة لدعم الاستدلال.

لقد حدث هذا بالفعل. لقد اكتشفت Exo Labs كيفية تشغيل نماذج Llama3 ذات المعلمة 450B على الأجهزة المخصصة للمستهلكين مثل أجهزة MacBooks وMac Minis. قم بتوزيع الاستدلال عبر أجهزة متعددة للتعامل بكفاءة وفعالية من حيث التكلفة مع أعباء العمل واسعة النطاق.

فكر في الاستدلال اللامركزي باعتباره CDN (شبكة توصيل المحتوى) للذكاء الاصطناعي: الاستدلال اللامركزي يعزز قوة الحوسبة المحلية، ويقدم الذكاء الاصطناعي الاستجابات في وقت قياسي بدلاً من خدمة مواقع الويب بسرعة عن طريق الاتصال بالخوادم القريبة. ومن خلال استخدام الاستدلال اللامركزي، تصبح تطبيقات الذكاء الاصطناعي أكثر كفاءة واستجابة وموثوقية.

الاتجاه واضح. تتنافس شريحة M4 Pro الجديدة من Apple مع شريحة RTX 3070 Ti من Nvidia، والتي كانت حتى وقت قريب مجالًا للاعبين المتشددين. أصبحت أجهزتنا قادرة بشكل متزايد على التعامل مع أعباء عمل الذكاء الاصطناعي المتقدمة.

القيمة المضافة للعملات المشفرة

متطلبات شبكة الاستدلال اللامركزية التي يجب أن تكون وإذا نجحت، فيجب أن تكون هناك حوافز مالية مقنعة. يجب تعويض العقد الموجودة في الشبكة عن مساهماتها في قوة الحوسبة. يجب أن يضمن النظام توزيع المكافآت بشكل عادل وفعال. يعد التنوع الجغرافي ضروريًا لتقليل زمن الوصول في مهام الاستدلال وتحسين القدرة على تحمل الأخطاء.

ما هي أفضل طريقة لبناء شبكة لامركزية؟ تشفير.

توفر الرموز المميزة آلية قوية لتنسيق مصالح المشاركين، مما يضمن أن الجميع يعملون لتحقيق نفس الهدف: توسيع الشبكة وزيادة قيمة الرمز المميز.

تعمل الرموز المميزة أيضًا على تسريع نمو الشبكة. فهي تساعد في حل مشكلة الدجاجة والبيضة الكلاسيكية التي أعاقت نمو معظم الشبكات من خلال مكافأة المستخدمين الأوائل وزيادة المشاركة من اليوم الأول.

يثبت نجاح Bitcoin وEthereum ذلك - لقد جمعوا أكبر مجموعة من قوة الحوسبة على هذا الكوكب.

ستكون شبكات الاستدلال اللامركزية هي التالية. نظرًا للتنوع الجغرافي، فإنها تقلل من زمن الوصول، وتزيد من القدرة على تحمل الأخطاء، وتقرب الذكاء الاصطناعي من المستخدمين. وبتحفيزها عن طريق التشفير، فإنها سوف تتوسع بشكل أسرع وأفضل من الشبكات التقليدية.

(للمتابعة، يرجى المتابعة)

Anais

Anais

p>

p> p>

p> p>

p> p>

p>

p>

p> ص>

ص>

p>

p>