التغريدات 13 مرة على التوالي!

كشف مدير OpenAI Super Alignment جان لايكي، الذي تبع إيليا للتو خارج الشركة، عن السبب الحقيقي لترك الشركة، و المزيد بالداخل.

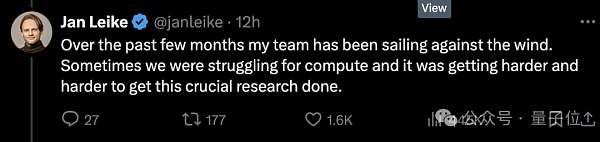

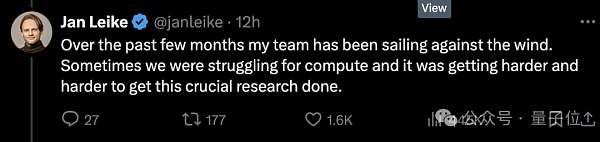

أولاً وقبل كل شيء، قوة الحوسبة ليست كافية، ونسبة الـ 20% الموعودة للفريق فائق الانحياز تفتقر إلى المال مما جعل الفريق يسير عكس الاتجاه ولكن الأمر أصبح أكثر صعوبة.

ثانيًا، لا يتم أخذ الأمان على محمل الجد. لا تمثل الحوكمة الأمنية لـ AGI أولوية عالية مثل إطلاق "المنتجات اللامعة".

بعد ذلك مباشرة، تم حفر المزيد من القيل والقال من قبل الآخرين.

على سبيل المثال، يجب على كل عضو يغادر OpenAI التوقيع على اتفاقية، التعهد بعدم التحدث بشكل سيء عن OpenAI في الخارج بعد الاستقالة، وإلا فإنه سيتم اعتباره تنازلاً تلقائياً عن أسهم الشركة.

لكن لا يزال هناك من يرفض التوقيع ويخرج بأخبار شرسة (يضحك حتى الموت) ويقول إن القيادة الأساسية لديها خلافات طويلة الأمد حول أولوية القضايا الأمنية.

منذ قتال القصر العام الماضي، وصل صراع الأفكار بين الفصيلين إلى نقطة حرجة، ويبدو أنهما انهارا بشكل كريم.

لذلك، على الرغم من أن Ultraman أرسل مؤسسًا مشاركًا لتولي فريق Super Alignment، إلا أنه لا يزال غير مفضل من قبل العالم الخارجي.

شكر مستخدمو الإنترنت على تويتر الذين كانوا في المقدمة جان على شجاعته للتحدث علنًا عن هذا الشيء المذهل، وتنهدوا:

سأمضي قدمًا و يبدو أن OpenAI لا تولي اهتمامًا كبيرًا لهذا الأمان!

ولكن بالنظر إلى الوراء، فإن ألترامان، الذي يتولى الآن مسؤولية OpenAI، لا يزال بإمكانه الجلوس ساكنًا في الوقت الحالي.

وقف وشكر جان على مساهمته في التوافق والأمن الفائقين لـ OpenAI، قائلاً إنه كان في الواقع حزينًا جدًا ومترددًا في مغادرة يناير.

بالطبع النقطة الأساسية هي هذه الجملة:

انتظر، حسنًا، سأقوم بنشر تغريدة أطول من هذه خلال يومين.

إن قوة الحوسبة الموعودة بنسبة 20% هي في الواقع فطيرة كبيرة

منذ معركة قصر OpenAI العام الماضي وحتى الآن، تمكن إيليا، شخصية الروح وكبير العلماء السابق، من بالكاد تظهر وتتحدث علنًا مرة أخرى.

قبل أن يعلن استقالته علنًا، كانت هناك بالفعل آراء مختلفة. يعتقد الكثير من الناس أن إيليا قد رأى شيئًا فظيعًا، مثل نظام الذكاء الاصطناعي الذي قد يدمر البشرية.

△مستخدمي الإنترنت: أول شيء أفعله عندما أستيقظ كل يوم هو التفكير فيما شاهده إيليا

هذه المرة انفتح جان وقال إن السبب الأساسي هو أن الطرف الفني وطرف السوق لديهما وجهات نظر مختلفة حول أولوية الأمن.

الاختلافات خطيرة للغاية، والعواقب الحالية... لقد رآها الجميع.

وفقًا لـ Vox، كشفت مصادر مطلعة على OpenAI أن الموظفين الذين يركزون أكثر على السلامة فقدوا الثقة في Ultraman، "إنها عملية الثقة تنهار شيئا فشيئا."

ولكن كما ترون، لا يرغب الكثير من الموظفين المستقيلين في التحدث عن هذا الأمر علنًا في المنصات والمناسبات العامة.

جزء من السبب هو أن OpenAI لديها تاريخ في جعل الموظفين يوقعون اتفاقيات إنهاء الخدمة مع اتفاقيات عدم الاستخفاف. إذا رفضت التوقيع، فسوف تتخلى عن خيارات OpenAI التي حصلت عليها سابقًا، وهذا يعني أن الموظفين الذين يتحدثون علنًا قد يخسرون مبلغًا ضخمًا من المال.

ومع ذلك، سقطت قطع الدومينو الواحدة تلو الأخرى——

تضيف استقالة إيليا إلى جهود OpenAI الأخيرة موجة الرحيل.

وبعد إعلان استقالتهم، بالإضافة إلى جان قائد فريق Super Alignment، استقال خمسة أعضاء على الأقل من الفريق الأمني.

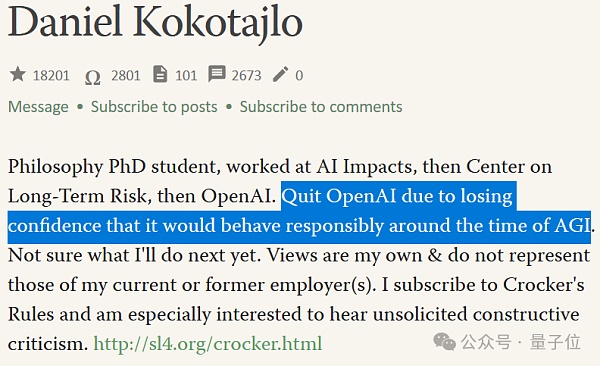

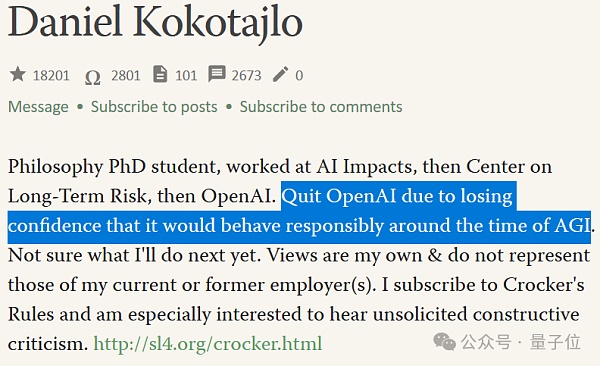

من بينهم دانييل كوكوتايلو (المشار إليه فيما يلي باسم Brother DK) الذي لم يوقع على اتفاقية عدم الانتقاص.

△في العام الماضي، كتب Brother DK أنه يعتقد أن احتمال حدوث كارثة وجودية في الذكاء الاصطناعي يبلغ 70%

انضم شقيق DK إلى OpenAI في عام 2022 وعمل في فريق الحوكمة، وتتمثل مهمته الرئيسية في توجيه OpenAI لنشر الذكاء الاصطناعي بأمان.

لكنه استقال مؤخرًا وقبل إجراء مقابلة:

OpenAI تعمل على تحقيق الهدف إن تدريب أنظمة الذكاء الاصطناعي الأكثر قوة يعني في النهاية تجاوز الذكاء البشري.

قد يكون هذا أفضل شيء حدث للبشرية على الإطلاق، ولكنه قد يكون أيضًا أسوأ شيء إذا لم نتصرف بحذر.

أوضح الأخ DK أنه عندما انضم إلى OpenAI، كان مليئًا بالانتقام والأمل في حوكمة الأمن، على أمل أن تصبح OpenAI أكثر مسؤولية مع اقترابها من AGI . لكن العديد من الأشخاص في الفريق أدركوا ببطء أن OpenAI لن تكون هكذا بعد الآن.

"فقدت الثقة تدريجيًا في قيادة OpenAO وقدرتهم على التعامل مع AGI بمسؤولية." هذا هو سبب استقالة Brother DK.

إن خيبة الأمل بشأن مستقبل العمل الأمني في AGI هي جزء من السبب وراء تكثيف إيليا موجة المغادرة.

جزء من السبب هو أن فريقSuper Alignment قد لا يمتلك الكثير من الموارد لإجراء الأبحاث كما يتصور العالم الخارجي.

حتى لو كان فريق Super Alignment يعمل بكامل طاقته، فيمكن للفريق الحصول على 20% فقط من قوة الحوسبة التي وعدت بها OpenAI.

وغالبًا ما يتم رفض بعض طلبات الفريق.

بالطبع، هذا لأن موارد الحوسبة مهمة للغاية لشركات الذكاء الاصطناعي، ويجب تخصيص كل نقطة بشكل معقول وأيضًا لأن وظيفة فريق Super Alignment؛ هو "حل المشكلة إذا كانت الشركة عند بناء الذكاء الاصطناعي العام (AGI) بنجاح، تظهر بالفعل أنواع مختلفة من المشكلات الأمنية."

بمعنى آخر، يتوافق فريق Super Alignment مع المشكلات الأمنية المستقبلية التي يتعين على OpenAI مواجهتها — النقاط الرئيسية موجودة في المستقبل ولا نعرفها ما إذا كانوا سيظهرون.

اعتبارًا من وقت كتابة المقالة، لم يرسل ألترامان بعد "تغريدته الأطول (من كشف جان عن القصة الداخلية)".

لكنه ذكر بإيجاز أن جان كان على حق في القلق بشأن القضايا الأمنية، "لا يزال أمامنا الكثير لنفعله؛ ونحن ملتزمون أيضًا بهذا افعلها "

في هذه النقطة، يمكن للجميع إعداد مقعد صغير والانتظار، وبعد ذلك يمكننا تناول الطعام معًا في أقرب وقت ممكن.

خلاصة القول أن العديد من الأشخاص تركوا فريق Super Alignment، وخاصة رحيل إيليا وجان، تاركين هذا الفريق العاصف بدون قائد.

ترتيبات المتابعة مخصصة للمؤسس المشارك جون شولما لتولي المسؤولية، ولكن لم يعد هناك فريق متخصص.

سيكون فريق Super Alignment الجديد عبارة عن مجموعة أكثر مرونة تضم أعضاء منتشرين عبر الأقسام في جميع أنحاء الشركة، وهو ما وصفه متحدث باسم OpenAI بأنه "تكامل أعمق".

لقد تم التشكيك في هذا أيضًا من قبل العالم الخارجي، لأن وظيفة جون الأصلية بدوام كامل كانت ضمان أمان منتجات OpenAI الحالية .

أتساءل عما إذا كان جون سيكون قادرًا على أن يكون مشغولاً بعد أن أصبح فجأة يحمل المزيد من المسؤوليات ويقود الفريقين اللذين يركزان على القضايا الأمنية الحالية والمستقبلية؟

نزاع إيليا وألتمان

إذا امتد الخط الزمني، فإن الوضع اليوم سوف يتغير فعليًا ينهار إنه تكملة لنزاع Ilya-Altman "Palace Fight" الخاص بـ OpenAI.

بالعودة إلى نوفمبر من العام الماضي، عندما كان إيليا لا يزال هناك، عمل مع مجلس إدارة OpenAI لمحاولة إقالة ألتمان.

السبب المقدم في ذلك الوقت هو أنه لم يكن صادقًا في اتصالاته. بعبارة أخرى، نحن لا نثق به.

لكن النتيجة النهائية كانت واضحة حيث هدد ألتمان بالانضمام إلى مايكروسوفت مع "حلفائه". ونتيجة لذلك، استسلم مجلس الإدارة واستسلم فشل الاستدعاء. إيليا يترك مجلس الإدارة. ومن جانبه اختار الترامان الأعضاء الأكثر فائدة له للانضمام إلى مجلس الإدارة.

وبعدها اختفى إيليا عن منصات التواصل الاجتماعي حتى الإعلان الرسمي عن استقالته قبل أيام. ويقال إنه لم يظهر في مكتب OpenAI منذ حوالي 6 أشهر.

كما ترك تغريدة مثيرة للاهتمام في ذلك الوقت، لكن تم حذفها بسرعة.

في الشهر الماضي، تعلمت الكثير من الدروس. أحد الدروس المستفادة هو أن عبارة "سيستمر الضرب حتى تتحسن الروح المعنوية" تنطبق في كثير من الأحيان أكثر مما ينبغي.

ولكن وفقًا للمطلعين على بواطن الأمور، كان إيليا يشارك في قيادة فريق Super Alignment عن بعد.

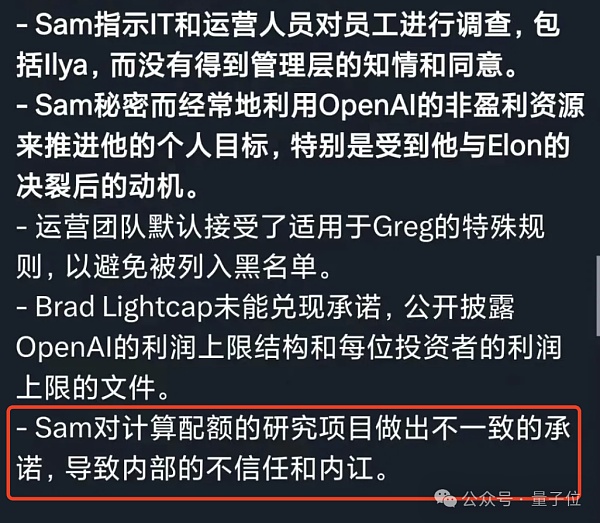

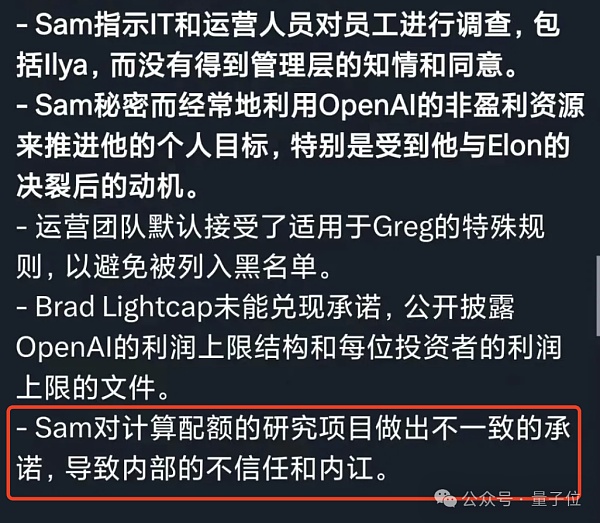

أما ألترامان فإن أكبر اتهام موجه له من قبل الموظفين هو أن أقواله وأفعاله غير متسقة، فهو على سبيل المثال يدعي أنه يريد إعطاء الأولوية للسلامة، ولكن سلوكه ولكن متناقض جدا.

باستثناء أنه لم يتم توفير موارد الحوسبة الموعودة في الأصل. على سبيل المثال، اتصلنا مؤخرًا بالمملكة العربية السعودية ودول أخرى لجمع الأموال اللازمة لتصنيع النوى.

هؤلاء الموظفون الذين يهتمون بالسلامة مرتبكون.

إذا كان يهتم حقًا ببناء ونشر الذكاء الاصطناعي بأكثر الطرق أمانًا الممكنة، ألن يكون مجنونًا جدًا بشأن تجميع الرقائق لتسريع تطوير التكنولوجيا ؟

في وقت سابق، طلبت شركة OpenAI شرائح من شركة ناشئة يستثمر فيها Altman. يصل المبلغ إلى 51 مليون دولار أمريكي (حوالي 360 مليون يوان صيني).

يبدو أن وصف Ultraman قد تم تأكيده مرة أخرى في رسالة تقرير من موظف سابق في OpenAI خلال أيام Gong Dou.

وبسبب هذا "التناقض بين الأقوال والأفعال" على وجه التحديد، يفقد الموظفون الثقة تدريجيًا في OpenAI وUltraman.

إيليا هكذا، وجان لايكي هكذا، وفريق Super Alignment هكذا.

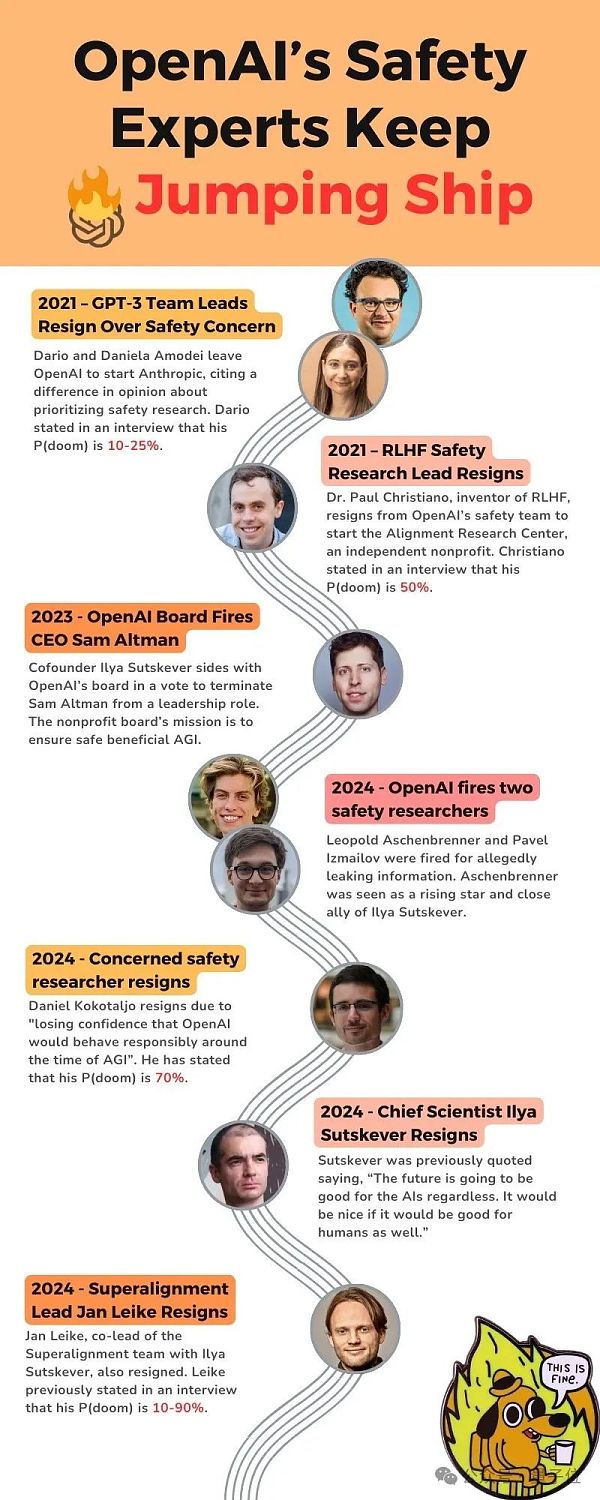

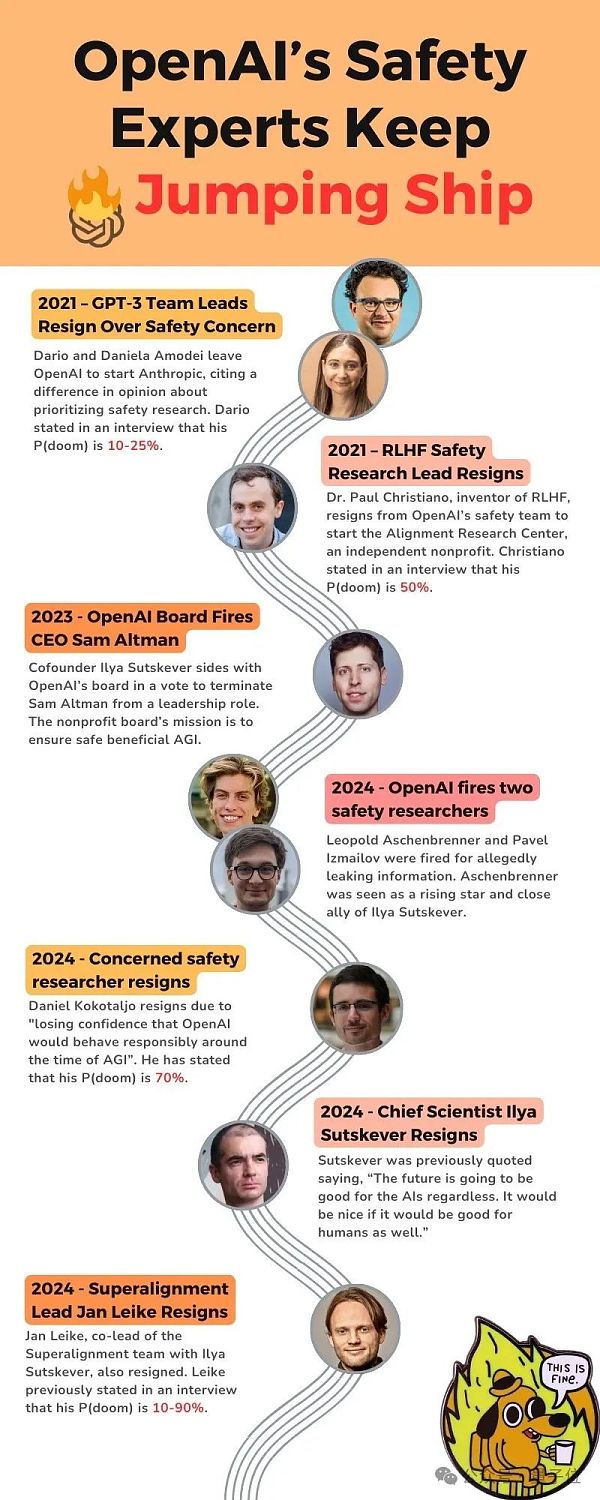

قام بعض مستخدمي الإنترنت المراعين بفرز العقد المهمة للأشياء ذات الصلة التي حدثت في السنوات القليلة الماضية - اسمحوا لي أن أقدم لكم تذكيرًا مدروسًا، مذكور أدناه يشير P (الموت) إلى "احتمال تسبب الذكاء الاصطناعي في سيناريو يوم القيامة".

في عام 2021، غادر قائد فريق GPT-3 OpenAI بسبب مشكلات "أمنية" وأسس Anthropic، وكان أحدهم يعتقد أن P (doom). 10-25% ;

في عام 2021، استقال رئيس أبحاث الأمان في RLHF، P (الموت) هو 50%؛

في عام 2023، قام مجلس إدارة OpenAI بإقالة ألتمان؛

في عام 2024، قامت OpenAI بفصل اثنين من الباحثين الأمنيين؛

< p style="text -align: left;">في عام 2024، استقال أحد الباحثين في OpenAI الذي أولى اهتمامًا خاصًا بالأمن، وكان يعتقد أن نسبة P (الموت) وصلت بالفعل إلى 70%.

في عام 2024، استقال إيليا وجان لايكي.

التكنولوجيا أم السوق؟

منذ تطوير النماذج الكبيرة، يمكن في الواقع أن تُعزى "كيفية تنفيذ الذكاء الاصطناعي العام؟" إلى طريقين.

المدرسة الفنية تأمل أن تكون التكنولوجيا ناضجة ويمكن التحكم فيها قبل التطبيق؛ وتعتقد مدرسة السوق ذلك سيتم تطبيقه أثناء الانفتاح "حتى النهاية.

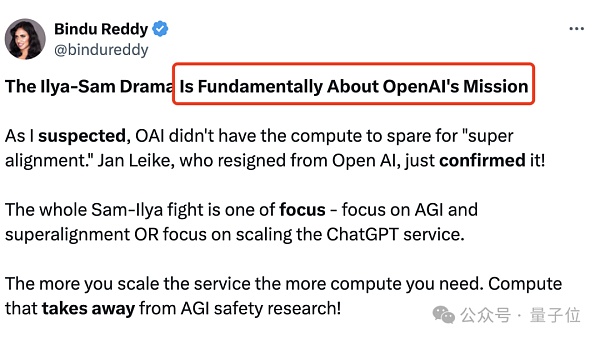

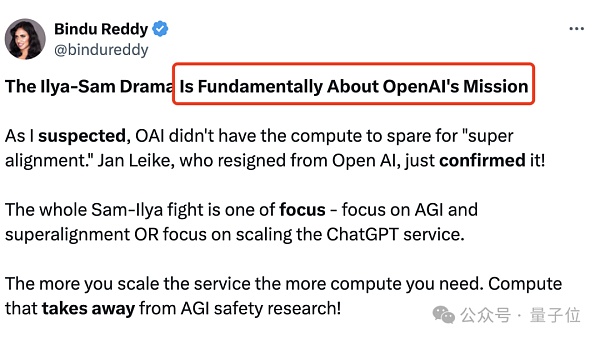

وهذا أيضًا هو الاختلاف الأساسي في نزاع Ilya-Altman، وهو مهمة OpenAI:

هل يجب أن نركز على AGI والمحاذاة الفائقة أم يجب أن نركز على توسيع خدمة ChatGPT؟

كلما زاد حجم خدمة ChatGPT، زاد مقدار العمليات الحسابية المطلوبة؛ وسيستغرق هذا أيضًا وقتًا لأبحاث أمان AGI.

إذا كانت OpenAI منظمة غير ربحية مخصصة للبحث، فيجب عليها قضاء المزيد من الوقت في المحاذاة الفائقة.

انطلاقًا من بعض مبادرات OpenAI الخارجية، من الواضح أن النتيجة ليست كذلك.إنهم يريدون فقط أخذ زمام المبادرة في منافسة النماذج الكبيرة وتزويد المؤسسات مع والمزيد من الخدماتللمستهلكين.

في رأي إيليا هذا أمر خطير للغاية. على الرغم من أننا لا نعرف ما سيحدث مع زيادة الحجم، في رأي إيليا، فإن أفضل نهج هو وضع السلامة في المقام الأول.

كن منفتحًا وشفافًا حتى نتمكن نحن البشر من ضمان بناء الذكاء الاصطناعي العام بشكل آمن، وليس بطريقة سرية.

ولكن تحت قيادة Ultraman، يبدو أن OpenAI لا تسعى إلى تحقيق المصدر المفتوح أو التوافق الفائق. وبدلاً من ذلك، فهي عازمة على الركض بعنف في اتجاه الذكاء الاصطناعي العام أثناء محاولتها بناء خندق.

إذاً في النهاية، هل قام عالم الذكاء الاصطناعي إيليا بالاختيار الصحيح، أم أن رجل الأعمال في وادي السليكون ألترامان سيصل إلى النهاية؟

لا توجد طريقة لمعرفة ذلك حتى الآن. لكن على الأقل تواجه OpenAI الآن قرارًا حاسمًا.

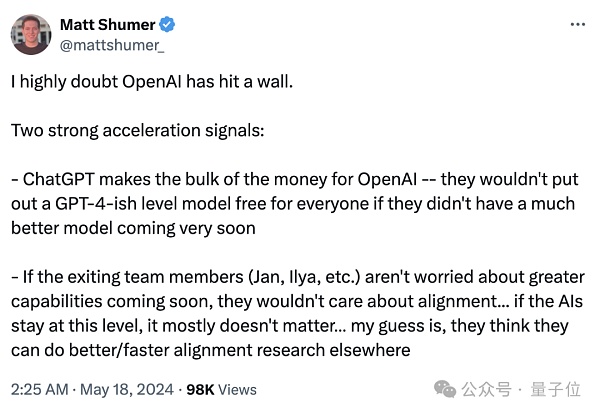

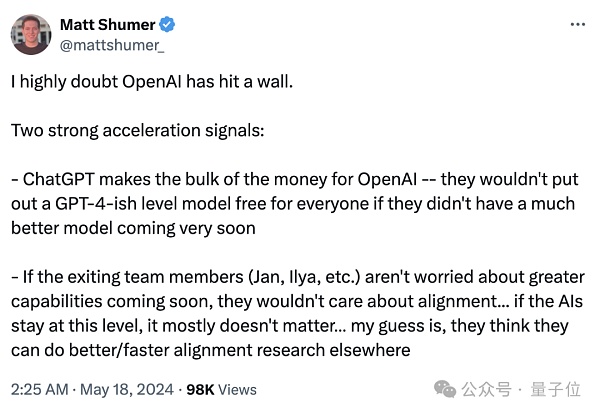

لقد لخص بعض الأشخاص في الصناعة إشارتين رئيسيتين،

واحد< /p> strong>نعم ChatGPT هو الدخل الرئيسي لـ OpenAI بدون دعم أفضل للنموذج، لن يتم توفير GPT-4 للجميع مجانًا؛

الشيء الآخر هو أنه إذا كان أعضاء الفريق المغادرون (جان، إيليا، وما إلى ذلك) لا يقلقون بشأن الميزات القوية التي ستتوفر قريبًا، فلن يهتموا بها مشكلات المحاذاة... إذا بقي الذكاء الاصطناعي عند هذا المستوى، فهذا لا يهم في الأساس.

لكن التناقض الأساسي في OpenAI لم يتم حله. فمن ناحية، هناك مخاوف لدى علماء الذكاء الاصطناعي المسروقين بشأن التطوير المسؤول للذكاء الاصطناعي العام، ومن ناحية أخرى، هناك إلحاح السيليكون تقوم حفلات سوق Valley بتعزيز استدامة التكنولوجيا من خلال التسويق التجاري.

أصبح الطرفان غير قابلين للتوفيق بين المجموعة العلمية وخرجت تمامًا من OpenAI، ولا يزال العالم الخارجي لا يعرف إلى أين وصلت GPT؟

الأشخاص الذين يتوقون لمعرفة إجابة هذا السؤال متعبون بعض الشيء.

لقد غمرني شعور بالعجز، تمامًا كما قال هينتون، معلم إيليا، أحد عمالقة جائزة تورينج الثلاثة:

أنا كبير في السن، وأشعر بالقلق، ولكن ليس هناك ما يمكنني فعله.

الرابط المرجعي:

[1]https://www.vox.com/future-perfect/2024/5/17/ 24158403/openai-resignations-ai-safety-ilya-sutskever-jan-leike-artificial-intelligence

[2]https://x.com/janleike/status/1791498174659715494

[3]https:// twitter.com/sama/status/1791543264090472660

JinseFinance

JinseFinance