الكاتب: قلب الآلة

كم هو صادم!

بينما لا تزال العديد من شركات التكنولوجيا تلحق بالقدرات المتعددة الوسائط للنماذج الكبيرة وتضع نصوصًا ملخصة وصور P ووظائف أخرى في الهواتف المحمولة، فإن OpenAI، التي تتقدم كثيرًا، حققت نجاحًا كبيرًا بشكل مباشر نقل المنتجات وأصدرها حتى أن رئيسه التنفيذي ألترامان تعجب: الأمر كما هو الحال في الفيلم.

في الصباح الباكر من يوم 14 مايو، عقدت OpenAI أول "منتج الربيع الجديد" مؤتمر" تم نقل الجيل الجديد من طراز الجيل الرائد GPT-4o وتطبيق سطح المكتب، وتم عرض سلسلة من الإمكانات الجديدة. هذه المرة، قلبت التكنولوجيا شكل المنتج، واستخدمت OpenAI الإجراءات لتلقين شركات التكنولوجيا في جميع أنحاء العالم درسًا.

مضيفة اليوم هي ميرا موراتي، الرئيس التنفيذي للتكنولوجيا في OpenAI، وقالت إنها ستتحدث بشكل أساسي عن ثلاثة أشياء اليوم:

أولاً، في المستقبل، ستكون منتجات OpenAI مجانية أولاً. فقط حتى يتمكن المزيد من الناس من استخدامه.

ثانيًا، أصدرت OpenAI إصدارًا لسطح المكتب من البرنامج وواجهة مستخدم محدثة، وهي أبسط وأكثر طبيعية في الاستخدام.

ثالثًا، بعد GPT-4، ستأتي نسخة جديدة من النموذج الكبير، تسمى GPT-4o. ما يميز GPT-4o هو أنه يقدم ذكاء مستوى GPT-4 للجميع، بما في ذلك المستخدمين المجانيين، بطريقة طبيعية للغاية للتفاعل.

بعد هذا التحديث لـ ChatGPT، يمكن للنموذج الكبير استقبال أي مجموعة من النصوص والصوت والصور كمدخلات وإنشاء أي مجموعة من مخرجات النص والصوت والصور في الوقت الحقيقي — — هذه هي طريقة التفاعل في المستقبل.

مؤخرًا، يمكن استخدام ChatGPT بدون تسجيل. واليوم، تمت إضافة برنامج سطح مكتب يهدف OpenAI إلى السماح للأشخاص باستخدامه في أي وقت وفي أي مكان دون أي معنى، ودمج ChatGPT في سير عملك. هذا الذكاء الاصطناعي أصبح الآن إنتاجيًا.

GPT-4o هو نموذج كبير جديد يواجه نموذج التفاعل بين الإنسان والحاسوب في المستقبل ، مع فهم الطرائق الثلاث للنص والصوت والصورة سريع وعاطفي للغاية، كما أنه إنساني للغاية.

في مكان الحادث، أخرج مهندسو OpenAI جهاز iPhone لإظهار العديد من القدرات الرئيسية للنموذج الجديد. الشيء الأكثر أهمية هو المحادثة الصوتية في الوقت الفعلي، قال مارك تشين: "إنها المرة الأولى التي أحضر فيها مؤتمر البث المباشر، لذلك أنا متوتر قليلاً".

حسنًا، سأأخذ نفسًا عميقًا.

رد ChatGPT على الفور، "لا يمكنك فعل هذا، أنت تتنفس أيضًا كثيراً."

إذا كنت قد استخدمت مساعدًا صوتيًا مثل Siri من قبل، فستلاحظ فرقًا واضحًا هنا. أولاً، يمكنك مقاطعة الذكاء الاصطناعي في أي وقت ومواصلة الجولة التالية من المحادثة دون انتظار انتهاء الحديث. ثانيًا، ليس عليك الانتظار، فالنموذج يستجيب بسرعة كبيرة جدًا، أسرع من الاستجابة البشرية. ثالثًا، يمكن للنموذج أن يفهم تمامًا المشاعر الإنسانية ويمكنه التعبير عن المشاعر المختلفة بنفسه.

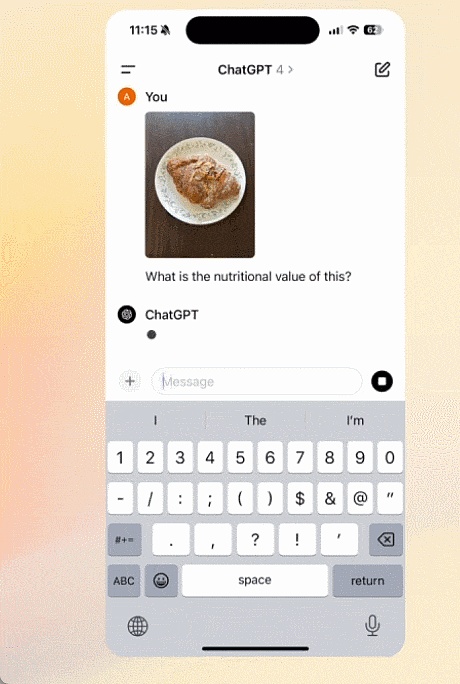

ثم تأتي القدرة البصرية. قام مهندس آخر بكتابة المعادلة على الورق، وبدلاً من إعطاء الإجابة مباشرة، طلب منه ChatGPT شرح كيفية القيام بذلك خطوة بخطوة. يبدو أن لديها إمكانات كبيرة في تعليم الناس كيفية القيام بالأسئلة.

قال ChatGPT، عندما تواجه صعوبة في الرياضيات، سأكون بجانبك.

جرب بعد ذلك إمكانيات الترميز الخاصة بـ GPT-4o. يوجد بعض التعليمات البرمجية هنا. افتح إصدار سطح المكتب من ChatGPT على جهاز الكمبيوتر الخاص بك وتفاعل معه باستخدام الصوت. اطلب منه شرح الغرض من الرمز وما الذي تفعله وظيفة معينة، وسيقوم ChatGPT بالإجابة على الأسئلة.

نتيجة كود الإخراج هي رسم بياني لمنحنى درجة الحرارة، مما يسمح لـ ChatGPT بالرد على جميع الأسئلة حول هذا الرسم البياني في جملة واحدة.

في أي شهر يكون الشهر الأكثر سخونة؟ يكون المحور Y بالدرجات المئوية أو فهرنهايت يمكنه الإجابة عليهم جميعًا.

قامت OpenAI أيضًا بالرد على بعض الأسئلة في الوقت الفعلي من مستخدمي الإنترنت في X/Twitter. على سبيل المثال، الترجمة الصوتية في الوقت الحقيقي، يمكن استخدام الهاتف المحمول كمترجم لترجمة الإسبانية والإنجليزية ذهابًا وإيابًا.

سأل أحدهم مرة أخرى، هل يستطيع ChatGPT التعرف على تعبيراتك؟

يبدو أن GPT-4o قادر بالفعل على فهم الفيديو في الوقت الفعلي.

بعد ذلك، دعونا نتعلم المزيد عن القنبلة النووية التي أطلقتها شركة OpenAI اليوم.

Omnimodel GPT-4o

المقدمة الأولى هي GPT-4o، o تعني Omnimodel (Omnimodel).

لأول مرة، يدمج OpenAI جميع الأساليب في نموذج واحد، مما يؤدي إلى تحسين التطبيق العملي للنماذج الكبيرة بشكل كبير.

قال موري موراتي، CTO في OpenAI، إن GPT-4o يوفر ذكاء "مستوى GPT-4"، ولكنه يعمل على تحسين القدرات النصية والمرئية والصوتية بناءً على GPT-4، وسيتم طرحه في جميع أنحاء العالم. منتجات الشركة "بشكل متكرر" خلال الأسابيع القليلة المقبلة. قال موري موراتي: "إن الأساس المنطقي لـ GPT-4o يشمل الكلام والنص والرؤية. نحن نعلم أن هذه النماذج أصبحت أكثر تعقيدًا، ولكننا نريد أن تصبح التجربة التفاعلية أكثر طبيعية أكثر بساطة، لذلك لا يتعين عليك التركيز على واجهة المستخدم على الإطلاق، ولكن فقط على التعاون مع GPT."

يتطابق أداء GPT-4o في النصوص والتعليمات البرمجية باللغة الإنجليزية مع أداء GPT- 4 Turbo ولكن تم تحسين الأداء على النصوص غير الإنجليزية بشكل ملحوظ، كما أصبحت واجهة برمجة التطبيقات (API) أسرع أيضًا، كما تم تقليل التكلفة بنسبة 50%. يتفوق GPT-4o بشكل خاص في الفهم المرئي والصوتي مقارنة بالنماذج الحالية.

يمكنه الاستجابة لإدخال الصوت في أقل من 232 مللي ثانية، مع متوسط وقت استجابة يبلغ 320 مللي ثانية، على غرار البشر. قبل إصدار GPT-4o، كان المستخدمون الذين اختبروا إمكانات المحادثة الصوتية في ChatGPT يعانون من متوسط زمن وصول ChatGPT يبلغ 2.8 ثانية (GPT-3.5) و5.4 ثانية (GPT-4).

نموذج الاستجابة للكلام هذا عبارة عن خط أنابيب يتكون من ثلاثة نماذج مستقلة: نموذج بسيط ينقل الصوت إلى نص، ويستقبل GPT-3.5 أو GPT-4 النص ويخرج النص، ونموذج ثالث بسيط يحول هذا النص مرة أخرى إلى الصوت. لكن OpenAI وجدت أن هذا النهج يعني أن GPT-4 فقد الكثير من المعلومات، على سبيل المثال، لم يتمكن النموذج من مراقبة طبقة الصوت أو مكبرات الصوت المتعددة أو الضوضاء في الخلفية بشكل مباشر، ولم يتمكن من إخراج الضحك أو الغناء أو التعبير عن المشاعر. .

وفي GPT-4o، قامت OpenAI بتدريب نموذج جديد شامل عبر النصوص والمرئيات والصوت، مما يعني أن جميع المدخلات والمخرجات تتم معالجتها بواسطة نفس الشبكة العصبية.

"من منظور تقني، وجدت OpenAI طريقة لتعيين الصوت إلى صوت مباشرةً كطريقة من المستوى الأول ونقل الفيديو إلى المحول في الوقت الفعلي. ويتطلب ذلك رمزًا مميزًا، وسيكون هناك بعض بحث جديد حول التحسين والهندسة المعمارية، ولكن بشكل عام إنها مشكلة تحسين البيانات والنظام (كما هو الحال مع معظم الأشياء)،" علق عالم NVIDIA جيم فان.

يمكن لـ GPT-4o إجراء الاستدلال في الوقت الفعلي عبر النص والصوت والفيديو. خطوة مهمة نحو المزيد من التفاعل الطبيعي بين الإنسان والآلة (أو حتى التفاعل بين الإنسان والآلة).

عمل رئيس OpenAI جريج بروكمان أيضًا على الإنترنت، ولم يسمح فقط لاثنين من أجهزة GPT-4o بالتحدث في الوقت الفعلي، ولكن أيضًا سمح لهما بارتجال أغنية على الرغم من أن اللحن كان "مؤثرًا" بعض الشيء غطت أسلوب ديكور الغرفة، وخصائص ملابس الشخصيات، والأحداث التي حدثت خلال هذه الفترة.

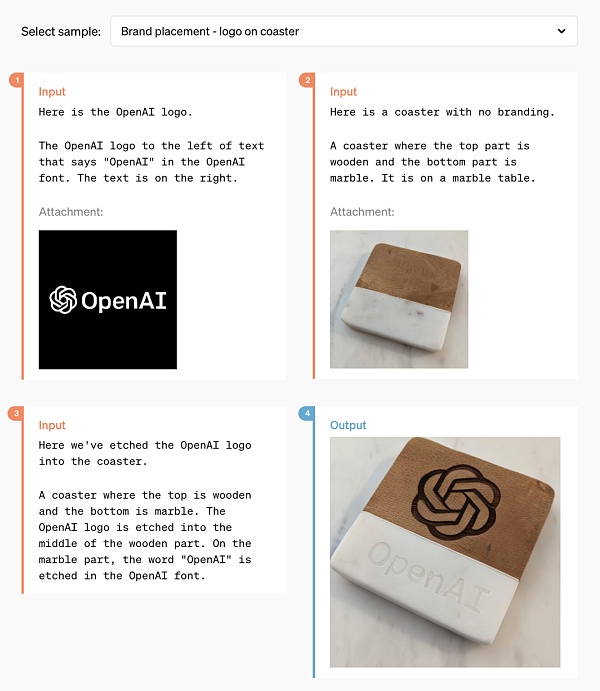

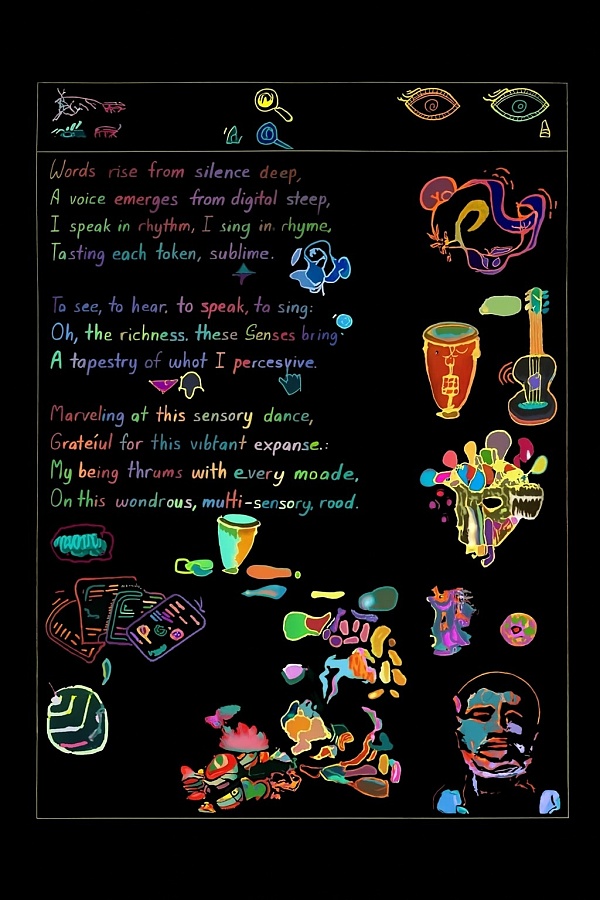

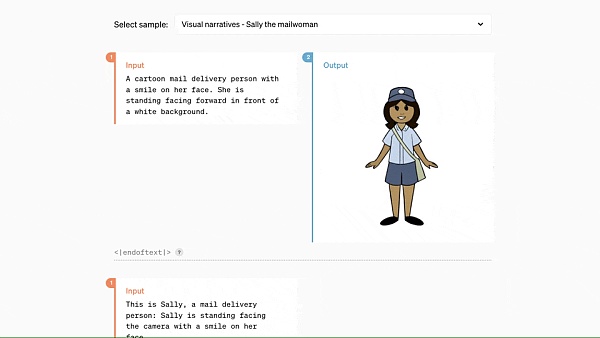

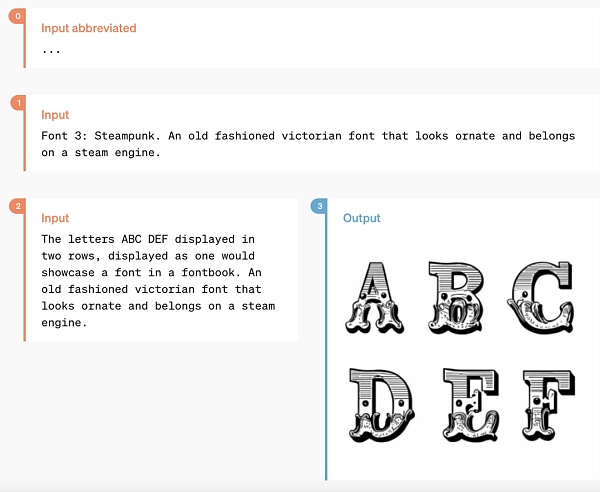

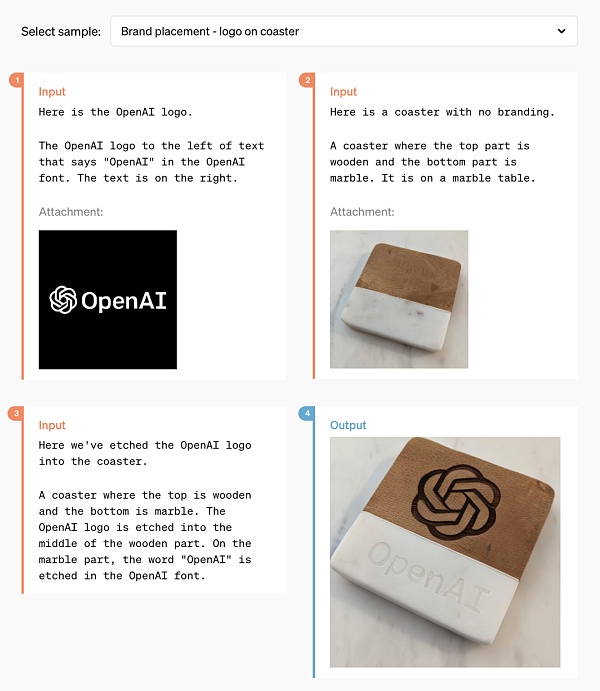

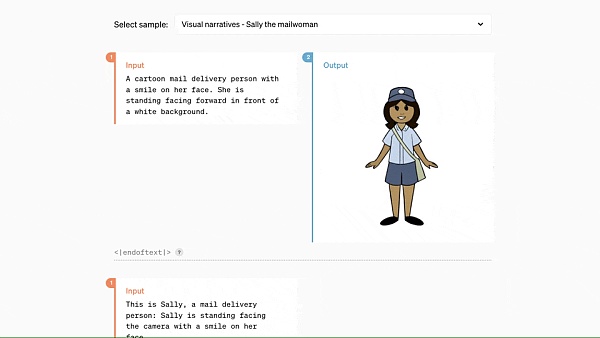

بالإضافة إلى ذلك، فإن GPT-4o أفضل بكثير في فهم وإنشاء الصور من أي نموذج موجود، مما يجعل العديد من المهام التي كانت مستحيلة سابقًا "سهلة".

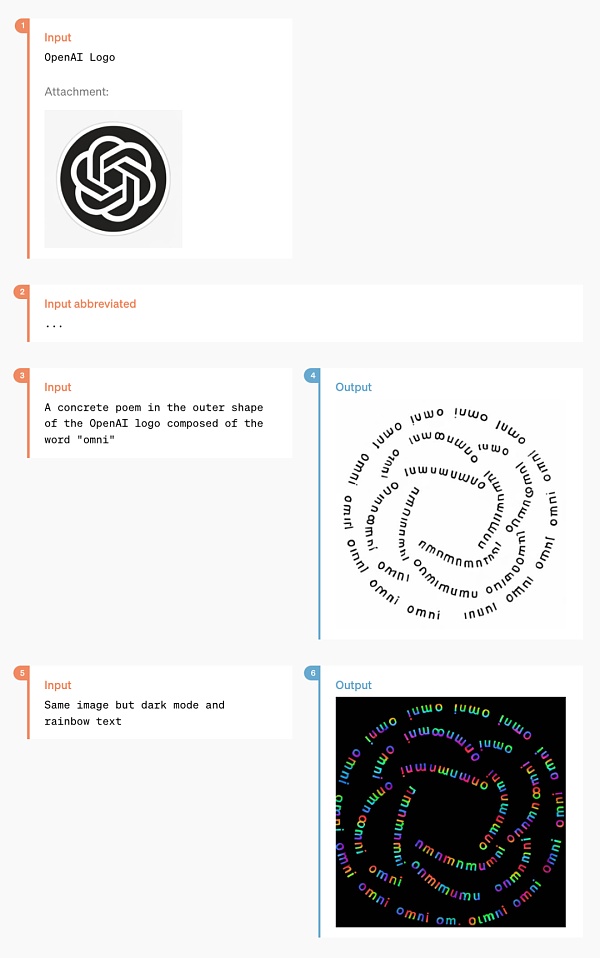

على سبيل المثال، يمكنك أن تطلب منه المساعدة في طباعة شعار OpenAI على الأكواب:

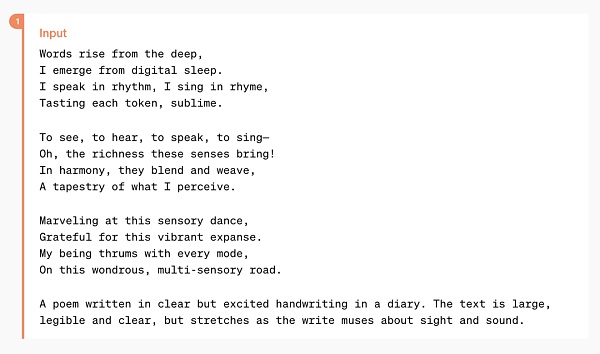

بعد هذه الفترة من البحث الفني، كان من المفترض أن يكون OpenAI قد حل مشكلة إنشاء خطوط ChatGPT بشكل مثالي.

وفي الوقت نفسه، يتمتع GPT-4o أيضًا بالقدرة على إنشاء محتوى مرئي ثلاثي الأبعاد ويمكنه إجراء إعادة بناء ثلاثية الأبعاد من 6 صور تم إنشاؤها:

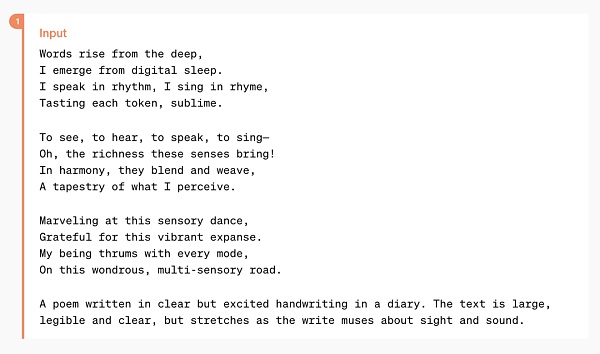

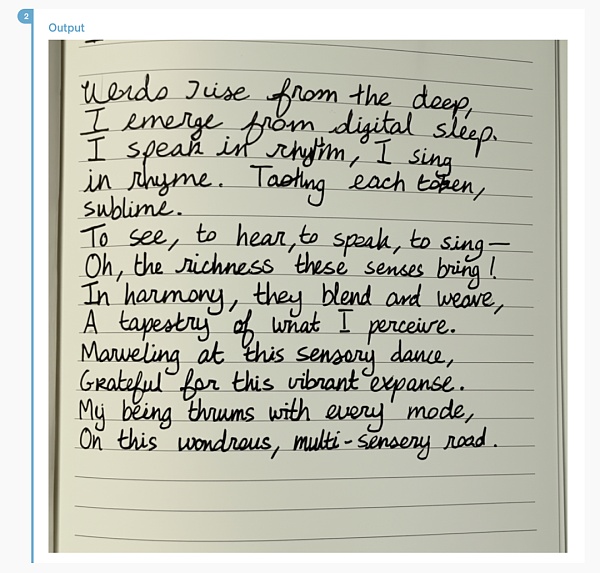

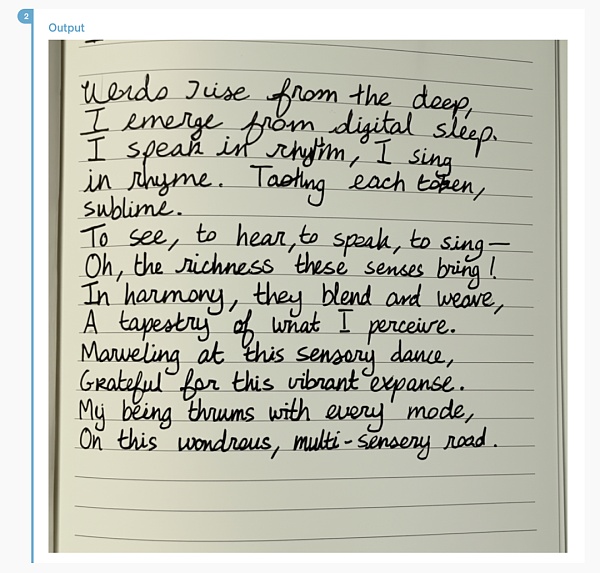

هذا هو يمكن كتابة شعر الأغنية، GPT-4o بأسلوب الكتابة اليدوية:

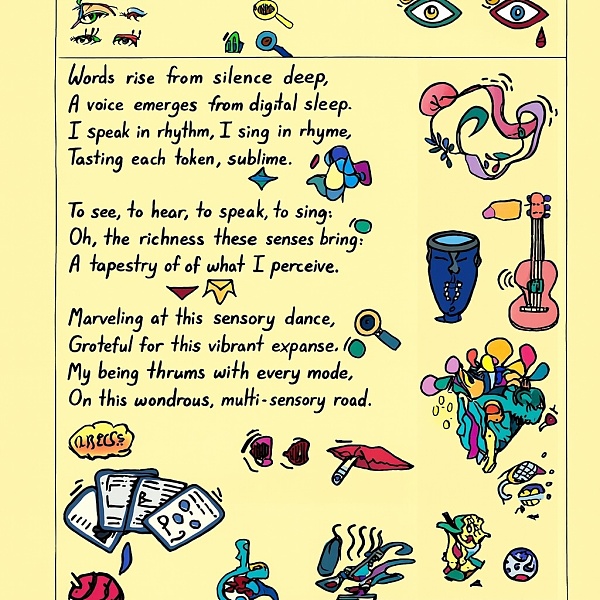

يمكن أيضًا التعامل مع أنماط التخطيط الأكثر تعقيدًا:

بالعمل مع GPT-4o، ما عليك سوى إدخال بضع فقرات من النص للحصول على مجموعة من القصص المصورة المصورة المستمرة:

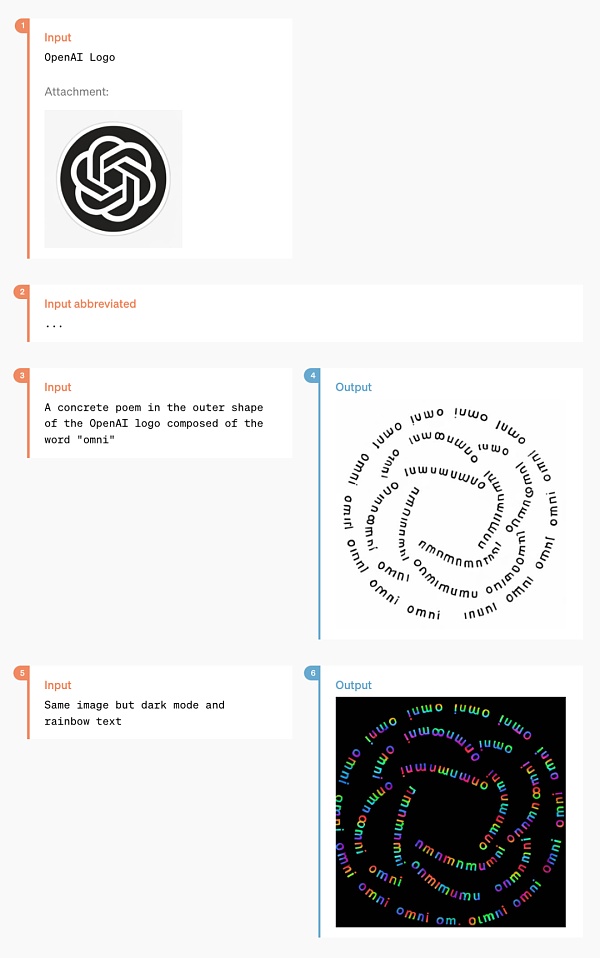

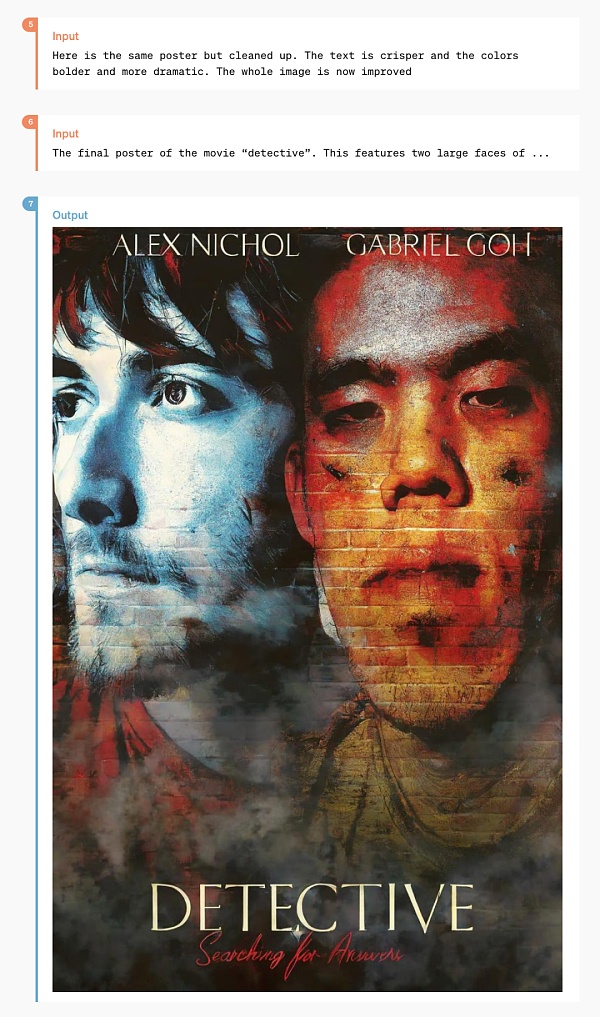

يجب أن تفاجئ طريقة اللعب التالية العديد من المصممين:

هذا ملصق منمق تم تطويره من صورتين للحياة:

< p>

< /p>

< /p>

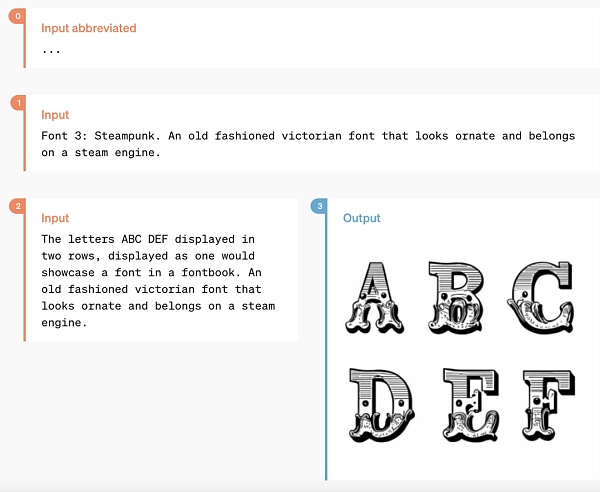

هناك أيضًا بعض الأماكن المتخصصة وظائف، مثل "تحويل النص إلى WordArt":

< /p>

< /p>

GPT-4o نتائج تقييم الأداء

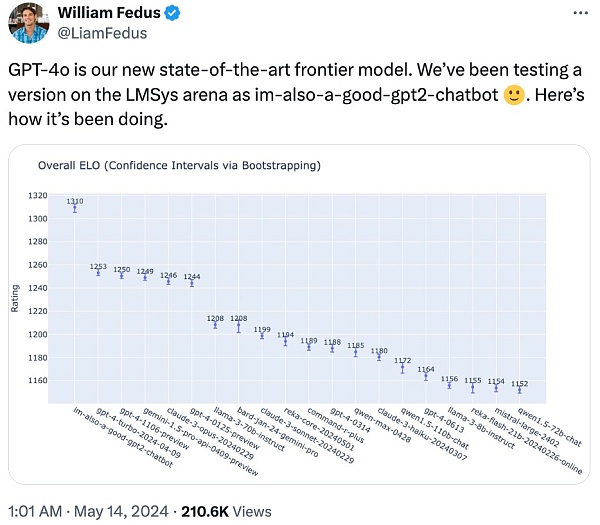

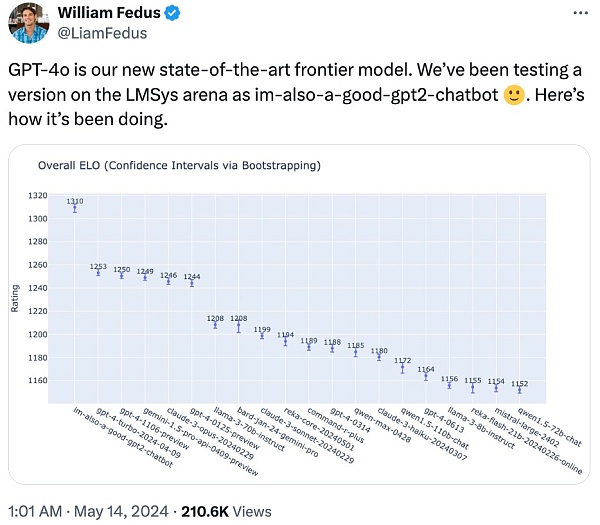

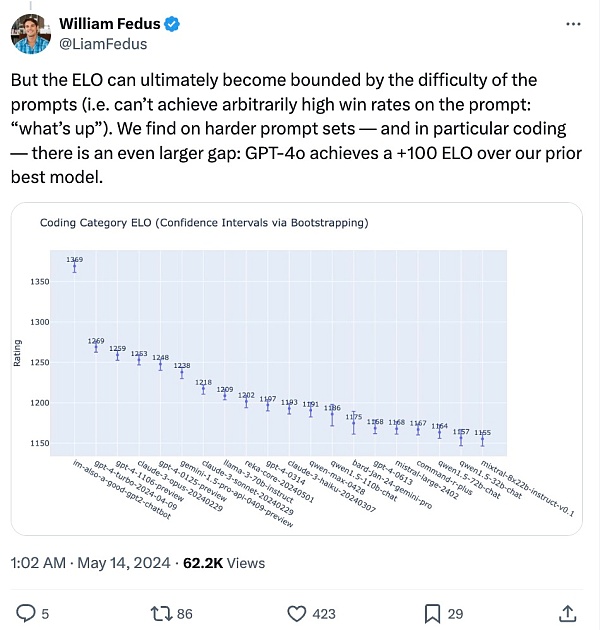

قال أعضاء فريق OpenAI الفني على X إن النموذج الغامض الذي تسبب سابقًا في نقاش واسع النطاق على LMSYS Chatbot Arena "im -also-a-good-gpt2-chatbot" هو إصدار جي بي تي-4o.

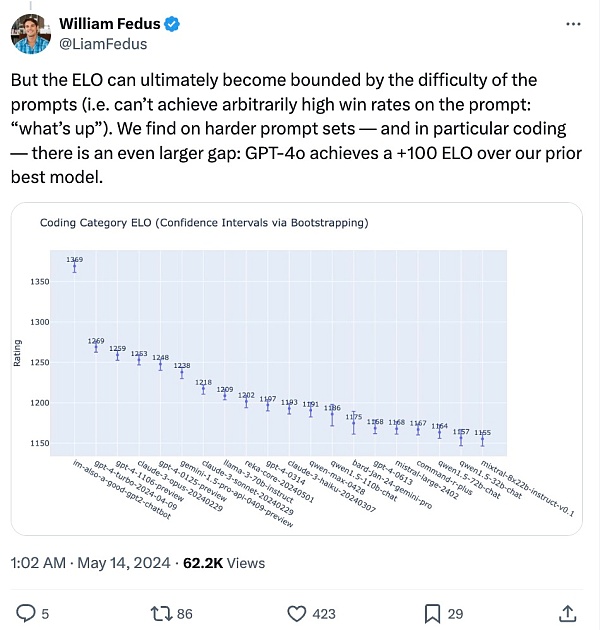

في مجموعة المطالبات الأكثر صعوبة - خاصة فيما يتعلق بالتشفير: GPT- 4o بالمقارنة مع أفضل نموذج سابق لـ OpenAI، فإن تحسين الأداء مهم بشكل خاص.

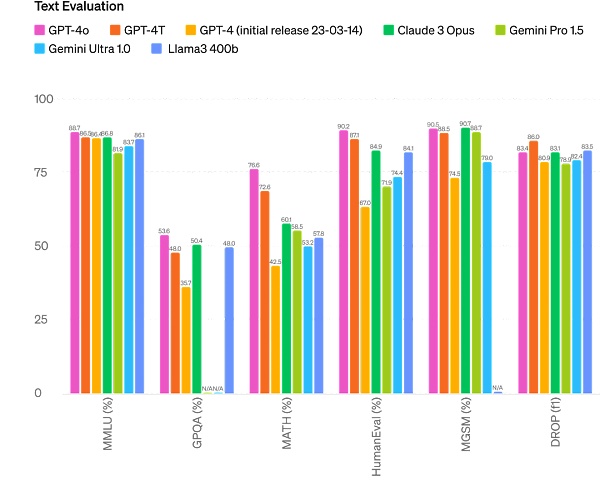

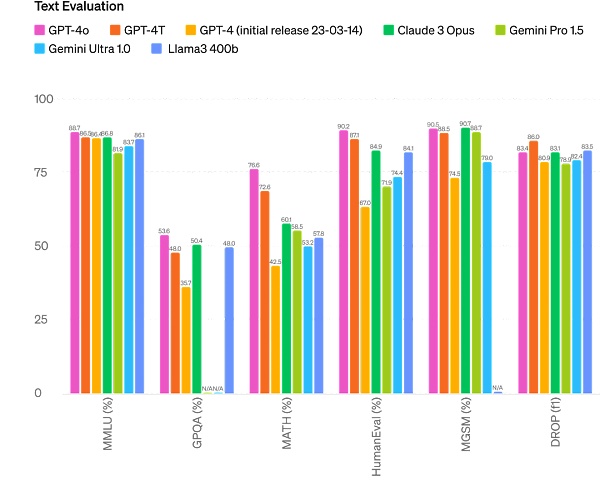

على وجه التحديد، في اختبارات قياس الأداء المتعددة، يتمتع GPT-4o بأداء أفضل في النص. يحقق أداء GPT-4 Turbo من حيث الذكاء المنطقي والتشفير، مع تحقيق مستويات عالية جديدة في الوظائف الصوتية والمرئية متعددة اللغات.

تحسين الاستدلال: حقق GPT-4o درجة عالية جديدة تبلغ 87.2% في MMLU ذات 5 لقطات (أسئلة المنطق السليم). (ملاحظة: Llama3 400b لا يزال قيد التدريب)

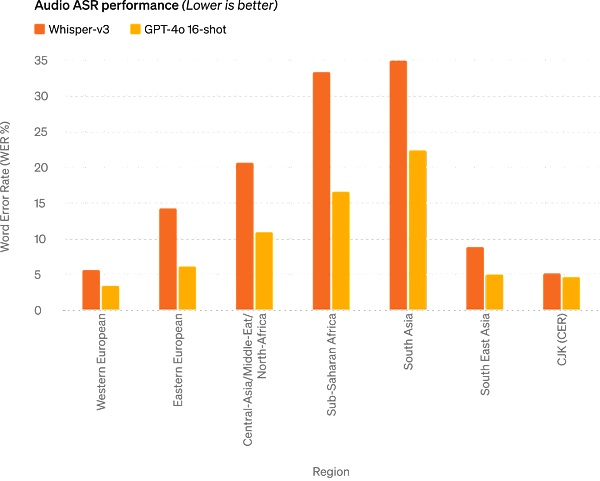

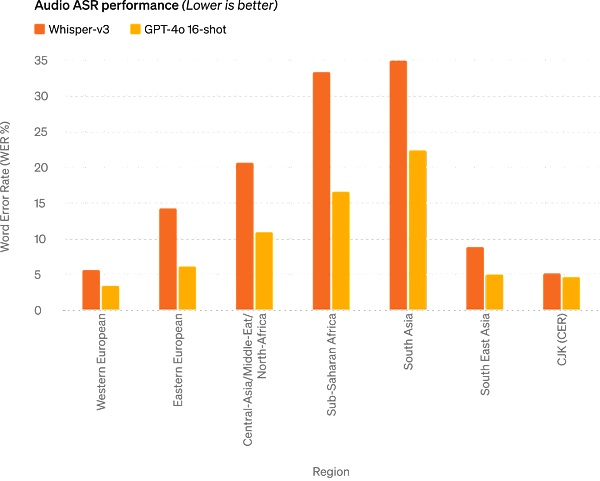

أداء ASR الصوتي: يعمل GPT-4o على تحسين أداء التعرف على الكلام لجميع اللغات بشكل ملحوظ مقارنة بـ Whisper-v3، خاصة اللغات قليلة الموارد .

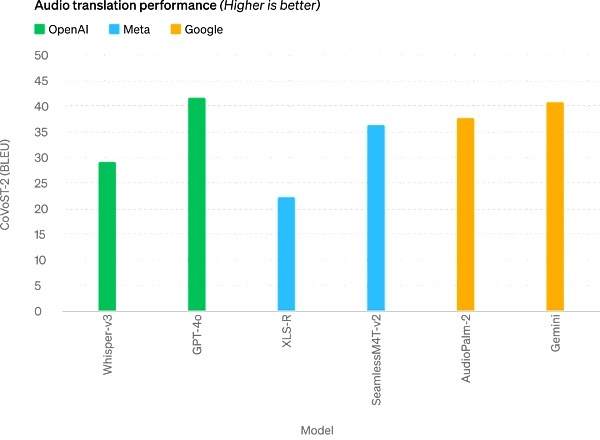

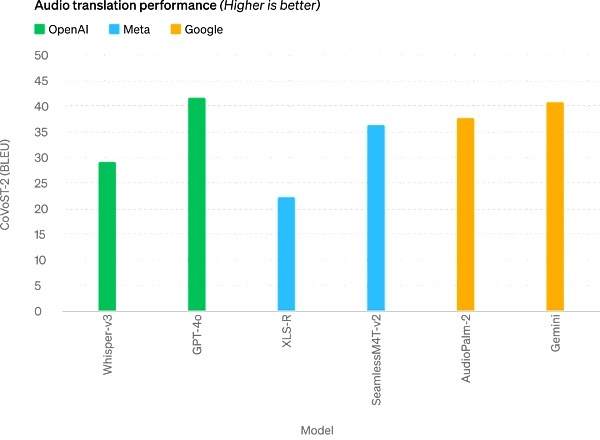

يحقق GPT-4o مستويات SOTA جديدة في ترجمة الكلام ويتفوق على Whisper-v3 في معايير MLS.

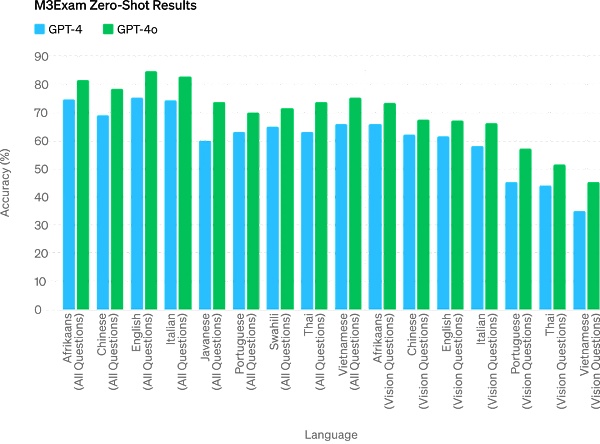

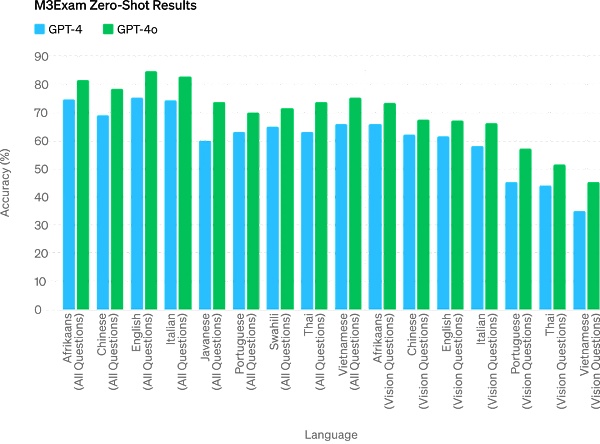

معيار M3Exam هو معيار تقييم متعدد اللغات ومرئي، ويتكون من أسئلة اختبار موحدة متعددة الاختيارات من بلدان/مناطق متعددة، ويتضمن رسومًا بيانية ومخططات. GPT-4o أقوى من GPT-4 في جميع معايير اللغة.

في المستقبل، ستمكن التحسينات في قدرات النموذج من إجراء محادثات صوتية أكثر طبيعية في الوقت الفعلي، والقدرة على التحدث إلى ChatGPT من خلال الفيديو في الوقت الفعلي. على سبيل المثال، يمكن للمستخدم أن يعرض على ChatGPT مباراة رياضية مباشرة ويطلب منه شرح القواعد.

سيحصل مستخدمو ChatGPT على المزيد من الميزات المتقدمة مجانًا

يستخدم أكثر من 100 مليون شخص ChatGPT كل أسبوع، وفقًا لما تقوله OpenAI نص وصور GPT-4o يبدأ طرح الميزة في ChatGPT مجانًا اليوم وتقدم ما يصل إلى 5 أضعاف حد الرسائل لمستخدمي Plus.

الآن افتح ChatGPT، نجد أن GPT-4o متاح بالفعل.

عند استخدام GPT-4o، يمكن لمستخدمي ChatGPT المجاني الآن الوصول إلى الميزات التالية: تجربة مستوى الذكاء GPT-4 يمكن للمستخدمين الحصول على استجابات من النماذج والشبكة.

بالإضافة إلى ذلك، يتمتع المستخدمون المجانيون بالخيارات التالية -

تحليل البيانات وإنشاء المخططات:

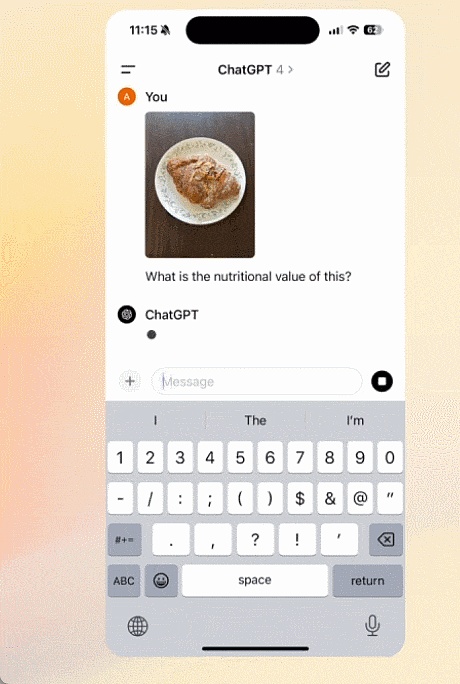

محادثة مع الصور الملتقطة:

p>

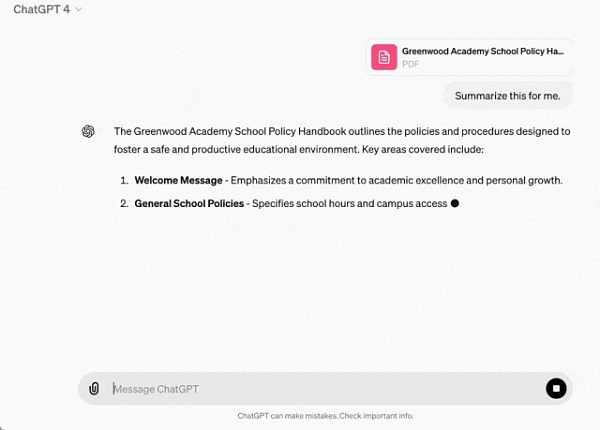

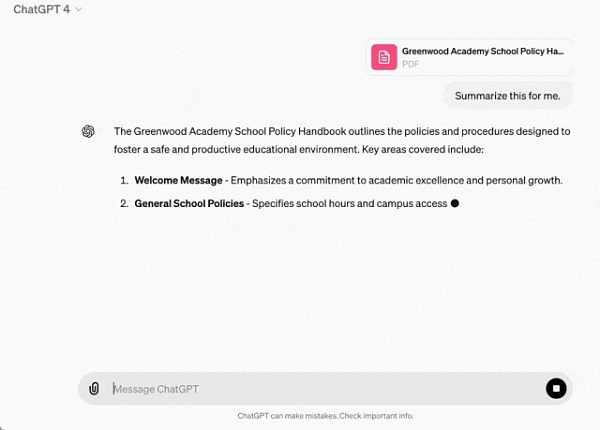

قم بتحميل ملف للمساعدة في التلخيص أو الكتابة أو التحليل:

< p>اكتشف واستخدم متاجر تطبيقات GPT وGPT:

وصمم باستخدام الذاكرة تجربة أكثر فائدة.

ومع ذلك، فإن المستخدمين المجانيين محدودون في عدد الرسائل التي يمكنهم إرسالها باستخدام GPT-4o بناءً على الاستخدام والطلب. عند الوصول إلى الحد الأقصى، سيتحول ChatGPT تلقائيًا إلى GPT-3.5 حتى يتمكن المستخدمون من مواصلة المحادثات.

بالإضافة إلى ذلك، ستطلق OpenAI إصدارًا جديدًا من وضع الكلام GPT-4o alpha في ChatGPT Plus في الأسابيع المقبلة، وستطرح دعم GPT-4o عبر واجهة برمجة التطبيقات لمجموعة صغيرة من الشركاء الموثوقين. المزيد من ميزات الصوت والفيديو الجديدة.

وبالطبع، من خلال اختبارات النماذج والتكرارات المتعددة، فإن GPT-4o لديه بعض القيود في جميع الأوضاع. وسط هذه العيوب، تقول OpenAI إنها تعمل على تحسين GPT-4o.

من المتصور أن فتح وضع الصوت GPT-4o سيؤدي بالتأكيد إلى مخاطر جديدة مختلفة. فيما يتعلق بمسألة الأمان، يتمتع GPT-4o بأمان مدمج في التصميم متعدد الوسائط من خلال تقنيات مثل تصفية بيانات التدريب وتحسين سلوك النموذج بعد التدريب. أنشأت OpenAI أيضًا نظام أمان جديدًا لحماية مخرجات الكلام.

يعمل تطبيق سطح المكتب الجديد على تبسيط سير عمل المستخدم

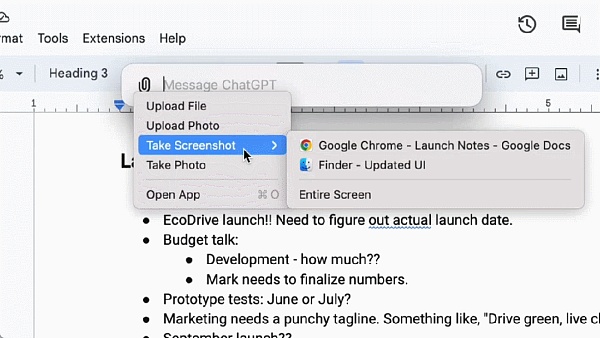

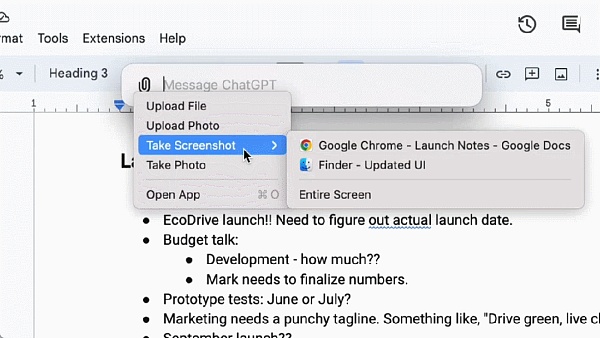

بالنسبة للمستخدمين المجانيين والمدفوعين، تطلق OpenAI أيضًا تطبيق ChatGPT الجديد لسطح المكتب لنظام التشغيل macOS. يمكن للمستخدمين طرح أسئلة على ChatGPT على الفور باستخدام اختصار بسيط للوحة المفاتيح (Option + Space)، بالإضافة إلى أنه يمكنهم التقاط لقطات شاشة ومناقشتها مباشرة داخل التطبيق.

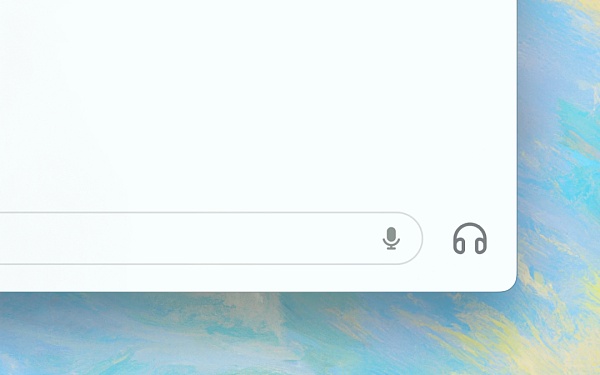

الآن، يمكن للمستخدمين أيضًا إجراء محادثات صوتية مع ChatGPT مباشرة من الكمبيوتر، GPT - ستتوفر ميزات الصوت والفيديو في 4o في المستقبل، ويمكن بدء المحادثات الصوتية من خلال النقر على أيقونة سماعة الرأس في الركن الأيمن السفلي من تطبيق سطح المكتب.

بدءًا من اليوم، ستقوم OpenAI بطرح تطبيقات macOS لمستخدمي Plus، وسيجعل التطبيق متاحًا على نطاق أوسع في الأسابيع المقبلة. بالإضافة إلى ذلك، ستطلق OpenAI إصدار Windows في وقت لاحق من هذا العام.

Ultraman: أنت مفتوح المصدر، ونحن أحرار

بعد الإصدار، ألقى سام ألتمان، الرئيس التنفيذي لشركة OpenAI، خطابًا طال انتظاره في مدونة منشور يصف الرحلة وراء عمل GPT-4o:

في إعلاننا اليوم، أريد التأكيد على أمرين.

أولاً، يتمثل الجزء الأساسي من مهمتنا في إتاحة أدوات الذكاء الاصطناعي القوية للأشخاص مجانًا (أو بسعر مخفض). أنا فخور جدًا بأن أعلن أننا نقدم أفضل الموديلات في العالم في ChatGPT مجانًا، بدون إعلانات أو أي شيء من هذا القبيل.

عندما أسسنا OpenAI، كانت رؤيتنا الأصلية تتمثل في إنشاء ذكاء اصطناعي واستخدامه لإنشاء مجموعة متنوعة من الفوائد للعالم. لقد تغيرت الأمور الآن ويبدو أننا سننشئ ذكاءً اصطناعيًا ومن ثم سيستخدمه الآخرون لإنشاء جميع أنواع الأشياء المذهلة وسنستفيد منه جميعًا.

بالطبع، نحن شركة وسنخترع الكثير من الأشياء مقابل رسوم ستساعدنا في تقديم خدمات ذكاء اصطناعي رائعة ومجانية لمليارات الأشخاص (نأمل).

ثانيًا، تعد أوضاع الصوت والفيديو الجديدة من أفضل واجهات الحوسبة التي استخدمتها على الإطلاق. يبدو الأمر وكأنه ذكاء اصطناعي في فيلم، وما زلت مندهشًا بعض الشيء من أنه حقيقي بالفعل. لقد اتضح أن الوصول إلى أوقات الاستجابة والقدرة على التعبير على مستوى الإنسان يمثل قفزة عملاقة.

ألمح ChatGPT الأصلي إلى إمكانيات واجهات اللغة، وهذا الشيء الجديد (الإصدار GPT-4o) يبدو مختلفًا تمامًا - فهو سريع وذكي وممتع وطبيعي ويمنح الأشخاص المساعدة.

لم يكن التفاعل مع أجهزة الكمبيوتر أمرًا طبيعيًا بالنسبة لي أبدًا، هذه هي الحقيقة. وعندما نضيف القدرة على التخصيص (الاختياري)، والوصول إلى المعلومات الشخصية، وجعل الذكاء الاصطناعي يتخذ إجراءات نيابة عن شخص ما، والمزيد، أستطيع حقًا أن أرى مستقبلًا مثيرًا حيث سنكون قادرين على فعل المزيد باستخدام أجهزة الكمبيوتر أكثر من أي وقت مضى .

وأخيرًا، شكرًا جزيلاً للفريق على جهوده الهائلة في تحقيق ذلك!

ومن الجدير بالذكر أن ألترامان قال في مقابلة الأسبوع الماضي إنه على الرغم من ذلك من الصعب تحقيق الدخل الأساسي العالمي، يمكننا تحقيق "الحوسبة الأساسية العالمية مجانًا". في المستقبل، سيتمتع الجميع بحرية الوصول إلى قوة حوسبة GPT، والتي يمكن استخدامها أو إعادة بيعها أو التبرع بها.

"الفكرة هي أنه عندما يصبح الذكاء الاصطناعي أكثر تقدمًا ومدمجًا في كل جانب من جوانب حياتنا، فإن امتلاك وحدة نموذجية لغوية كبيرة مثل GPT-7 قد يكون أكثر قيمة من المال، وأنت تمتلك جزءًا منه. وأوضح ألتمان "الإنتاجية".

قد يكون إصدار GPT-4o بداية لجهود OpenAI في هذا الصدد.

نعم، هذه مجرد البداية.

أخيرًا، يتعارض مقطع الفيديو "إعلان التخمين في 13 مايو" المعروض على مدونة OpenAI اليوم بشكل شبه كامل مع مقطع فيديو تمهيدي لمؤتمر Google I/O غدًا، وهذا بلا شك صفعة على الوجه من جوجل. أتساءل عما إذا كانت Google تشعر بضغط هائل بعد قراءة إصدار OpenAI اليوم؟

< / ع>

Dante

Dante

< /p>

< /p> < /p>

< /p>