By Kyle_13, Source: author's Twitter @kylewmi

皆さん、本日はお集まりいただきありがとうございます。AOテクノロジーの超エキサイティングな開発の数々を皆さんにお伝えします。まずはデモから始め、ニックと私は、スマートコントラクトの大規模な言語モデルを使用して、これから皆さんがシステムで耳にするおしゃべりな感情に基づいて売買を行うAIエージェントの構築に挑戦します。今日ライブでゼロから構築するので、すべてがうまくいくことを願っています。

そうです、すべて自分たちでやる方法をご覧いただきます。

ここでの技術的な進歩は、AOを他のスマートコントラクトシステムよりはるかにリードしています。これは以前からそうでしたが、今では従来のスマートコントラクトネットワークというより、むしろ分散型スーパーコンピューターのようになってきています。しかし、スマート・コントラクト・ネットワークの特徴をすべて備えています。ですから、このことを皆さんと分かち合えることをとても楽しみにしています。さっそくデモを始めて、ディスカッションをして、一緒にライブで何かを作りましょう。

みなさん、こんにちは。私たちはAOプロトコルに対する3つの大きな技術的アップデートを発表することにとても興奮しています。これらは合わせて、スマートコントラクトの一部として分散環境で実行される大規模な言語モデルをサポートするという大きな目標を達成するものです。これらは単なるおもちゃのモデル、小さなモデル、独自のバイナリにコンパイルされたモデルなどではありません。

これは、現在オープンソースで利用可能な主要モデルのほとんどすべてを実行できる完全なシステムです。例えば、Llama 3はチェーン上のスマートコントラクトで動作し、GPTやAppleのモデルなどもそうです。これはエコシステム全体が協力した結果であり、このシステムの一部を形成する3つの大きな技術的進歩もある。ですから、皆さんにこのすべてをお見せできることをとても楽しみにしています。

全体像は、LLM(大規模言語モデル)がスマートコントラクトで実行できるようになったということです。分散型AIやAI暗号通貨については、おそらく何度も耳にしたことがあるでしょう。実際、今日説明するものを除いて、これらのシステムはほとんどすべて、述語として機能するAIです。つまり、AIをオフチェーンで実行し、実行結果をオンチェーンにして下流で利用するということです。

私たちが話しているのはそのことではありません。私たちが話しているのは、スマートコントラクトのステートフルな実行の一部として、大規模な言語モデルについての推論についてです。これはすべて、私たちが持っているAOハードドライブとAOの超並列処理メカニズムによって可能になったものです。これにより、非常にリッチな分散型自律エージェント金融システムを構築できると考えています。

これまでのところ、分散型金融(Decentralised Finance:DeFi)では、基本的に生の取引の実行をトラストレスにすることができました。貸し出しやスワップなど、さまざまな経済ゲームでのやり取りはトラストレスです。これは問題の一側面に過ぎない。世界の金融市場を考えてみよう。

そう、さまざまな経済原始があり、さまざまな方法で展開されている。債券、株式、コモディティ、デリバティブなどだ。しかし、市場について本当に語るとき、それはこれらだけでなく、実際には知性の層である。売買や貸し借りを決定したり、さまざまな金融ゲームに参加したりするのは人間なのだ。

これまでのところ、分散型金融エコシステムにおいて、私たちはこれらすべてのオリジナルを信頼する必要のない状態に移行させることに成功しています。その結果、Uniswapの運営者を信頼することなく、Uniswap上で交換を行うことができます。実際、基本的に運営者は存在しない。市場のスマートレイヤーはオフチェーンに残されている。そのため、暗号通貨投資に参加したいが、自分ですべての調査や参加をしたくない場合は、ファンドを見つける必要がある。

そのファンドに資金を預け、そのファンドが賢い決断を下流で実行し、ネットワーク自体の基本的な原始的な実行に渡すのです。私たちはAOにおいて、市場のインテリジェントな部分、つまり意思決定につながるインテリジェンスをネットワーク自体に移す能力があると信じています。これを理解する簡単な方法は、想像することかもしれません。

信頼できるヘッジファンドやポートフォリオ管理アプリケーションが、ネットワーク内で一連のインテリジェントな指示を実行し、それによってネットワークの信頼できない性質を意思決定プロセスに移す。つまり、Yolo 420 Trader Number One(大胆でランダムなトレーダー)のような匿名アカウントは、新しい興味深い戦略を作成し、それをネットワークに展開することができます。

現在では、大規模な統計モデルと相互作用する自律エージェントを構築することができます。そして、最も一般的な大規模統計モデルは、テキストを処理して生成する大規模言語モデルです。つまり、斬新なアイデアを持つ誰かが開発した戦略の一部として、これらのモデルをスマートコントラクトに組み込み、ネットワーク上でインテリジェントに実行できるのです。

基本的なセンチメント分析を行うことを想像してみてください。ニュースを読んで、このデリバティブは今が買い時か売り時だと判断したとします。これは、この操作を行うのに良いタイミングだ。人間のような判断を、信用を必要としない方法で実行させることができる。理論だけではない。私たちはLlama Fedという興味深い不換紙幣コインを作りました。基本的には、ラマ(アルパカ)の群れをLlama 3モデルで表現した不換紙幣シミュレーターというアイデアです。

彼らはラマと連邦準備制度理事会の議長を組み合わせたようなもので、彼らのところに行ってトークンの放出を求めることができ、彼らはあなたの要求を評価する。大規模な言語モデルそのものが、完全に自律的に、信頼なしに金融政策を運営している。我々はそれを構築したが、コントロールすることはできない。彼らは金融政策を行い、誰がトークンを得て、誰が得るべきではないかを決定する。これは、この技術の非常に興味深い小さなアプリケーションであり、うまくいけば、エコシステムにおける他のすべての可能なアプリケーションにインスピレーションを与えるだろう。

これを実現するために、私たちはAOのための3つの新しい基本機能を作成する必要がありました。そのうちのいくつかは基本プロトコル層にあり、その他はアプリケーション層にあります。これは大規模な言語モデルの実装に役立つだけでなく、AO開発者にとってはより広範でエキサイティングなものです。というわけで、今日はこれらをご紹介できることを嬉しく思います。

これらの新技術の最初のものは、Web Assemblyの64ビットサポートです。少し技術的な専門用語のように聞こえますが、私は皆のためにそれを理解する方法を持っています。基本的に、Web Assembly 64のサポートにより、開発者は4GB以上のメモリを使用するアプリケーションを作成できるようになります。新しい制限については後ほど説明しますが、かなりすごいものです。もしあなたが開発者でないなら、こう読んでほしい:誰かに本を書くように頼まれ、そのアイデアに興奮したが、100ページしか書けないと言われた。それ以上でもそれ以下でもない。あなたは本の中のアイデアを表現することができますが、外部からの制約があるため、自然で正常な方法でそれを行うことはできません。

スマートコントラクトのエコシステムでは、100ページという制限だけではありません。AOの初期バージョンで構築するようなものです。イーサネットには48KBのメモリ制限があり、誰かが1文しかない本を書けと言うようなもので、最も人気のある英単語は最初の200個しか使えません。このシステムで本当にエキサイティングなアプリを作るのは非常に難しい。

そこで、

このシステムで本当にエキサイティングなアプリを作るのは非常に困難です。

そして、10MBのワーキングメモリにアクセスできるSolanaがあります。ICP(インターネット・コンピュータ・プロトコル)は、3GBのメモリをサポートすることができます。3GBのRAMがあれば、さまざまなアプリを実行することができるが、大規模なAIアプリを実行することはできない。大量のデータをメインメモリにロードして高速にアクセスする必要がある。これは3GBのRAMでは効率的に行えない。

私たちが今年2月にAOをリリースしたとき、4GBのメモリ制限もありましたが、これは実際にWeb Assembly 32に由来していました。その代わり、プロトコルレベルでのメモリ制限は18EB(エビッツ)です。これは膨大なメモリ量です。

これが長期記憶メディアではなく、メモリ上の計算に使われるようになるまでは、かなりの時間がかかるでしょう。実装レベルでは、現在16GBのメモリにアクセスできるAOネットワークのコンピュートユニットは、将来的にプロトコルを変更することなく、より大容量のものに置き換えることは比較的容易でしょう。16GBはすでに大規模な言語モデル計算を実行するのに十分な容量であり、今日AO上で16GBのモデルをダウンロードして実行できることを意味します。例えば、Llama 3の未定量版Falcon 3や他の多くのモデルです。

これは、スマートな言語ベースコンピューティングシステムを構築するために必要なコアコンポーネントです。現在、スマートコントラクトの一部としてオンチェーンで完全にサポートされており、これは非常にエキサイティングなことだと考えています。

これにより、AOとそれに続くスマートコントラクトシステムの主要な計算上の制限の1つが取り除かれました。今年の2月にAOをリリースしたとき、ビデオで何度も無制限の計算能力があると述べたことにお気づきかもしれませんが、4GBのRAMを超えることはできないという制限がありました。これはその制限の解除です。16GBあれば、今日のAIで実行したいほとんどすべてのモデルを実行するには十分すぎるほどです。

プロトコルを変更することなく16GBの上限を引き上げることができましたが、これは将来的には比較的簡単にできるようになるでしょう。そのこと自体が、システム能力の大きな進歩なのです。大規模な言語モデルをAO上で実行できるようにする2つ目の主要技術は、WeaveDriveです。

WeaveDriveにより、AO内部のArweaveデータに、あたかもローカルハードディスクのようにアクセスすることができます。つまり、スケジューリングユニットによって認証されたAO内のトランザクションIDを開き、ネットワークにアップロードすることができます。もちろん、ローカルハードディスク上のファイルのように、このデータにアクセスしてアプリケーションに読み込むこともできます。

現在、Arweaveには約60億件のトランザクションが保存されていることは周知の通りです。また、このデータはAOプログラムでも使用できるため、今後アプリケーションを構築する際に、Arweaveにデータをアップロードするモチベーションが高まることを意味します。例えば、Arweave上で大規模な言語モデルを動作させたとき、およそ1000ドル相当のモデルをウェブにアップロードしました。しかし、それはほんの始まりに過ぎません。

ローカルのファイルシステム上にスマートコントラクトのネットワークがあれば、構築できるアプリケーションの数は膨大になります。だからとてもエキサイティングだ。さらに良いことに、私たちが構築したシステムでは、実行環境にデータをストリームすることができます。技術的なニュアンスですが、本の例えに戻って想像してみてください。

誰かがあなたに、あなたの本の中のデータにアクセスしたいと言いました。この本の中のグラフにアクセスしたい。単純なシステムであれば、あるいは現在のスマートコントラクトのネットワークであっても、これは大きな前進であり、あなたは本全体を提供することになる。しかしこれは明らかに非効率であり、特にその本が何千ページもある大規模な統計モデルである場合はなおさらです。

これは極めて非効率的です。その代わり、AOではバイトを直接読めるようにしています。本の中のチャートの場所に直接行き、チャートをアプリケーションにコピーして実行するだけです。これにより、システムはより効率的になる。これは単なるMVP(ミニマム・ヴィアブル・プロダクト)ではなく、完全に機能する、よくできたデータ・アクセス・メカニズムなのだ。つまり、無限のコンピューティングシステムと無限のハードドライブがあり、それらを組み合わせれば、スーパーコンピューターの完成です。

これはこれまで構築されたことがなく、今、最小限のコストで誰もが利用できる。AOは今そこにあり、我々は非常に興奮している。システムの実装もOSレベルです。WeaveDriveはAOのサブプロトコルであり、誰でもロードできるコンピュート・ユニットの拡張機能です。この種の拡張機能としては初めてなので、興味深いですね。

AOには常に、実行環境に拡張機能を追加する機能があります。ちょうどコンピュータを持っていて、より多くのメモリを差し込んだり、グラフィックカードを差し込んだりしたいように、物理的にユニットをシステムに入れるのです。AOの演算ユニットに対してこの操作を行うことができる。つまり、オペレーティングシステムレベルでは、データストレージ用のファイルシステムを表すだけのハードドライブがあるわけです。

つまり、通常の方法でアプリケーションを構築するためにAO内のこのデータにアクセスできるだけでなく、ネットワーク上に持ってきたどのアプリケーションからも実際にアクセスできるということです。つまり、Rust、C、Lure、Solidityなど、どの言語で書いているかに関係なく、システムでビルドしているすべての人が、システムネイティブのようにアクセスできる、広く適用可能な機能なのです。このシステムを構築するにあたり、将来的に他の人たちもエキサイティングなものを構築できるように、サブプロトコルのプロトコルや、他のコンピュートユニットの拡張を作成する方法を作成することも余儀なくされました。

任意サイズのメモリセットで計算を実行し、ネットワークからAO内のプロセスにデータをロードする能力を得た今、次に問われるのは推論そのものをどのように行うかということです。

主要な仮想マシンとしてWeb Assembly上でAOを構築することを選択したため、その環境で既存のコードをコンパイルして実行することは比較的簡単でした。私たちはWeaveDriveをOSレベルのファイルシステムとして公開するように構築したので、システム上でLlama.cpp(オープンソースの大規模言語モデル推論エンジン)を実行することは、実際には比較的簡単でした。

これは非常にエキサイティングなことで、この推論エンジンだけでなく、他の多くの推論エンジンも簡単に実行できることを意味します。したがって、ラージ・ランゲージ・モデルをAO内で動作させるための最後のコンポーネントは、ラージ・ランゲージ・モデル推論エンジンそのものである。私たちはLlama.cppと呼ばれるシステムを移植しました。これは少し不可解に聞こえますが、実際には現在の主要なオープンソースのモデル実行環境です。

AOスマートコントラクト内で直接実行するのは、システム内に任意の量のデータを持ち、Arweaveから任意の量のデータをロードできるようになれば、実際には比較的簡単でした。

そのために、私たちはSIMD(Single Instruction Multiple Data)コンピュートエクステンションと呼ばれるものにも取り組みました。そのため、これも有効にしました。つまり、現在これらのモデルはCPU上で動作していますが、かなり高速です。非同期コンピューティングがあれば、あなたの使用シナリオに合うはずだ。ニュースのシグナルを読み、どの取引を執行するかを決定するようなことは、現在のシステムで十分に実行できます。しかし、GPUを使って大規模な言語モデルの推論を加速させるなど、他の高速化メカニズムに関しても、近々お話しする予定ですが、エキサイティングなアップグレードがあります。

Llama.cppは、Metaの代表的なモデルであるLlama 3だけでなく、他の多くのモデルをロードすることができます。モデリングシステム、その他多数。ハードドライブを使って、Arweaveからシステムで動かしたいモデルをアップロードできるフレームワークができたわけだ。アップロードしたモデルは通常のデータで、AOのプロセスにロードして実行し、結果を得て、好きなように作業することができます。私たちはこれを、これまでのスマート・コントラクト・エコシステムでは不可能だったアプリケーションを可能にするパッケージだと考えています。仮に今それが可能だとしても、Solanaのような既存のシステムで行われるアーキテクチャ変更の数は予測不可能で、彼らのロードマップにはありません。基本的なアイデアは、メタラマ3モデルであるという意味でも、現時点でのFRB議長であるという意味でも、ラマであるFRBメンバーからなる委員会を用意するということだ。アラン・グリーンスパンやFRB議長のように。

また、アラン・グリーンスパンやFRB議長のようなラマであることも伝えます。

この環境はご存知の方もいらっしゃると思いますが、実はGatherのようなもので、今日私たちが取り組んでいるものです。あなたがArweaveトークンやwARトークン(AOXチームが提供)を燃やすと、彼らはあなたの提案が良いと思うかどうかに基づいてトークンをくれます。つまり、完全に自律的でインテリジェントな通貨政策を持つファンコインなのだ。単純なインテリジェンスの形だが、それでも面白い。あなたの提案と他の人の提案を評価し、金融政策を実行する。ニュースの見出しを分析し、賢い決断を下したり、カスタマーサポートと対話し、価値を返したりすることで、エリオットがこれからお見せするように、これらすべてがスマートコントラクト内で可能になる。

こんにちは。

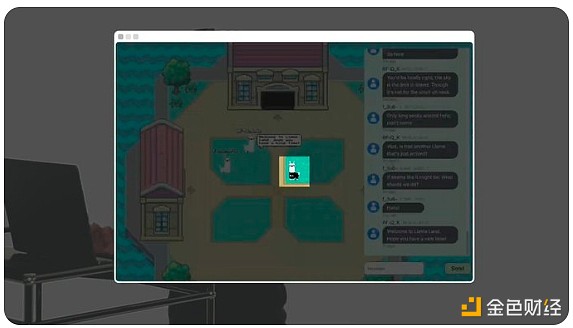

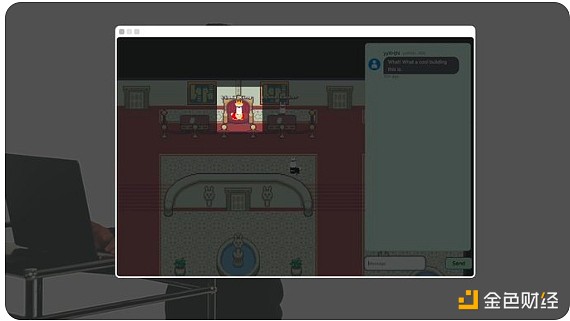

みなさんこんにちは、エリオットです。今日はMetaのオープンソースLlama 3モデルで動く、AO内で動くチェーン上の自律ワールド、Llama Landをお見せします。

例えばこのラマは人間です。

。

。

しかし、このラマはAIにつながれている。

この建物にはラマ連邦準備銀行がある。

Llama fedは世界初のAI主導の金融政策を実行し、ラマ・トークンを鋳造する。

Llama fedは世界初のAI主導の金融政策を行っており、ラマ・トークンを鋳造しています。

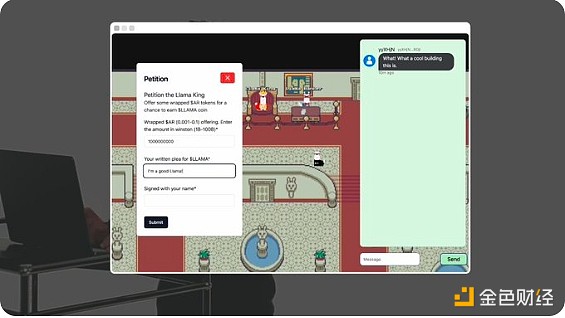

こいつはキングラマだ。あなたは彼にArweaveトークン(wAR)を包んで差し出し、Llamaトークンを得るために依頼を書くことができます。

ラマ王です。

ラマキングのAIがラマ・トークンを授与するかどうかを評価し、決定します。Llamafedの通貨政策は完全に自律的で、人間の監視はありません。Llamafedの通貨政策は完全に自律的で、人間の監視はありません。世界中のすべてのエージェントとすべての部屋自体が、AO上のオンチェーンプロセスです。

ラマ王がトークンをくれたようだ。ArConnectウォレットを見ると、すでにトークンがある。ラマランドはAOに実装される最初のAI主導の世界に過ぎない。これは新しいプロトコルのフレームワークで、誰でも自律的な世界を構築することができる。このすべては100%オンチェーンで実装されており、AOでのみ可能です。

ありがとうエリオット。あなたは、金融決定に参加し、自律的な金融政策システムを実行している大規模な言語モデル以上のものを見ただけです。バックドアもなく、私たちがコントロールすることもできません。また、小さな宇宙、つまり物理的な空間を歩くことができ、その場所に行って金融インフラと相互作用することができる場所を目の当たりにしていることでしょう。私たちは、これは単なる楽しい小さなデモ以上のものだと考えています。

ここには実に興味深いものがあり、金融商品を利用するさまざまな人々が集まる場所がある。DeFiのエコシステムでは、誰かがあるプロジェクトに参加したいと思ったら、まずツイッターでチェックし、それからウェブサイトを訪れて、ゲームの基本的な元ネタに参加する、ということを見てきました。

それから、プロジェクトに参加したいと思う。

その後、TelegramグループやDiscordチャンネルに参加したり、Twitterで他のユーザーと話したりする。体験は非常に分散化されており、私たちは皆、アプリ間を飛び回っている。私たちが試している面白いアイデアのひとつは、これらのDeFiアプリのユーザーインターフェイスがあれば、コミュニティが集まってこの自律的な空間を共同管理することができるというものです。

オークションハウスのような場所に行って、そのプロトコルに参加している他のユーザーと一緒に集まってチャットすることを想像してみてください。基本的には、AOでFMMプロセスのアクティビティが起こっているときに、他のユーザーとチャットすることができます。コミュニティと社交的な側面は、製品の金融的な部分と組み合わされています。

私たちは、これは非常に興味深く、さらに広い意味を持っていると考えています。このArweaveの世界を歩き回り、見つけたさまざまなアプリやユーザーと交流する自律的なAIエージェントを作ることができます。メタバースを構築する場合、オンラインゲームを作るときに最初にすることの1つは、NPC(ノンプレイヤーキャラクター)を作ることです。ここで、NPCは一般的なものにすることができます。

徘徊して環境と相互作用するインテリジェントなシステムがあるので、ユーザーのコールドスタート問題はありません。普通のDeFiユーザーのように、自分でお金を稼ごうとしたり、友達を作ろうとしたり、環境と対話したりする自律エージェントができるかもしれません。少々奇妙ではあるが、とても興味深いことだと思う。私たちは、何が起こるか様子を見守りたいと思います。

先を見据えて、AOで大規模な言語モデルの実行を加速させる機会もあると考えています。先ほど、計算ユニットのスケーリングという概念についてお話ししました。これはWeaveDriveを構築するために使用したものです。

WeaveDriveだけにとどまらず、AOのコンピューティング環境のためにあらゆる種類の拡張機能を構築することができます。GPU加速による大規模言語モデル実行のためにこの問題を解決している非常にエキサイティングなエコプロジェクトの1つが、Apus Networkです。

こんにちは。

こんにちは、マテオです。今日は、分散型の信頼できるGPUネットワークを構築するApus Networkを紹介します。

私たちは、Arweaveの永続的なオンチェーンストレージを活用し、GPUに決定論的な実行環境を提供することで、オープンソースのAO拡張機能を提供しています。とAOの両方で最適なモデル学習を競争的に実行します。これにより、ユーザーは最高のAIモデルを最も費用対効果の高い価格で利用できるようになります。X(ツイッター)@apus_networkで私たちの進捗を追うことができます。ありがとう。

これが今日のAOのAIの現状です。Llama Fedを試して、大規模な言語モデルに基づいて独自のスマートコントラクトアプリケーションを構築してみることができます。私たちはこれを、分散型実行環境にマーケットインテリジェンスを導入する始まりだと考えています。私たちはこのことに非常に興奮しており、次に何が起こるか楽しみにしています。本日はありがとうございました。

JinseFinance

JinseFinance

JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance JinseFinance

JinseFinance