パフォーマンス(待ち時間、計算時間)

サポートされるモデル

検証可能性

- 価格(チェーン消費コスト、推論コスト)

開発経験

3.1ゴール

理想的には、開発者は、統合プロセスにほとんど支障をきたすことなく、どこからでも、どのような証明形式でも、カスタムAI推論サービスに簡単にアクセスできるようになります。

推論ネットワークは、オンデマンドでの証明の生成と検証、推論計算の実行、推論データの中継と検証、Web2およびWeb3へのインターフェースの提供、ワンクリックでのモデル展開、システム監視、クロスチェーン操作、同期された統合、時間指定された実行など、開発者が必要とするすべての基本的なサポートを提供します。

ソース: IOSG。 Ventures

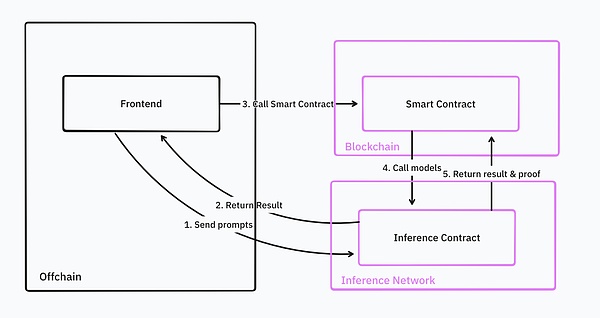

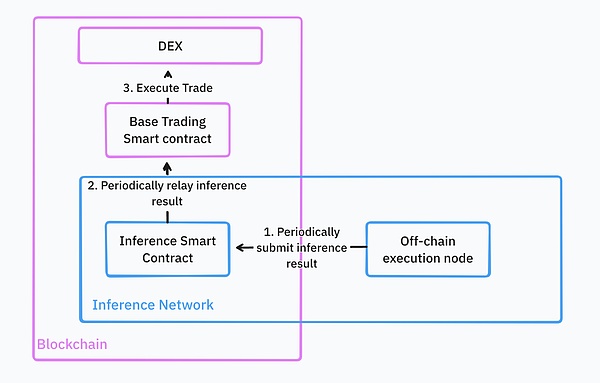

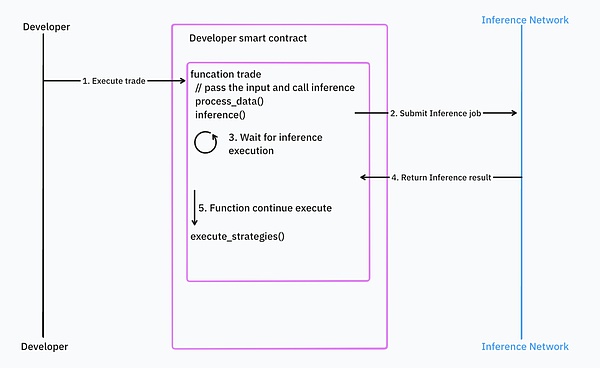

これらの機能により、開発者は推論サービスを既存のスマートコントラクトにシームレスに統合することができます。例えば、DeFi取引ボットを構築する場合、これらのボットは機械学習モデルを使用して、特定のペアの売買タイミングを見つけ、基礎となる取引プラットフォーム上で対応する取引戦略を実行します。

完全に理想的な世界では、インフラはすべてクラウドホスティングされます。開発者は取引戦略モデルをtorchのような一般的なフォーマットでアップロードするだけで、推論ネットワークはWeb2やWeb3のクエリ用にモデルを保存し、提供します。

すべてのモデル展開ステップが完了した後、開発者はWeb3 APIまたはスマートコントラクトを通じて直接モデル推論を呼び出すことができます。推論ネットワークはこれらの取引戦略を継続的に実行し、その結果を基礎となるスマート・コントラクトにフィードバックする。開発者が大量のコミュニティ資金を管理する場合、推論結果の検証を提供する必要もある。推論結果を受け取ると、スマートコントラクトはその結果に基づいて取引を行う。

ソース: IOSG Ventures

3.1.1 Asynchronous vs. Synchronous

理論的には、非同期の推論操作はパフォーマンスが向上します。理論的には、非同期推論操作はより良いパフォーマンスにつながります。

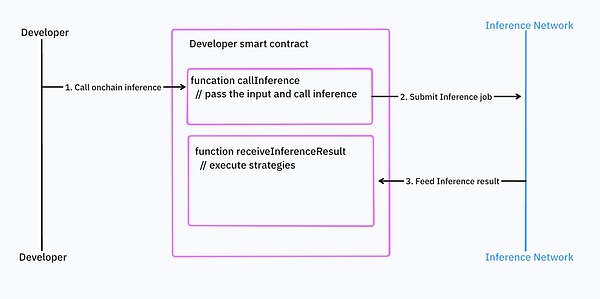

非同期アプローチを使用する場合、開発者は最初に推論ネットワークのスマートコントラクトにタスクを提出する必要があります。推論タスクが完了すると、推論ネットワークのスマートコントラクトは結果を返します。このプログラミングモデルでは、ロジックは推論呼び出しと推論結果処理の2つに分けられる。

ソース: IOSG Ventures

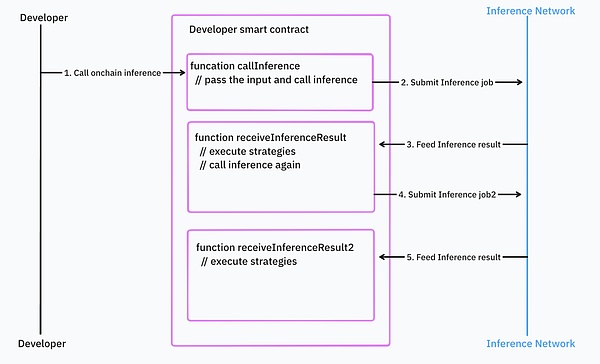

開発者が推論呼び出しを入れ子にして、制御ロジックをたくさん持っていると、さらに悪化します。

ソース: IOSG。 Ventures

非同期プログラミングモデルは、既存のスマートコントラクトとの統合を難しくしている。開発者は、エラー処理や依存関係の管理で多くの余分なコードを書く必要があります。

対照的に、同期プログラミングは開発者にとってより直感的ですが、応答時間やブロックチェーンの設計に問題が生じます。例えば、入力データがブロック時間や価格のように動きの速いものである場合、推論が完了した後のデータはもはや新鮮ではなく、特定の状況でスマートコントラクトの実行をロールバックする必要性につながる可能性がある。古い価格で取引を行ったとします。

ソース: IOSG Ventures

ほとんどのAIインフラは非同期処理を使用していますが、Valenceはこれらの問題に対処しようとしています。

3.2 Reality

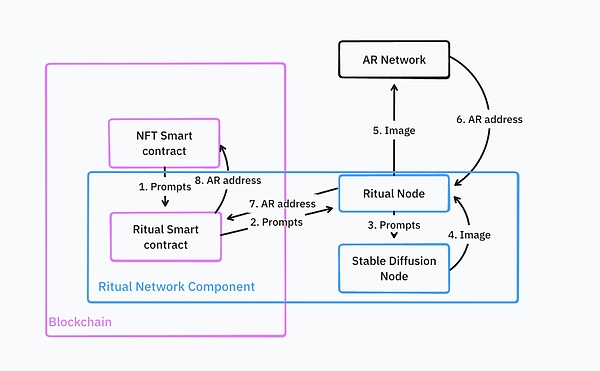

実は、新しい推論ネットワークの多くは、Ritualネットワークなど、まだベータ版です。彼らの公開文書によると、これらのネットワークは、現時点では機能が限られています(検証や証明などの機能はまだ稼働していません)。彼らは現在、オンチェーンでのAI計算をサポートするクラウドインフラを提供する代わりに、セルフホスト型のAI計算とチェーンへの結果配信のためのフレームワークを提供している。

これがAIGCのNFTを実行するアーキテクチャだ。

拡散モデルがNFTを生成し、Arweaveにアップロードします。 推論ネットワークは、このArweaveのアドレスを使用して、NFTをチェーン上にキャストします。

Source: IOSG Ventures

これは非常に複雑なプロセスであり、開発者は、カスタマイズされたサービスを持つRitualノードなど、インフラのほとんどを自分でデプロイし、維持する必要があります。カスタムサービスロジックを持つRitualノード、Stable Diffusionノード、NFTスマートコントラクトなどです。

推奨:現在の推論ネットワークは、カスタムモデルを統合して展開するのが複雑で、現段階では検証をサポートしていないものがほとんどです。AI技術をフロントエンドに適用すれば、開発者にとって比較的シンプルなオプションを提供できるだろう。検証の必要性が高いのであれば、ZKMLプロバイダーのGizaは良い選択です。

4. プロキシ・ネットワーク

5.strong>

プロキシ・ネットワークは、ユーザーがプロキシを簡単にカスタマイズできるようにします。このようなネットワークは、自律的にタスクを実行し、互いに相互運用し、ブロックチェーンネットワークと相互作用することができるエンティティやスマートコントラクトで構成され、すべて人間が直接介入することなく行うことができます。これは主にLLM技術を対象としている。例えば、イーサに関する洞察を提供するGPTチャットボットを提供することができる。このチャットボットには現在、より限定的なツールがあり、開発者はまだそれをベースに複雑なアプリケーションを開発することはできない。

ソース: IOSG Ventures

しかし将来的には、エージェントネットワークは、知識だけでなく、外部APIを呼び出したり、特定のタスクを実行したりする機能など、エージェントが使用できるツールをさらに提供するようになるでしょう。開発者は複数のエージェントを接続してワークフローを構築できるようになる。たとえば、Solidityスマートコントラクトを書くには、プロトコル設計エージェント、Solidity開発エージェント、コードセキュリティレビューエージェント、Solidityデプロイエージェントなど、複数の専門エージェントが必要です。出典: IOSG ベンチャーズ

ヒントとシナリオを使用して、これらのエージェントの協力を編成します。

エージェントネットワークの例としては、Flock.ai、Myshell、Theoriqなどがあります。

推奨:今日のエージェントのほとんどは、比較的限定的です。比較的限られています。

5. エージェントネットワークと推論ネットワークの違い

エージェントネットワークはLLMに重点を置いており、以下のようなツールを提供しています。複数のプロキシを統合するツールなどです。多くの場合、開発者自身が機械学習モデルを開発する必要はない。エージェントネットワークは、モデル開発とデプロイのプロセスを簡素化した。必要なエージェントとツールをリンクさせるだけでよい。ほとんどの場合、エンドユーザーはこれらのエージェントを直接使用する。

一方、推論ネットワークは、エージェントネットワークのインフラ的なバックボーンである。これは開発者により低いレベルのアクセスを提供します。通常、エンドユーザーは推論ネットワークを直接使用することはない。開発者は、LLMに限定されない独自のモデルを展開する必要があり、オフチェーンまたはオンチェーンのアクセスポイントを通じて使用することができます。

プロキシ・ネットワークと推論ネットワークは完全に別の製品というわけではありません。

プロキシ・ネットワークと推論ネットワークは完全に独立した製品ではありません。

エージェント機能と推論機能の両方を提供し、両方の機能が同様のインフラに依存しているからです。

6. A New Land of Opportunity

モデル推論、トレーニング、エージェントネットワークに加えて、ウェブ3の領域には、探索する価値のある多くの新しい分野があります。機械学習に使えるデータセットに変えるには?機械学習の開発者は、より具体的でテーマ性のあるデータを必要としている。例えば、GizaはDeFi上で機械学習のトレーニングに特化した高品質なデータセットを多数提供している。理想を言えば、データは単純な表データにとどまらず、ブロックチェーンの世界での相互作用を描いたグラフデータを含むべきです。現在のところ、この分野では不足している。現在、個人データのプライバシー保護を約束するBagelやSaharaのように、新しいデータセットを作成した個人に報酬を与えることでこれに取り組んでいるプロジェクトもある。

Catherine

Catherine

Catherine

Catherine Anais

Anais Weatherly

Weatherly Catherine

Catherine Kikyo

Kikyo Anais

Anais Catherine

Catherine Weatherly

Weatherly Kikyo

Kikyo Anais

Anais