"Khoảnh khắc USB-C" Trong lịch sử tiến hóa AI, vào tháng 11 năm 2024, giao thức MCP được phát hành bởi nhân học đang gây ra một trận động đất trong Thung lũng Silicon. . Trong khi chúng ta vẫn đang tranh cãi về thang đo tham số của GPT-5, MCP đã lặng lẽ mở đường cho sự phân cấp trong thời đại AGI ...

Công nghiệp và thu nhập? /p> Tài nguyên (mở rộng kiến thức)

Công cụ (thực thi các hàm, gọi các hệ thống bên ngoài)

Lời nhắc (mẫu lời nhắc được viết sẵn)

MCP có thể được phát triển và lưu trữ bởi bất kỳ ai, được cung cấp dưới dạng máy chủ và có thể ngoại tuyến và dừng bất kỳ lúc nào.

02 Tại sao chúng ta cần MCP?

Hiện tại, LLM sử dụng càng nhiều dữ liệu càng tốt để thực hiện một lượng lớn các phép tính và tạo ra một lượng lớn các tham số, tích hợp kiến thức vào mô hình, để đạt được đầu ra đối thoại của kiến thức tương ứng. Tuy nhiên, có một số vấn đề lớn:

Lượng dữ liệu và phép tính lớn đòi hỏi nhiều thời gian và phần cứng, và kiến thức được sử dụng để đào tạo thường đã lỗi thời.

Các mô hình có nhiều tham số rất khó triển khai và sử dụng trên các thiết bị cục bộ, nhưng trên thực tế, người dùng có thể không cần tất cả thông tin để đáp ứng nhu cầu của họ trong hầu hết các trường hợp.

Một số mô hình sử dụng trình thu thập thông tin để đọc thông tin bên ngoài cho các tính toán nhằm đạt được tính kịp thời, nhưng do hạn chế của trình thu thập thông tin và chất lượng dữ liệu bên ngoài, chúng có thể tạo ra nội dung gây hiểu lầm hơn.

Do AI chưa mang lại lợi ích tốt cho người sáng tạo nên nhiều trang web và nội dung đã bắt đầu triển khai các biện pháp chống AI, tạo ra lượng thư rác lớn, dẫn đến chất lượng LLM ngày càng giảm dần.

LLM khó có thể mở rộng sang mọi khía cạnh của các hàm và hoạt động bên ngoài. Ví dụ, nó có thể gọi chính xác giao diện GitHub để triển khai một số hoạt động. Nó sẽ tạo mã theo các tài liệu có thể đã lỗi thời, nhưng không thể đảm bảo thực hiện chính xác.

03 Sự phát triển về mặt kiến trúc của LLM béo và LLM mỏng + MCP

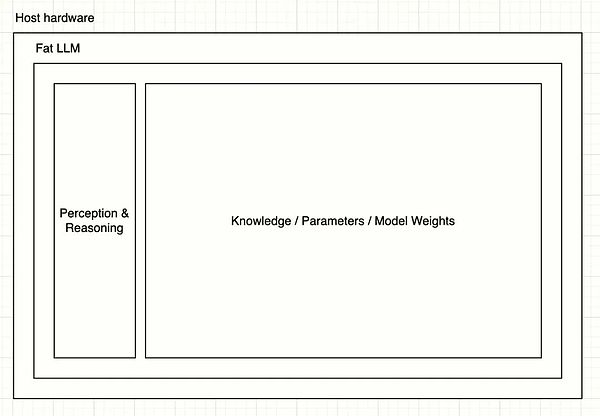

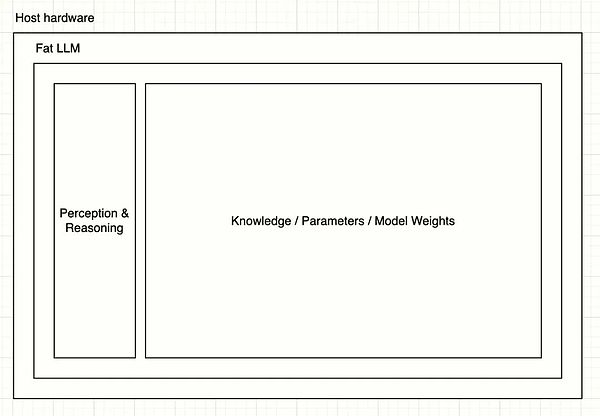

Chúng ta có thể coi mô hình siêu lớn hiện tại là một LLM béo và kiến trúc của nó có thể được biểu diễn bằng sơ đồ đơn giản sau:

Sau khi người dùng nhập thông tin, thông tin đầu vào sẽ được phân tách và suy ra thông qua lớp Nhận thức & Lý luận, sau đó một số lượng lớn tham số được gọi để tạo kết quả.

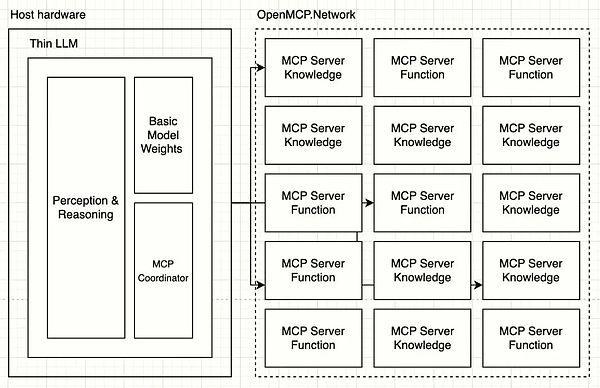

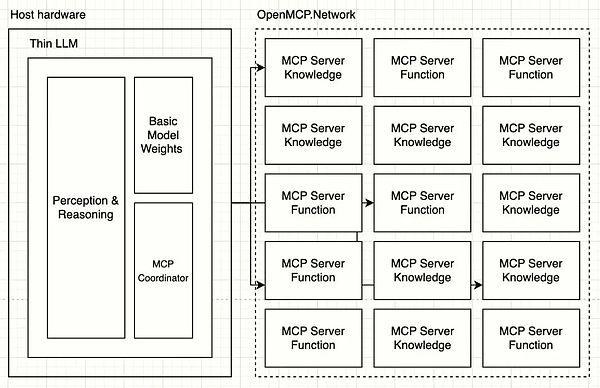

Dựa trên MCP, LLM có thể tập trung vào việc phân tích cú pháp ngôn ngữ, loại bỏ kiến thức và khả năng để trở thành một LLM mỏng:

Theo kiến trúc LLM mỏng, lớp Nhận thức & Lý luận sẽ tập trung vào cách phân tích cú pháp mọi khía cạnh của thông tin môi trường vật lý của con người thành các mã thông báo, bao gồm nhưng không giới hạn ở: giọng nói, âm điệu, mùi, hình ảnh, văn bản, trọng lực, nhiệt độ, v.v., sau đó sử dụng MCP Coordinator để sắp xếp và phối hợp tới hàng trăm Máy chủ MCP để hoàn thành nhiệm vụ. Chi phí đào tạo và tốc độ của LLM mỏng sẽ tăng nhanh chóng và các yêu cầu về thiết bị triển khai sẽ trở nên rất thấp.

04 MCP giải quyết ba vấn đề chính như thế nào?

Làm thế nào để người dân bình thường có thể tham gia vào ngành công nghiệp AI?

Bất kỳ ai có tài năng đặc biệt đều có thể tạo Máy chủ MCP của riêng mình để cung cấp dịch vụ cho LLM. Ví dụ, một người yêu chim có thể cung cấp những ghi chép về loài chim mà mình đã thu thập được trong nhiều năm như một dịch vụ cho thế giới bên ngoài thông qua MCP. Khi ai đó sử dụng LLM để tìm kiếm thông tin liên quan đến loài chim, dịch vụ ghi chú về loài chim MCP hiện tại sẽ được gọi. Người sáng tạo cũng sẽ nhận được một phần doanh thu.

Đây là chu kỳ kinh tế sáng tạo chính xác và tự động hơn. Nội dung dịch vụ được chuẩn hóa hơn và số lượng cuộc gọi và mã thông báo đầu ra có thể được đếm chính xác. Các nhà cung cấp LLM thậm chí có thể gọi nhiều Máy chủ MCP của Bird Notes cùng một lúc để cho phép người dùng lựa chọn và đánh giá nhằm xác định xem ai có chất lượng tốt hơn và nhận được trọng số phù hợp cao hơn.

Sự kết hợp đôi bên cùng có lợi giữa AI và Ethereum

a. Chúng ta có thể xây dựng mạng lưới khuyến khích người sáng tạo OpenMCP.Network dựa trên Ethereum. Máy chủ MCP cần lưu trữ và cung cấp các dịch vụ ổn định. Người dùng trả tiền cho nhà cung cấp LLM và nhà cung cấp LLM phân phối các ưu đãi thực tế cho các Máy chủ MCP được gọi thông qua mạng để duy trì tính bền vững và ổn định của toàn bộ mạng và truyền cảm hứng cho những người sáng tạo MCP tiếp tục tạo và cung cấp nội dung chất lượng cao. Mạng lưới này sẽ cần sử dụng các hợp đồng thông minh để tự động hóa các ưu đãi, minh bạch, đáng tin cậy và chống kiểm duyệt. Chữ ký, xác minh quyền và bảo vệ quyền riêng tư trong quá trình vận hành đều có thể thực hiện được bằng các công nghệ như ví Ethereum và ZK.

b. Phát triển Máy chủ MCP liên quan đến hoạt động chuỗi Ethereum, chẳng hạn như dịch vụ gọi ví AA. Người dùng sẽ có thể triển khai thanh toán ví thông qua ngôn ngữ trong LLM mà không cần tiết lộ khóa riêng và quyền liên quan đến LLM.

c. Ngoài ra còn có nhiều công cụ dành cho nhà phát triển khác nhau giúp đơn giản hóa hơn nữa quá trình phát triển hợp đồng thông minh Ethereum và tạo mã.

Đạt được sự phân cấp AI

a. Máy chủ MCP phân cấp kiến thức và khả năng AI. Bất kỳ ai cũng có thể tạo và lưu trữ Máy chủ MCP, đăng ký trên các nền tảng như OpenMCP.Network và nhận được các ưu đãi dựa trên các cuộc gọi. Không có công ty nào có thể kiểm soát tất cả Máy chủ MCP. Nếu nhà cung cấp LLM đưa ra các ưu đãi không công bằng cho Máy chủ MCP, người sáng tạo sẽ ủng hộ việc chặn công ty đó và người dùng không nhận được kết quả chất lượng sẽ chuyển sang các nhà cung cấp LLM khác để đạt được sự cạnh tranh công bằng hơn.

b. Người sáng tạo có thể triển khai quyền kiểm soát chi tiết trên Máy chủ MCP của riêng họ để bảo vệ quyền riêng tư và bản quyền. Các nhà cung cấp LLM mỏng nên khuyến khích người sáng tạo đóng góp Máy chủ MCP chất lượng cao bằng cách cung cấp các ưu đãi hợp lý.

c. Khoảng cách năng lực của LLM sẽ dần được xóa bỏ, vì ngôn ngữ của con người có giới hạn về phạm vi phổ biến và phát triển rất chậm. Các nhà cung cấp LLM sẽ cần tập trung sự chú ý và tiền bạc vào các Máy chủ MCP chất lượng cao thay vì tái sử dụng nhiều card đồ họa để tạo ra thuốc tiên.

d. Khả năng của AGI sẽ được phân cấp và hạ cấp. LLM sẽ chỉ được sử dụng để xử lý ngôn ngữ và tương tác với người dùng, và các khả năng cụ thể sẽ được phân phối trên nhiều Máy chủ MCP khác nhau. AGI sẽ không gây ra mối đe dọa cho con người vì chỉ có thể giao tiếp bằng ngôn ngữ cơ bản sau khi tắt Máy chủ MCP.

05 Tổng quan

Sự phát triển về mặt kiến trúc của Máy chủ LLM + MCP về cơ bản là sự phân cấp các khả năng của AI, giảm nguy cơ AGI hủy diệt loài người.

Việc sử dụng LLM cho phép đếm và tự động hóa số lượng cuộc gọi và đầu vào và đầu ra của Máy chủ MCP ở cấp độ mã thông báo, đặt nền tảng cho việc xây dựng hệ thống kinh tế sáng tạo AI.

Một hệ thống kinh tế tốt có thể thúc đẩy những người sáng tạo tích cực đóng góp vào việc tạo ra các Máy chủ MCP chất lượng cao, từ đó thúc đẩy sự phát triển của toàn thể nhân loại và đạt được bánh đà tích cực. Những người sáng tạo sẽ không còn chống lại AI nữa, và AI sẽ tạo ra nhiều việc làm và thu nhập hơn, đồng thời phân phối hợp lý lợi nhuận của các công ty thương mại độc quyền như OpenAI.

Hệ thống kinh tế này, kết hợp với các đặc điểm của nó và nhu cầu của người sáng tạo, rất phù hợp để triển khai dựa trên Ethereum.

06 Triển vọng trong tương lai: Bước tiếp theo trong quá trình phát triển của tập lệnh

MCP hoặc các giao thức giống MCP sẽ xuất hiện liên tục và một số công ty lớn sẽ bắt đầu cạnh tranh để định nghĩa các tiêu chuẩn.

LLM dựa trên MCP sẽ xuất hiện, một mô hình nhỏ tập trung vào việc phân tích và xử lý ngôn ngữ của con người, với MCP Coordinator được gắn vào để truy cập mạng MCP. LLM sẽ hỗ trợ việc tự động khám phá và lên lịch cho Máy chủ MCP mà không cần cấu hình thủ công phức tạp.

Các nhà cung cấp dịch vụ mạng MCP sẽ xuất hiện, mỗi nhà cung cấp có hệ thống khuyến khích kinh tế riêng và những người sáng tạo MCP có thể kiếm thu nhập bằng cách đăng ký và lưu trữ máy chủ của riêng họ.

Nếu hệ thống khuyến khích kinh tế của Mạng lưới MCP được xây dựng bằng Ethereum và dựa trên các hợp đồng thông minh, thì các giao dịch của mạng lưới Ethereum sẽ tăng trưởng thận trọng khoảng 150 lần (dựa trên con số thận trọng là 100 triệu cuộc gọi đến Máy chủ MCP mỗi ngày và hiện tại là Khối 12 bao gồm 100 giao dịch).

Catherine

Catherine